GridDB 機能リファレンス

Revision: 5.7.0-932

1 はじめに

1.1 本書の目的と構成

本書では、GridDBの機能について説明します。

本書は、GridDBを用いたシステム設計・開発を行う設計・開発者およびGridDBの運用管理を行う管理者の方を対象としています。

本書は、以下のような構成となっています。

- GridDBとは

- GridDBの特長やGridDBの適用例を説明します。

- GridDBの仕組み

- GridDBのクラスタ動作の仕組みについて説明します。

- GridDBのデータモデル

- GridDBのデータモデルについて説明します。

- GridDBが提供する機能

- GridDBが提供するデータ管理の機能や、運用機能について説明します。

- パラメータ

- GridDBの動作を制御するパラメータについて説明します。

2 GridDBとは

GridDBは、キーと複数の値からなるデータ(ロウと呼ばれる)の集合を管理する、分散NoSQL型データベースです。 データをすべてメモリに配置するインメモリデータベースとしての構成に加え、ディスク(SSDも含む)とメモリの利用を併用したハイブリッド構成も取ることができます。ハイブリッド構成を用いることで、小規模、小メモリシステムでも活用可能です。

GridDBはビッグデータソリューションで必要となる3つのV(Volume,Variety,Velocity)に加え、データの信頼性/可用性を備えています。また、自律的なノード監視と負荷バランシング機能により、クラスタ運用の省力化が実現できます。

2.1 GridDBの特徴

2.1.1 大容量データ(Volume)

システムの規模拡大とともに扱うデータの容量は増大し、大容量データを素早く処理するためにはシステムの拡張が必要になります。

システムの拡張のアプローチには、大きく分けてスケールアップ(垂直スケーラビリティ)とスケールアウト(水平スケーラビリティ)の2つのアプローチがあります。

スケールアップ(垂直スケーラビリティ)とは

動作するマシンへのメモリ追加、ディスクのSSD化、プロセッサの追加などの方法でシステムを増強するアプローチです。一般的に、1つ1つの処理時間を短縮してシステムを高速化するという効果があります。その反面、複数台マシンを用いたクラスタ運用ではないため、スケールアップ時には一旦ノードを停止する必要があり、障害発生時には障害回復に時間がかかるなどの欠点があります。

スケールアウト(水平スケーラビリティ)とは

システムを構成するノードの台数を増やして処理能力を向上させるアプローチです。一般的に、複数のノードを連携して動作させることになるため、メンテナンスや障害発生時でもサービスを完全に停止させる必要がない点が利点となります。その反面、ノード台数が増えるために運用管理の手間が増大するなどの欠点があります。並列度の高い処理を行うのに向いたアーキテクチャです。

GridDBでは、動作するノードをスケールアップしてシステム増強する方法に加え、システムに新たなノードを追加し、稼働するクラスタに組み込むスケールアウトでシステムを拡張することもできます。

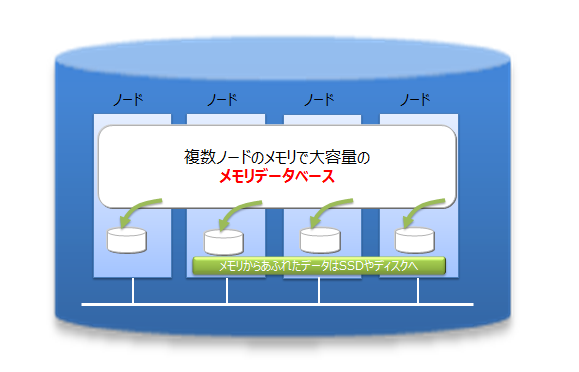

GridDBは、インメモリ処理データベースとしてもスケールアウトモデルで大容量化が可能です。GridDBでは、複数ノードで構成されるクラスタ内のノードにデータを分散配置します。複数ノードのメモリを1つの大きなメモリ空間として利用することで、大規模なメモリデータベースを提供できます。

また、メモリの利用だけでなく、ディスクを併用したハイブリッド構成のデータ管理も可能であるため、単体のノードで動作させた場合も、メモリサイズを超えたデータを保持して、アクセスができます。メモリサイズに制限されない大容量化も実現できます。

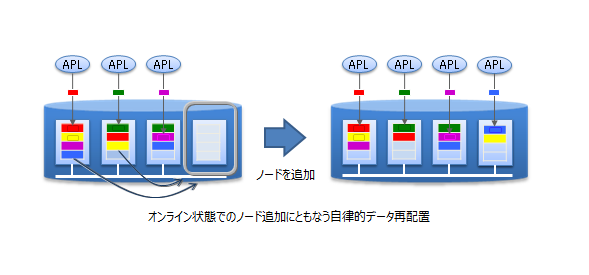

スケールアウトでのシステム拡張は、オンラインで行うことができます。そのため、運用中のシステムを停止することなく、システムの成長とともに増大するデータに対応できます。

スケールアウトでシステムに追加したノードには、システムの負荷に応じて適切にデータが配置されます。GridDBが負荷バランスを最適化するため、運用管理者がデータ配置を気にする必要はありません。このような運用を自動化する仕組みが組み込まれており、運用も容易です。

2.1.2 さまざまなデータ(Variety)

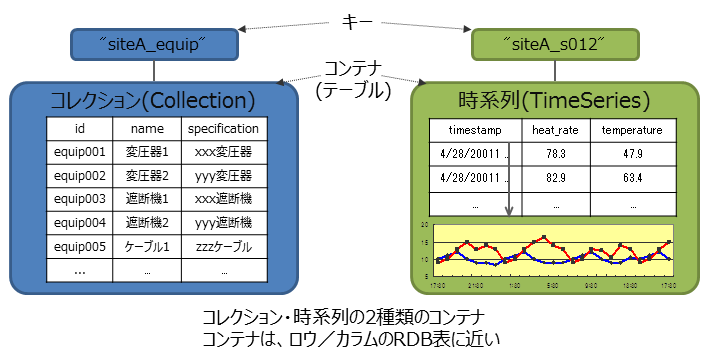

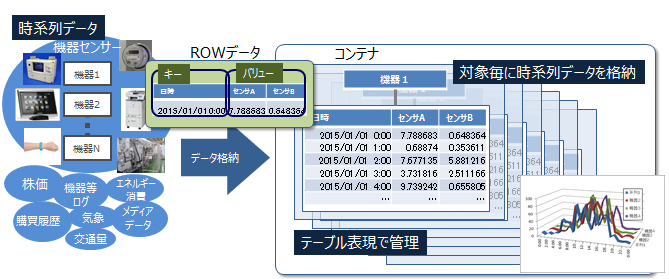

GridDBのデータは、Key-Valueを発展させたKey-Container型のデータモデルです。コンテナというRDBのテーブルに相当する器にデータを格納します。 (コンテナをRDBのテーブルとして考えるとわかりやすいです。)

GridDBのデータアクセスでは、Key-Valueデータベース構造のため、Keyで絞り込みができるモデルが最も高速に処理できます。管理する実体に対応して、キーとなるコンテナを用意するという設計が必要です。

コンテナには、センサ等の時々刻々発生する時間と値のペアになった大量の時系列のデータを扱うのに適したコンテナ(時系列コンテナ)に加え、位置情報などの空間データを登録し、空間固有の演算(空間の交差)を行うこともできます。配列型のデータやBLOBなどの非定型なデータにも対応しているため、さまざまなデータを扱うことができます。

2.1.3 高速処理(Velocity)

GridDBには、さまざまなアーキテクチャ上の工夫が組み込まれ、高速化を実現しています。

2.1.3.1 できるだけメモリ上で処理をする

全てのデータがメモリに配置されてインメモリで動作するシステムの場合、ディスクへのアクセスのオーバヘッドをあまり気にする必要がありません。しかし、メモリ上に保持できないほどの大量のデータを処理するためには、アプリケーションがアクセスするデータを局所化して、ディスクに配置されたデータへのアクセスをできるだけ少なくする必要があります。

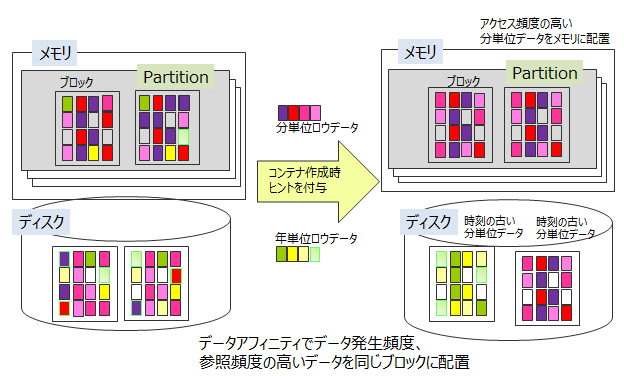

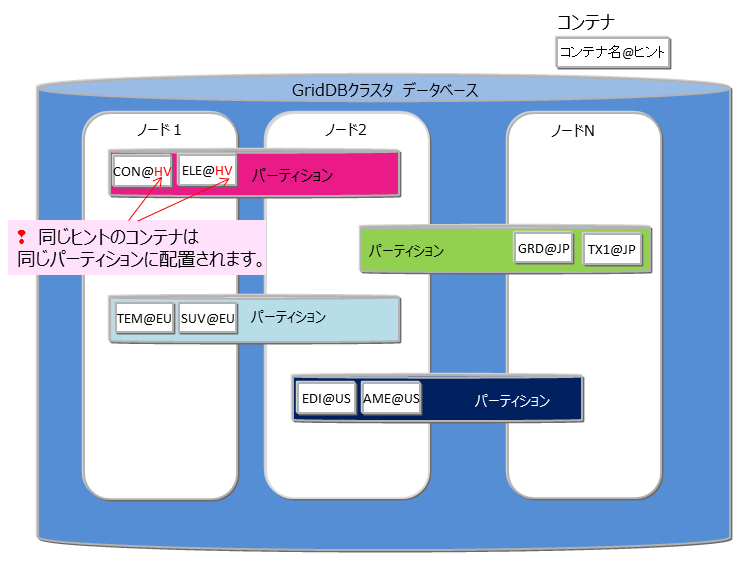

GridDBでは、アプリケーションからのデータアクセスを局所化するために、関連のあるデータをできるだけ同じブロックに配置する機能を提供します。データにヒント情報を与えることで、ヒントに従ったデータブロックにデータを集約し、データアクセス時のメモリ内ヒット率を高め、データアクセス時間を高速化します。アプリケーションでのアクセス頻度やアクセスパターンに応じて、メモリ集約のヒントを設定することで、限られたメモリ領域を有効活用して動作させることができます(アフィニティ機能)。

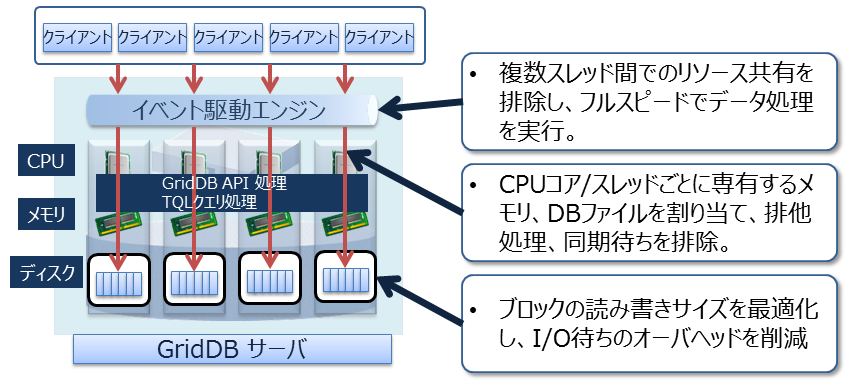

2.1.3.2 オーバヘッドを減らす

データベースに対して並列にアクセスする時のロックやラッチなどによる、データベースの実行処理待ちとなる時間をできるだけ少なくするために、GridDBでは、CPUコア・スレッドごとに占有するメモリとデータベースファイルを割り当て、排他、同期処理の待ちをなくしています。

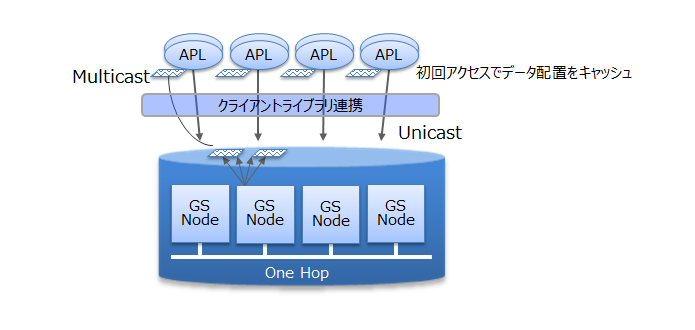

また、GridDBでは、クライアントライブラリ側で初回アクセス時にデータ配置をキャッシュすることで、クライアントとノード間は直接アクセス可能です。データ配置やクラスタの動作状況を管理するマスタノードを介さず、直接目的とするデータにアクセスできるので、マスタノードへのアクセス集中や、通信コストを大幅に削減できます。

2.1.3.3 並列に処理をする

GridDBでは、1つの巨大なデータを複数ノードに分散配置(パーティショニング)したノード間、およびノード内での並列処理と、少ないリソースで多くの要求を処理できるイベント駆動エンジンで、高速化を実現しています。

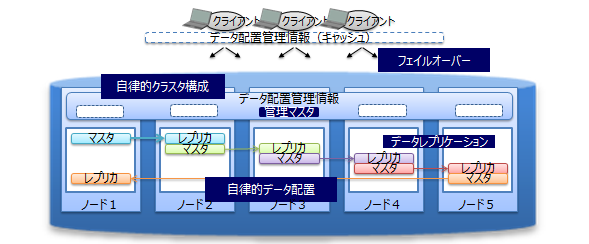

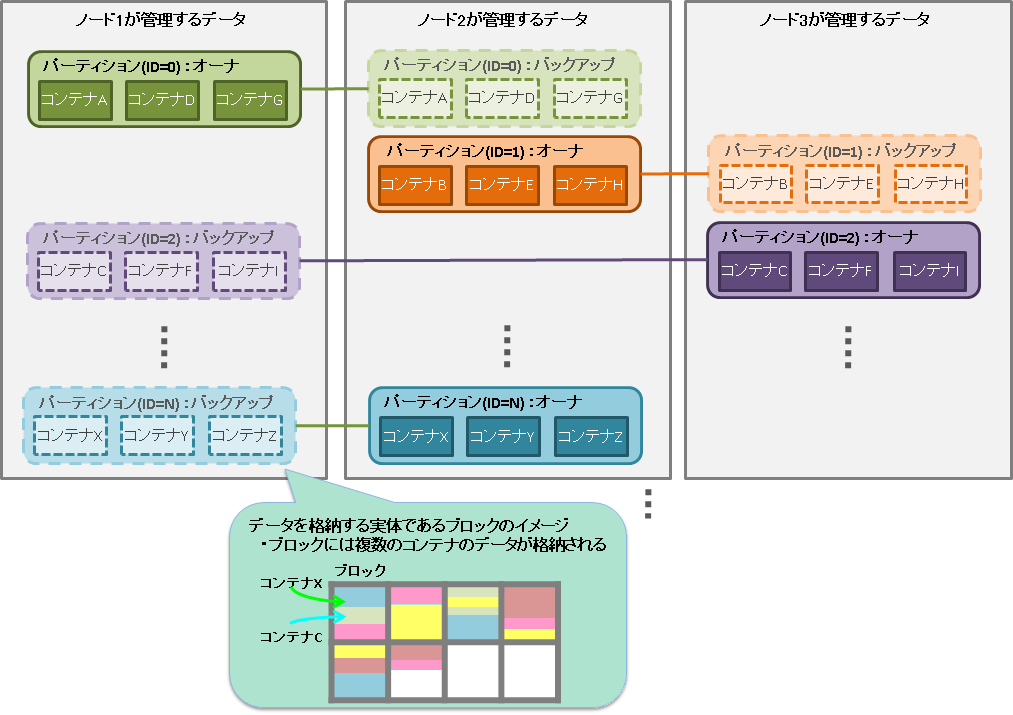

2.1.4 信頼性/可用性

クラスタ内ではデータを複製して、複数のノード上にデータ(レプリカ)を多重配置しています。レプリカの中で、マスタのデータをオーナ、複製したデータをバックアップと呼びます。クラスタを構成するいずれかのノードに障害が発生した場合でも、レプリカを使用することで処理を継続できます。ノード障害発生後のデータ再配置もシステムが自動的に行うため(自律的データ配置)、特別な運用操作は不要です。障害対象のノードに配置されていたデータはレプリカから復旧され、自動的に設定されたレプリカ数となるようにデータは再配置されます。

レプリカは、可用性の要求に応じて2重化、3重化など多重度の設定ができます。

各ノードはディスクを使用してデータ更新情報の永続化を行っています。クラスタシステムに障害が発生しても、ディスクに問題がなければ、それまで登録・更新したデータを失わずに復元することができます。

また、クライアントでもデータ配置管理情報のキャッシュを保有しているため、ノードの障害を検知すると自動的にフェイルオーバーし、レプリカを用いたデータアクセスを継続できます。

2.2 GridDBの製品

GridDBには、以下の製品があります。

- GridDB Enterprise Edition

上記製品はGridDBの特徴で説明した特徴で説明した特徴に加え、以下の2つの特徴を持ちます。

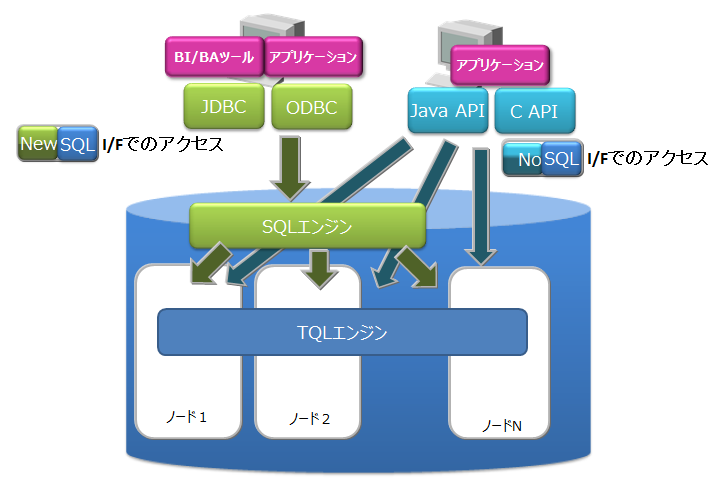

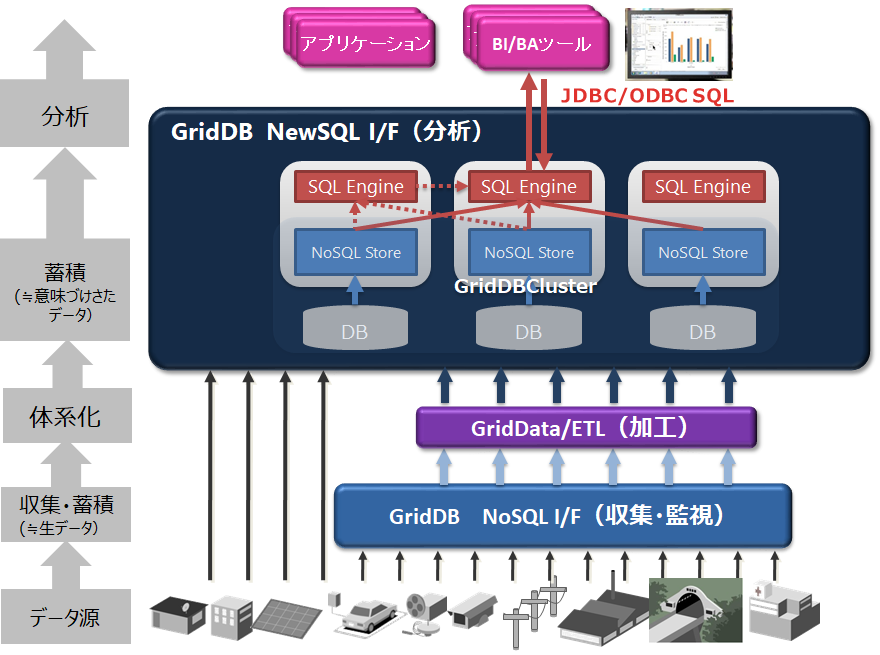

- NewSQL インターフェース

- SQL92に準拠したSQLとともに、標準仕様に準拠したアプリケーションインターフェースであるODBC(C言語インターフェース)とJDBC(Javaインターフェース)を利用できます。

- ODBC/JDBCを利用することで、BI(Business Intelligence)ツールやETL(Extract Transfer Load)ツールからデータベースに直接アクセスすることもできます。

- コンテナをテーブルとみなして操作できます。

- テーブルパーティショニング機能

- 巨大なテーブルを高速にアクセスするためのパーティショニング機能です。

- データを複数の部分に分割し、複数のノードに分散配置するため、テーブルから条件にマッチするデータを検索する処理やデータを取り出す処理の並列化を行い、データアクセスの高速化が実現できます。

各インターフェースの特徴は以下のとおりです。

- NoSQLインターフェース(NoSQL I/F)

- NoSQL I/FのクライアントAPI(C言語、Java)は、ビッグデータを高速に一括処理する機能に重点を置いています。

- データ収集やKey-Valueデータの高速なアクセス、TQLを用いた簡単な集計演算などを行う場合に利用します。

- NewSQLインターフェース(NewSQL I/F)

- NewSQL I/FのODBCやJDBCは、既存アプリケーションとの連携やSQLを用いた開発生産性の向上に重点を置いています。

- BIツールなどを用いて収集したデータを分類し分析する場合に利用します。

GridDBでは、NoSQL I/FとNewSQL I/Fの両方を用途によって使い分けることができます。

同一メジャーバージョン内(マイナーバージョンアップ時)では、GridDBのデータベースおよびNoSQL/NewSQLインターフェースの互換性があります。 バージョンの表記は、以下の通りです。

- GridDBのバージョンは「X.Y[.Z]」で表され、それぞれ以下を表します。

- メジャーバージョン(X): 大幅な機能強化の場合に変更します。

- マイナーバージョン(Y): 機能強化・追加などの場合に変更します。

- リビジョン(Z): 不具合修正などの場合に変更します。

NoSQL I/FとNewSQL I/Fを併用する場合は以下の仕様をあらかじめ理解してください。

- NoSQL I/Fで作成したコンテナは、テーブルとしてNewSQL I/Fで操作できます。 また、NewSQL I/Fで操作したテーブルは、コンテナとしてNoSQL I/Fで操作できます。

- コンテナおよびテーブルの名称は、一意の名称である必要があります。 作成するテーブルと同じ名前のコンテナが既に存在するとエラーになります。

3 用語一覧

GridDBで利用する用語を一覧で解説します。

| 用語 | 意味 |

|---|---|

| ノード | GridDBでデータ管理を行う個々のサーバプロセスを指します。 |

| クラスタ | 一体となってデータ管理を行う、1つ、もしくは複数のノードの集合を指します。 |

| マスタノード | クラスタ管理処理を行うノードです。 |

| フォロワノード | クラスタに参加している、マスタノード以外のノードです。 |

| 構成ノード数 | GridDBクラスタを構成するノード数を指定します。GridDBが初回に起動する際に、クラスタが成立する閾値として用いられます。(構成ノード数のノードがクラスタに参加することでクラスタサービスが開始されます。) |

| 有効ノード数 | GridDBクラスタを構成するノードの内、クラスタに組み込まれた稼働中のノードの数です。 |

| ブロック | ブロックとは、ディスクへのデータ永続化処理(以降、チェックポイントと呼びます)のデータ単位であり、GridDBの物理的なデータ管理の最小単位です。ブロックには複数のコンテナのデータが配置されます。ブロックサイズは、GridDBの初期起動前に定義ファイル(クラスタ定義ファイル)で設定します。 |

| パーティション | コンテナを配置するデータ管理の単位で、データをディスクに永続化する際のファイルシステム上のデータファイルに相当します。1つのパーティションに1つのデータファイルが対応します。また、クラスタ間でのデータ配置の最小単位であり、ノード間の負荷バランスを調整するため(リバランス)や、障害発生時のデータ多重化(レプリカ)管理のためのデータ移動や複製の単位です。 |

| ロウ | コンテナ(テーブル)に登録される1行のデータを指します。コンテナ(テーブル)には複数のロウが登録されます。ロウは、コンテナ(テーブル)のスキーマ定義に対応したカラムの値から構成されます。 |

| コンテナ(テーブル) | ロウの集合を管理する入れ物です。NoSQL I/Fで操作する場合はコンテナ、NewSQL I/Fで操作する場合はテーブルと呼ぶ場合があります。呼び方が異なるだけで、実体は同じオブジェクトです。コンテナには、コレクションと時系列コンテナの2種類のデータタイプが存在します。 |

| コレクション(テーブル) | 一般の型のキーを持つロウを管理するコンテナ(テーブル)の1種です。 |

| 時系列コンテナ(時系列テーブル) | 時刻型のキーを持つロウを管理するコンテナ(テーブル)の1種です。時系列のデータを扱う専用の機能を持ちます。 |

| データベースファイル | クラスタを構成するノードの保有するデータをディスクやSSDに書き込み、永続化したファイル群です。データベースファイルは、データファイル、チェックポイントログファイル、トランザクションログファイルの総称です。 |

| データファイル | パーティションのデータが書き込まれたファイルです。 ノード定義ファイルのサイクル(/checkpoint/checkpointInterval)でメモリ上の更新情報が反映されます。 |

| チェックポイントログファイル | パーティションのブロック管理情報を格納するファイルです。ノード定義ファイルのサイクル(/checkpoint/checkpointInterval)で、ブロック管理情報の書き込みを分割で行います。 |

| トランザクションログファイル | トランザクションの更新情報がログとして逐次保存されるファイルです。 |

| LSN(Log Sequence Number) | パーティションごとに割り当てられる、トランザクションでの更新時の更新ログシーケンス番号です。クラスタ構成のマスタノードは、各ノードが保持している全パーティションのLSNのうちの最大数(MAXLSN)を保持しています。 |

| レプリカ | 複数のノードにパーティションを多重化配置することを指します。レプリカには更新されるマスタデータであるオーナと参照に利用されるバックアップがあります。 |

| オーナノード | パーティション内のコンテナに対して更新操作ができるノードです。複製されたコンテナのうち、マスタとなるコンテナを記録しているノードです。 |

| バックアップノード | 複製されたコンテナのうち、バックアップのためのデータを記録しているノードです。 |

| 定義ファイル | クラスタを構成する際のパラメータファイル(gs_cluster.json:以降クラスタ定義ファイルと呼ぶ)とクラスタ内でのノードの動作やリソースを設定するパラメータファイル(gs_node.json:以降ノード定義ファイルと呼ぶ)の2つがあります。また、GridDBの管理ユーザのユーザ定義ファイルもあります。 |

| イベントログファイル | GridDBサーバのイベントログが保管されるファイルです。エラーや警告などのメッセージが含まれます。 |

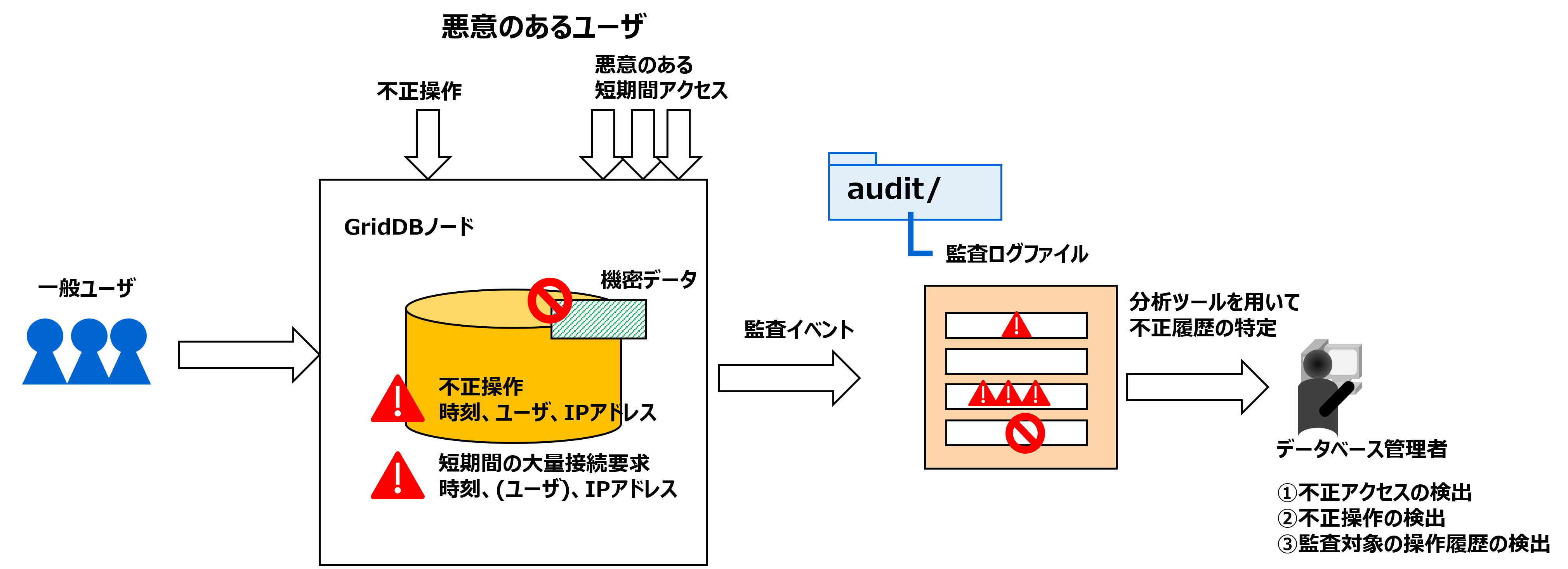

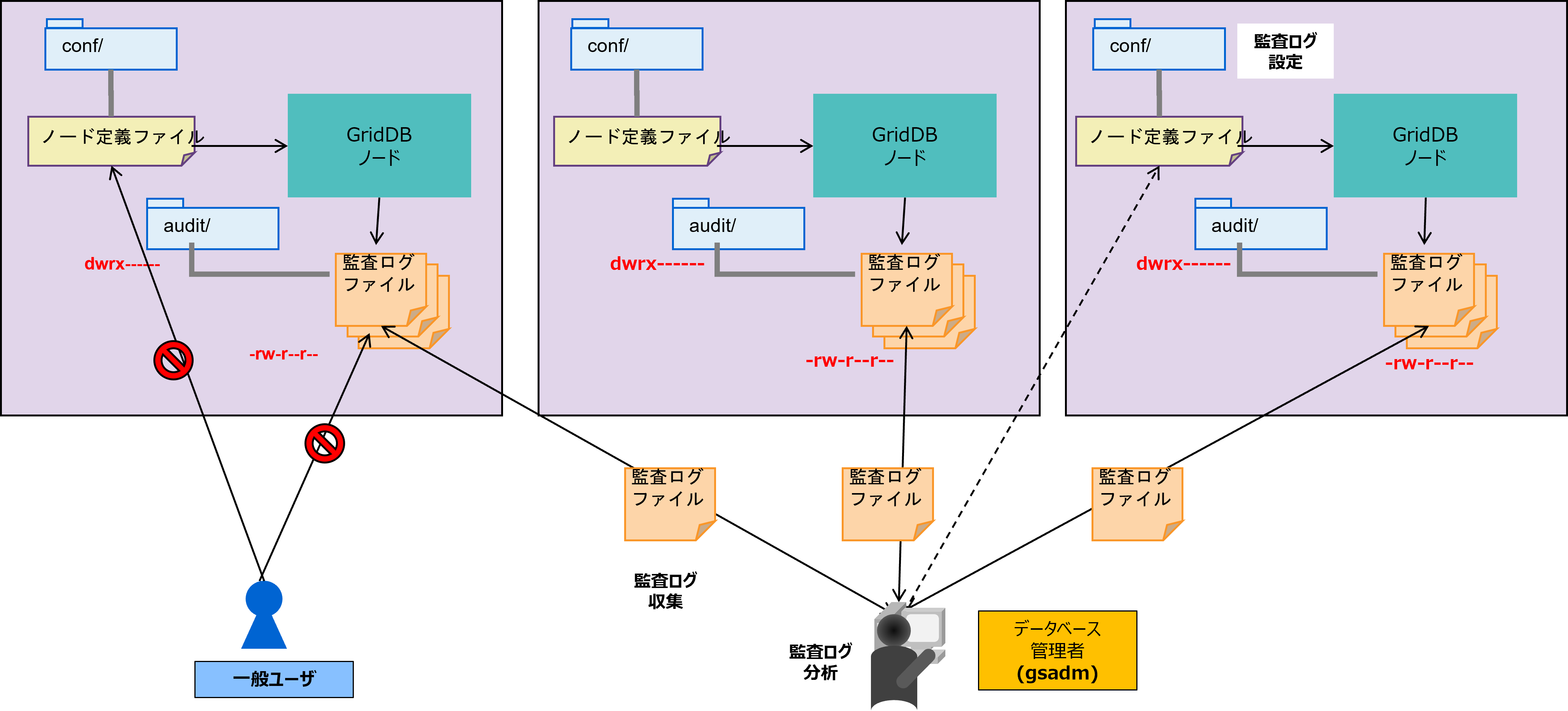

| 監査ログファイル | GridDBサーバの監査ログが保管されるファイルです。 |

| OSユーザ(gsadm) | GridDBの運用機能を実行できる権限を持つユーザです。GridDBインストール時にgsadmというOSのユーザが作成されます。 |

| 管理ユーザ | GridDBの運用操作を行うために用意されたGridDBのユーザです。 |

| 一般ユーザ | アプリケーションシステムで利用するユーザです。 |

| ユーザ定義ファイル | 管理ユーザが登録されるファイルです。初期インストールではsystem,adminの2つの管理ユーザが登録されています。 |

| クラスタデータベース | GridDBのクラスタシステムでアクセスできるデータベース全体を総称します。 |

| データベース | クラスタデータベースに作成される、論理的なデータ管理の単位です。クラスタデータベース内にデフォルトではpublicというデータベースが作成されています。新規にデータベースを作成し、一般ユーザに利用権限をあたえることで、ユーザ毎のデータ分離が実現できます。 |

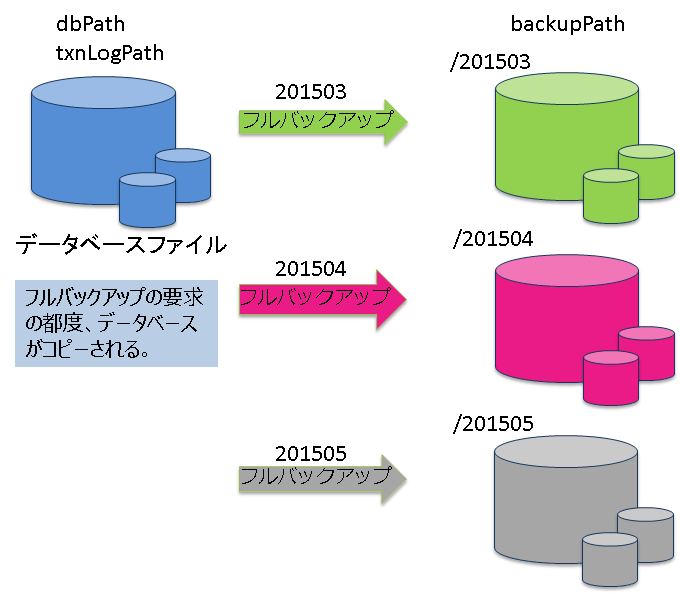

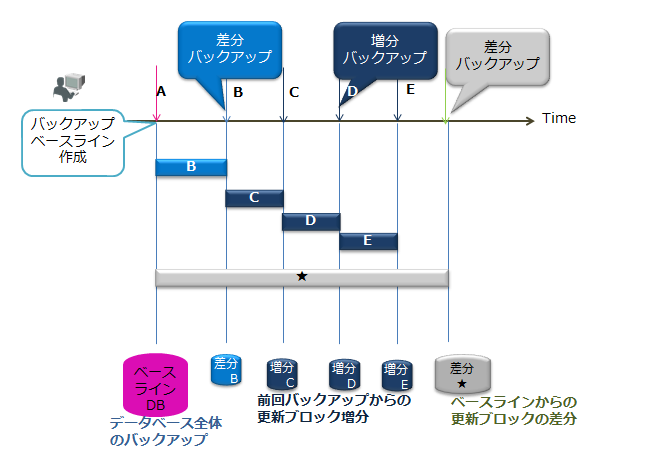

| フルバックアップ | 現在利用中のクラスタデータベースをノード定義ファイルで指定したバックアップディレクトリにオンラインでバックアップします。 |

| 差分・増分バックアップ | 現在利用中のクラスタデータベースをノード定義ファイルで指定したバックアップディレクトリにオンラインでバックアップし、以降のバックアップでは、バックアップ後の更新ブロックの差分増分のみをバックアップします。 |

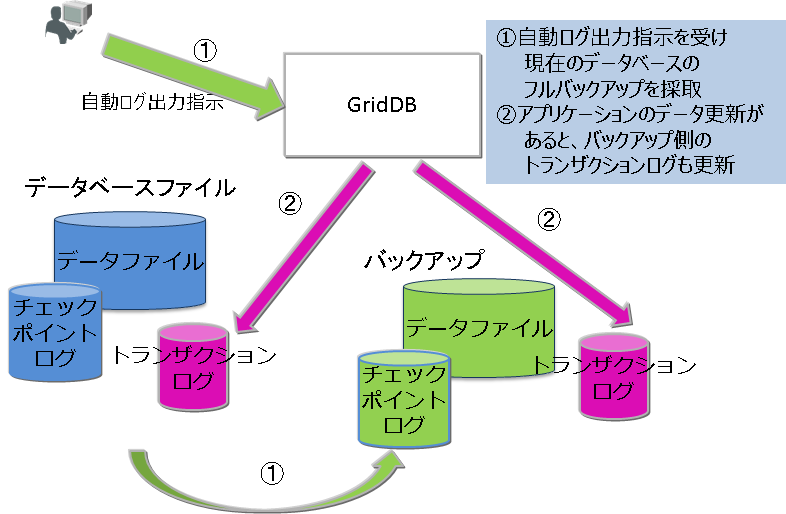

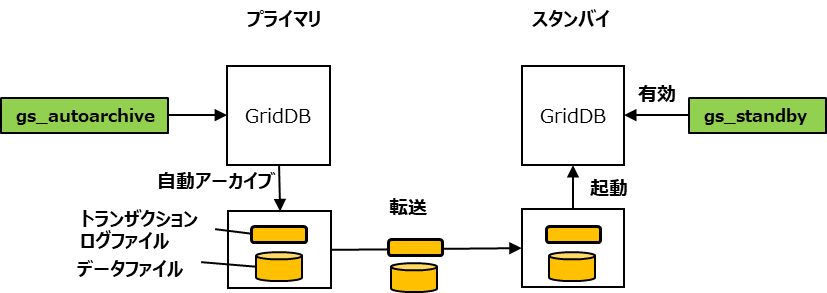

| 自動ログバックアップ | 現在利用中のクラスタデータベースをオンラインで指定したディレクトリにバックアップするとともに、トランザクションログファイルの書き込みと同じタイミングでトランザクションログも自動で採取します。トランザクションログファイルの書き込みタイミングは、ノード定義ファイルの/dataStore/logWriteModeの値に従います。 |

| フェイルオーバ― | 稼働中のクラスタに障害が発生した際に、バックアップノードがその機能を自動的に引き継ぎ、処理を続行する仕組みです。 |

| クライアントフェイルオーバー | 稼働中のクラスタに障害が発生した際、クライアント側のAPIで障害時のリトライ処理としてバックアップノードに自動的に接続し直し、処理を続行する仕組みです。 |

| テーブルパーティショニング | データ登録数が多い巨大なテーブルのデータを複数のノードに分散配置することで、複数ノードのメモリを有効に利用し、かつ複数ノードのプロセッサの並列実行を可能とし、巨大テーブルのアクセスを高速化するための機能です。 |

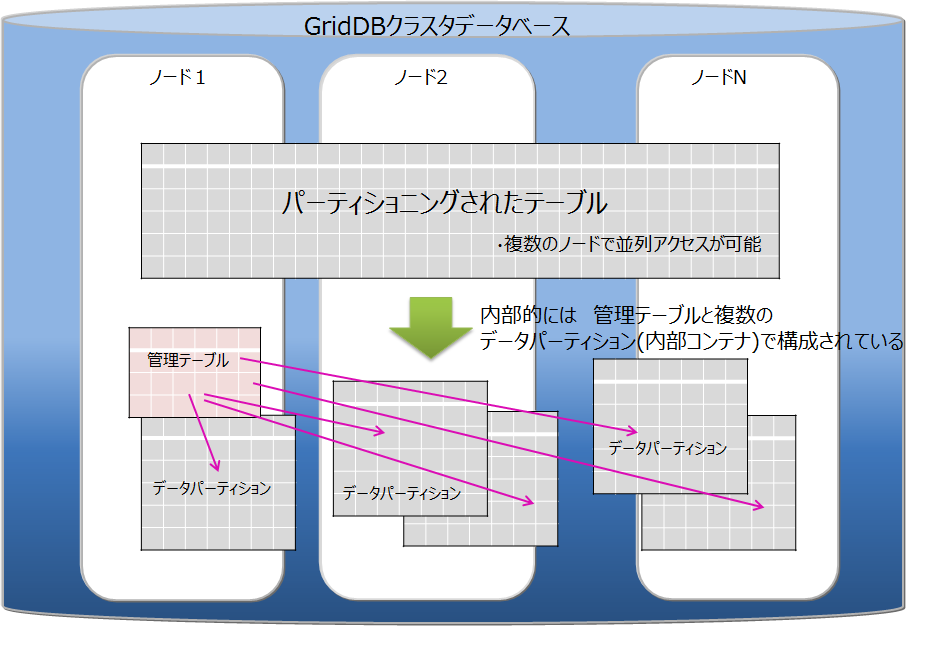

| データパーティション | テーブルパーティショニングによって分割されたデータを格納する入れ物を総称します。テーブルパーティショニングされた1つのテーブルに対して、データパーティションは複数作成されます。データパーティションは、通常のコンテナと同様に各ノードに分散配置されます。データパーティションの数や格納するデータの範囲は、テーブルパーティショニングの種類(ハッシュ、インターバル、インターバル-ハッシュ)によって異なります。 |

| データアフィニティ | 関連の強いコンテナのデータを同じブロックに配置し、データアクセスの局所化を図ることでメモリヒット率を高めるための機能です。 |

| ノードアフィニティ | 関連の強いコンテナを同じノードに配置し、データアクセス時のネットワーク負荷を減少させるための機能です。 |

4 GridDBの仕組み

GridDBのクラスタ動作の仕組みについて説明します。

4.1 クラスタの構成

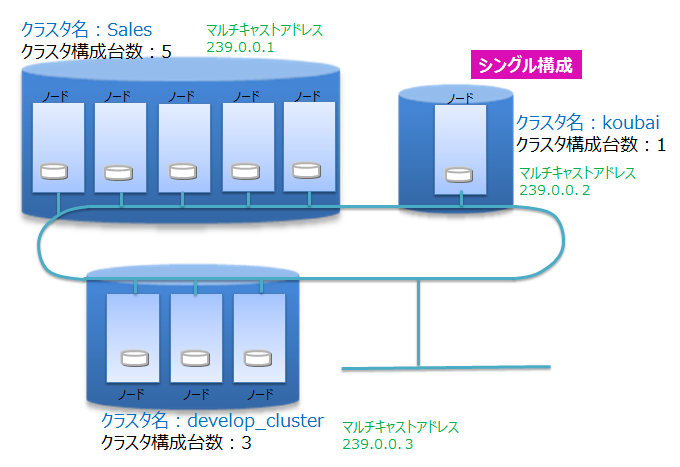

GridDBは複数ノードで構成されるクラスタで動作します。アプリケーションシステムからデータベースにアクセスするにはノードが起動されており、かつクラスタが構成(クラスタサービスが実行)されている必要があります。

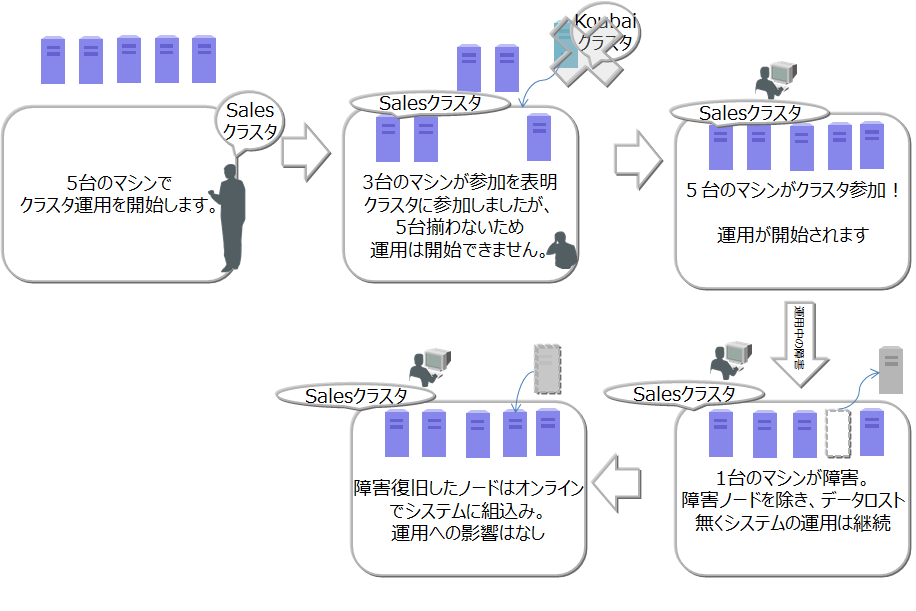

クラスタは、ユーザが指定した構成ノード数のノードがクラスタへ参加することで構成され、クラスタサービスが開始されます。構成ノード数のノードがクラスタに参加するまでクラスタサービスは開始されず、アプリケーションからはアクセスできません。

ノード1台で動作させる場合にも、クラスタを構成する必要があります。この場合構成ノード数を1台でクラスタを構成することになります。ノード1台で動作させる構成をシングル構成と呼びます。

ネットワーク上にあるGridDBの多数のノードを用いて、正しく(意図したノードを用いて)クラスタが構成できるよう、クラスタ名を使って複数のクラスタを区別します。これにより、同じネットワーク上に複数のGridDBクラスタが構成できます。クラスタは、クラスタ名、構成ノード数、接続方式の設定が等しいノードで構成されます。クラスタ名は、クラスタを構成するノード毎に保有するクラスタ定義ファイルに設定するとともに、クラスタ構成する際のパラメータでも指定します。

マルチキャストを用いてクラスタを構成する方式をマルチキャスト方式と呼びます。クラスタ構成方式については、クラスタ構成の検討を参照してください。

以下にクラスタ構成の操作の流れを示します。

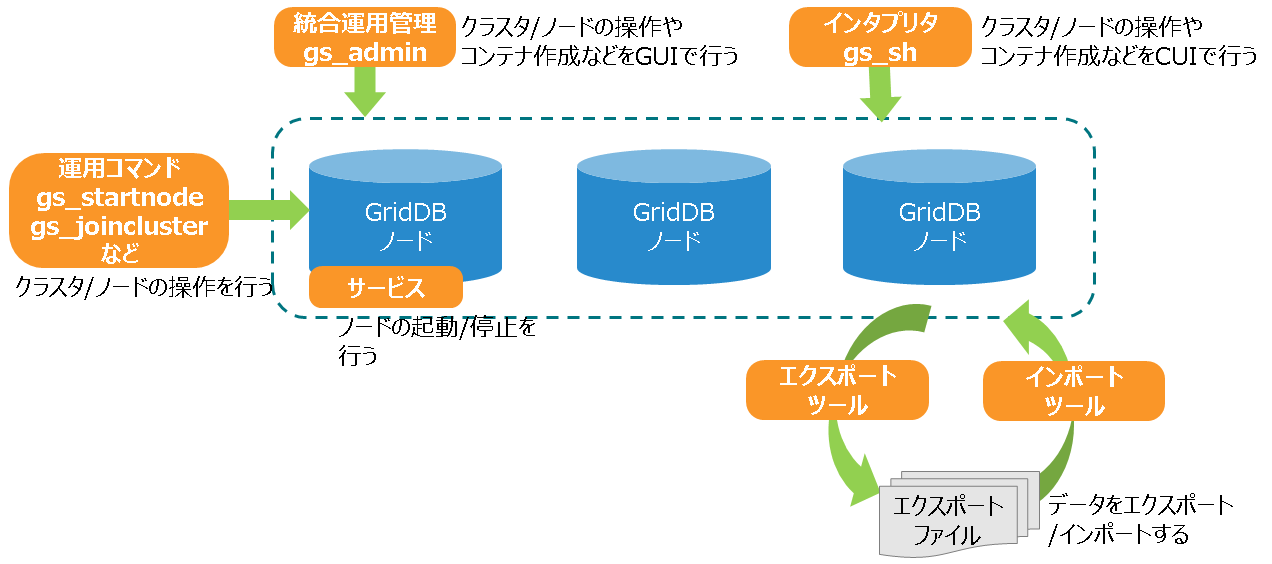

ノードの起動、クラスタの構成には、運用コマンドのgs_startnode/gs_joinclusterコマンドやgs_shを用います。また、OS起動と同時にノードを起動し、クラスタを構成するサービス制御機能もあります。

クラスタを構成するには、クラスタに参加させるノードの数(構成ノード数)とクラスタ名をすべての参加ノードで一致させる必要があります。

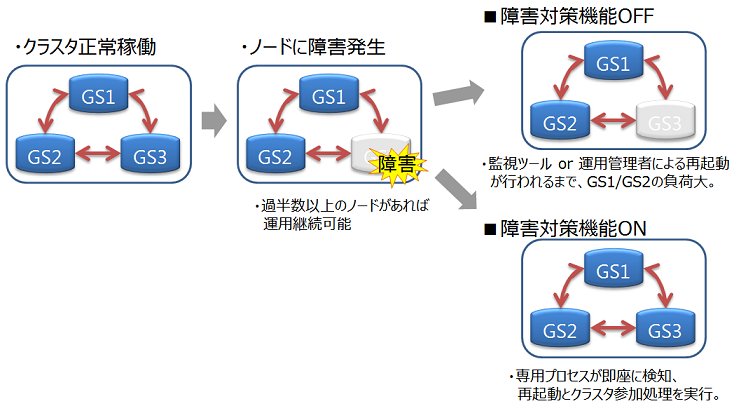

クラスタサービスは、クラスタでの運用開始後に構成するノードに障害がありクラスタからノードが切り離された場合でも、過半数のノードが参加している限りサービスは継続します。

過半数以上のノードさえ動作していればクラスタ運用は継続できるので、クラスタ運用中にメンテナンス等のために、オンラインでノード切り離したり、メンテナンス完了後にノードを組込む操作ができます。さらには、システムを増強するためにノードを追加することもオンラインでできます。

4.1.1 ノードのステータス

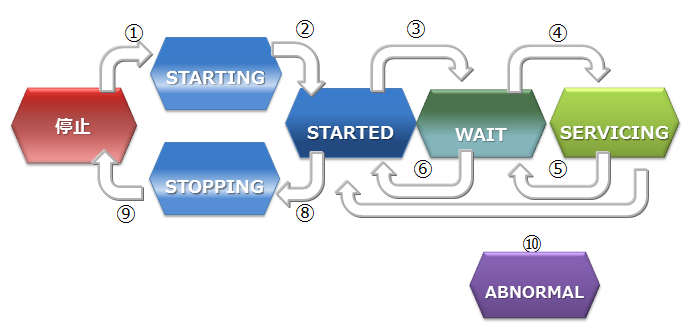

ノードには、ノードの状態を表す複数の種類のステータスがあります。ユーザのコマンド実行やノードの内部処理によってステータスが遷移します。クラスタのステータスは、クラスタに属する複数のノードのノードステータスによって決まります。

ノードステータスの種類と遷移、確認方法を説明します。

ノードステータスの種類

ノードステータス 説明 STOP ノードでGridDBサーバが起動されていない状態です。 STARTING ノードでGridDBサーバが起動処理中の状態です。前回の運転状態に応じて、データベースのリカバリ処理などの起動時の処理が行われます。クライアントからアクセスできるのは、gs_statコマンドやgs_shコマンドでのシステムの状態確認のみです。アプリケーションからのアクセスはできません。 STARTED ノードでGridDBサーバが起動されている状態です。ただし、クラスタには参加していないため、引き続きアプリケーションからのアクセスはできません。クラスタを構成するには、gs_joinclusterやgs_shのクラスタ操作コマンドでクラスタへの参加を指示します。 WAIT クラスタ構成待ちの状態です。ノードはクラスタへの参加を通知しているが、構成ノード数のノードが足りておらず、ノード数が構成ノード数になるまで待ち状態となります。また、クラスタを構成するノードが過半数以下になり、クラスタのサービスが停止した際のノード状態もWAIT状態になります。 SERVICING クラスタが構成されており、アプリケーションからのアクセスが可能な状態です。ただし、ノード停止時の障害後の再起動などでパーティションのクラスタ間での同期処理が発生した場合、アクセスが遅延することがあります。 STOPPING ノードを停止指示後、停止するまでの中間ステータスです。 ABNORMAL SERVICING状態もしくは、状態遷移の途中でノードがエラーを検出した際のステータスです。ABNORMAL状態となったノードは、自動的にクラスタから切り離されます。システムの動作情報を採取してから、ABNORMAL状態のノードを強制停止・再起動する必要があります。再起動することで、リカバリ処理が自動的に行われます。 ノードステータスの遷移

ノードステータス ステータス遷移 状態遷移事象 説明 ① コマンド実行 ノード起動(gs_startnodeコマンド、gs_sh、サービス起動などのコマンド実行) ② システム リカバリ処理やデータベースファイルのロードが完了すると、状態は自動遷移 ③ コマンド実行 クラスタ参加(gs_joincluster/gs_appendclusterコマンド、gs_sh、サービス起動などのコマンド実行) ④ システム 構成ノード数のノードがクラスタに参加すると状態は自動遷移 ⑤ システム クラスタを構成する他のノードが障害等によりサービスから切り離され、構成ノード数が設定値の過半数を下回った時に、状態が自動遷移 ⑥ コマンド実行 ノードをクラスタから切り離す(gs_leaveclusterコマンドやgs_shなどのコマンド実行) ⑦ コマンド実行 ノードをクラスタから切り離す(gs_leavecluster/gs_stopclusterコマンドやgs_shなどのコマンド実行) ⑧ コマンド実行 ノード停止(gs_stopnodeコマンド、gs_sh、サービス停止などのコマンド実行) ⑨ システム 終了処理が完了次第、サーバプロセスを停止 ⑩ システム システム障害により切り離された状態。この状態では一度ノードを強制的に停止する必要がある。 ノードステータスの確認方法

ノードステータスは、ノードの稼働状況とノードの役割の2つの状態の組み合わせによって決まります。

ノードのステータスはgs_shやgs_adminで確認できます。

ノードの稼働状況とノードの役割は、gs_statコマンドを実行した結果のjson形式のデータから確認できます。(ノードの稼働状況:/cluster/nodeStatusの値、ノードの役割:/cluster/clusterStatusの値)

ノードステータスと、ノードの稼働状況とノードの役割の2つの状態の組み合わせを以下に示します。

ノードステータス ノードの稼働状況

(/cluster/nodeStatus)ノードの役割

(/cluster/clusterStatus)STOP -(gs_statの接続エラー) -(gs_statの接続エラー) STARTING INACTIVE SUB_CLUSTER STARTED INACTIVE SUB_CLUSTER WAIT ACTIVE SUB_CLUSTER SERVICING ACTIVE MASTERまたはFOLLOWER STOPPING NORMAL_SHUTDOWN SUB_CLUSTER ABNORMAL ABNORMAL SUB_CLUSTER ノードの稼働状況

ノードの稼働状況を表します。gs_statコマンドの/cluster/nodeStatusの値で確認できます。

ノードの稼働状況 説明 ACTIVE アクティブ状態 ACTIVATING アクティブ状態に遷移中 INACTIVE 非アクティブ状態 DEACTIVATING 非アクティブ状態に遷移中 NORMAL_SHUTDOWN シャットダウン処理中 ABNORMAL 異常状態 ノードの役割

ノードの役割を表します。gs_statコマンドの/cluster/clusterStatusの値で確認できます。

ノードには「マスタ」と「フォロワ」という二つの役割があります。クラスタが開始する時には、クラスタを構成するノードのひとつが必ず「マスタ」になります。マスタはクラスタ全体の管理を行います。マスタ以外のノードはすべて「フォロワ」になります。フォロワは、マスタからの指示に基づいて同期などのクラスタ処理を行います。

ノードの役割 説明 MASTER マスタ FOLLOWER フォロワ SUB_CLUSTER/SUB_MASTER 役割未定

4.1.2 クラスタのステータス

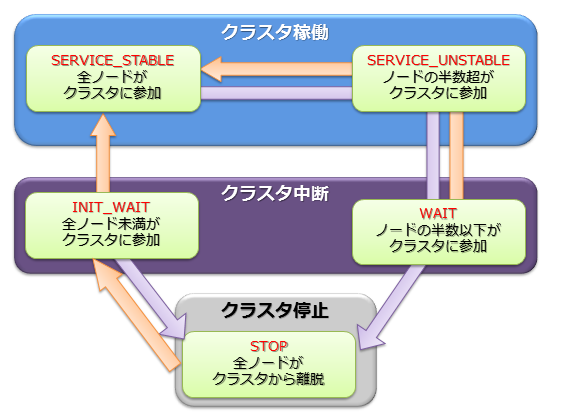

クラスタの稼働ステータスは各ノードの状態で決まり、そのステータスには稼働/中断/停止の3つの種類があります。

クラスタのサービスは、システムの初回構築時においては、ユーザが指定したクラスタ構成するノード数(構成ノード数)のノードがすべてクラスタに参加した時点で開始されます。

初回のクラスタ構築時、クラスタを構成するノードがすべてクラスタに組み入れられておらず、クラスタ構成待ちの状態が【INIT_WAIT】状態です。構成ノード数のノードがクラスタに参加完了した時点で状態は自動遷移し稼働状態となります。

稼働状態には【STABLE】と【UNSTABLE】の2つの状態があります。

- 【STABLE】状態

- 構成ノード数で指定したノードの数でクラスタが構成されており、サービスが提供できている安定した状態。

- 【UNSTABLE】状態

- 構成ノード数に満たない状態で、かつ、構成ノード数の過半数が稼働している状態

- 構成ノード数の過半数が稼働している限り、クラスタのサービスは継続します。

メンテナンスなどでノードをクラスタより切り離しても、構成ノード数の過半数が動作している限りクラスタは【UNSTABLE】状態で運用できます。

クラスタを構成するノードが、構成ノード数の半数以下となった場合、スプリットブレイン発生を防ぐためにクラスタは自動的にサービスを中断します。クラスタのステータスは【WAIT】状態となります。

スプリットブレインとは、

複数のノードを相互接続して1台のサーバのように動作させる密結合クラスタシステムにおいて、ハードウェアやネットワークの障害によりシステムが分断されたことを契機に、同じ処理を行う複数のクラスタシステムが同時にサービスを提供してしまう動作をいいます。この状態で運用を継続した場合、複数のクラスタでレプリカとして保有するデータをマスタデータとして動作してしまい、データの一貫性が取れない状態となってしまいます。

【WAIT】状態からクラスタサービスを再開するには、エラーの回復したノードや新規のノードをノード追加操作でクラスタへ追加していきます。 再び構成ノード数のノードがクラスタに参加完了した時点で状態は【STABLE】状態となり、サービスが再開されます。

ノードの障害等でクラスタを構成するノード数が半数以下となり、クラスタのサービスが中断した場合でも、ノード追加操作でエラーの回復したノードや新規のノードをクラスタへ追加していき過半数のノードがクラスタに参加した時点で自動的にクラスタのサービスは再開されます。

STABLE状態はgs_statの示すjsonのパラメータである、/cluster/activeCountと/cluster/designatedCountの値が等しい状態です。(出力される内容はバージョンによって異なります。)

$ gs_stat -u admin/admin

{

"checkpoint": {

:

:

},

"cluster": {

"activeCount":4, ★ クラスタ内で稼働中のノード

"clusterName": "test-cluster",

"clusterStatus": "MASTER",

"designatedCount": 4, ★ 構成ノード数

"loadBalancer": "ACTIVE",

"master": {

"address": "192.168.0.1",

"port": 10040

},

"nodeList": [ ★ クラスタを構成するマシンリスト

{

"address": "192.168.0.1",

"port": 10040

},

{

"address": "192.168.0.2",

"port": 10040

},

{

"address": "192.168.0.3",

"port": 10040

},

{

"address": "192.168.0.4",

"port": 10040

},

],

:

:

クラスタのステータスは、gs_shやgs_adminで確認できます。以下にgs_shでのクラスタステータスの確認例を示します。

$ gs_sh

gs> setuser admin admin gsadm //接続ユーザの設定

gs> setnode node1 192.168.0.1 10040 //クラスタを構成するノードの定義

gs> setnode node2 192.168.0.2 10040

gs> setnode node3 192.168.0.3 10040

gs> setnode node4 192.168.0.4 10040

gs> setcluster cluster1 test150 239.0.0.5 31999 $node1 $node2 $node3 $node4 //クラスタの定義

gs> startnode $cluster1 //クラスタを構成する全ノードの起動

gs> startcluster $cluster1 //クラスタ構成を指示

クラスタの開始を待っています。

クラスタが開始しました。

gs> configcluster $cluster1 ★クラスタのステータスを確認

Name : cluster1

ClusterName : test-cluster

Designated Node Count : 4

Active Node Count : 4

ClusterStatus : SERVICE_STABLE ★安定状態

Nodes:

Name Role Host:Port Status

-------------------------------------------------

node1 M 192.168.0.1:10040 SERVICING

node2 F 192.168.0.2:10040 SERVICING

node3 F 192.168.0.3:10040 SERVICING

node4 F 192.168.0.4:10040 SERVICING

gs> leavecluster $node2

ノードがクラスタから離脱するのを待っています。

ノードがクラスタから離脱しました。

gs> configcluster $cluster1

Name : cluster1

ClusterName : test150

Designated Node Count : 4

Active Node Count : 3

ClusterStatus : SERVICE_UNSTABLE ★不安定な状態

Nodes:

Name Role Host:Port Status

-------------------------------------------------

node1 M 192.168.0.1:10040 SERVICING //マスタノード

node2 - 192.168.0.2:10040 STARTED

node3 F 192.168.0.3:10040 SERVICING //フォロワノード

node4 F 192.168.0.4:10040 SERVICING //フォロワノード

4.1.3 パーティションのステータス

パーティションステータスは、クラスタ上のパーティション全体の状態を表します。クラスタステータスが稼働状態の時に、パーティションにアクセスできる状態か、パーティションに偏りが無いかなどを表すステータスです。

| パーティションステータス | 説明 |

|---|---|

| NORMAL | すべてのパーティションがデータ配置目標と同一の正常な状態 |

| NOT_BALANCE | レプリカロスやオーナロスは発生していないが、パーティションの配置が偏っている状態 |

| REPLICA_LOSS | レプリカのデータが欠損しているパーティションが存在する状態 (該当パーティションの可用性が落ちている・ノード離脱できない) |

| OWNER_LOSS | オーナのデータが欠損しているパーティションが存在する状態 (該当パーティションのデータにはアクセスできない) |

| INITIAL | クラスタ構成に参加していない初期状態 |

パーティションステータスは、マスタノードへのgs_statコマンドの実行で確認できます。(/cluster/partitionStatusの値)

$ gs_stat -u admin/admin

{

:

:

"cluster": {

:

"nodeStatus": "ACTIVE",

"notificationMode": "MULTICAST",

"partitionStatus": "NORMAL",

:

[メモ]

- マスタノード以外の/cluster/partitionStatusの値は、正しくない場合があります。必ずマスタノードの値を確認してください。

4.2 クラスタ構成の検討

クラスタ構成を行う際には以下の検討が必要となります。

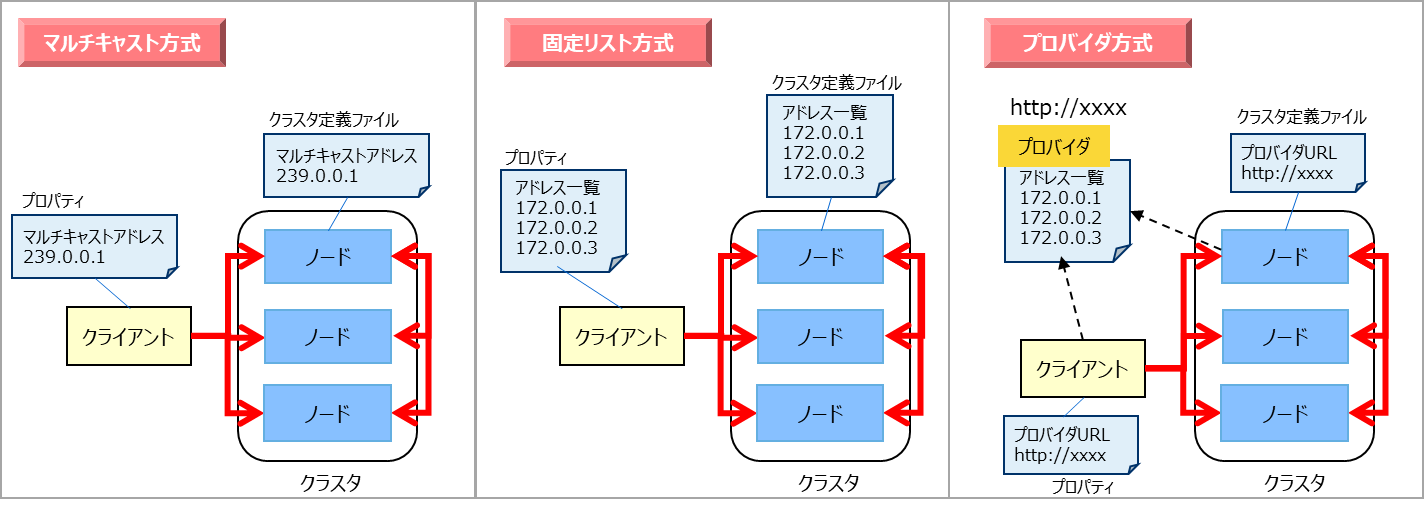

- クラスタを構成するノード間および、クラスタとクライアント間の構成方式を決定します。接続方式は、マルチキャスト方式、固定リスト方式、プロバイダ方式の3つの方式から選択します。

- クラスタとクライアント間の通信において、複数通信経路が必要かどうかを決定し、必要に応じて設定します。

- 可用性レベルに応じてクラスタのレプリカ数を設定します。アベイラビリティゾーン単位での障害耐性が必要な場合はラックゾーンアウェアネス機能を有効にします。

4.2.1 クラスタ構成方式

クラスタ構成方式とは、クラスタを構成するノード間、およびクラスタとクライアント間の通信において、それぞれのアドレスリストを認識して通信を行うための構成方式であり、以下の3つが提供されます。

- マルチキャスト方式

- マルチキャストを用いてクラスタを構成するノードのディスカバリを行うことで、アドレスリストを認識する方式です。

- 固定リスト方式

- クラスタ定義ファイルにクラスタを構成する固定のアドレスリストを指定して起動することで、アドレスリストを認識する方式です。

- プロバイダ方式

- アドレスプロバイダが提供するアドレスリストに従ってアドレスリストを認識する方式です。

- アドレスプロバイダはWebサービスとして構成するか、静的コンテンツとして構成することができます。

クラスタ構成方式の比較は以下のとおりです。

| 項目 | マルチキャスト方式 | 固定リスト方式 | プロバイダ方式 |

|---|---|---|---|

| 設定 | ・マルチキャストアドレス、ポート | ・全ノードのIPアドレス、ポート番号のリスト | ・プロバイダURL |

| 利用ケース | ・マルチキャストが利用できる。 | ・マルチキャストが利用できない。 ・正確にシステム規模の見積りが行える |

・マルチキャストが利用できない。 ・システム規模が見積もれない。 |

| クラスタ動作 | ・一定時間間隔でノードの自動ディスカバリを行う。 | ・全ノードに同一のアドレスリストを設定する。 ・ノード起動時に1度だけそのリストを読み込む。 |

・アドレスプロバイダから一定時間間隔でアドレスリストを取得する。 |

| メリット | ・ノード追加のためのクラスタ再起動不要。 | ・リストの整合性チェックが行われるため、間違いが無い。 現在のクラスタ構成ノードの把握が容易。 |

・ノード追加のためのクラスタ再起動不要。 |

| デメリット | ・クラウド環境でマルチキャスト利用不可の場合が多い。 セグメントを超えた通信が行えない。 |

・ノード追加にクラスタ再起動が必要。 ・アプリ側の接続設定の更新も必要。 |

・アドレスプロバイダの可用性確保が必要。 |

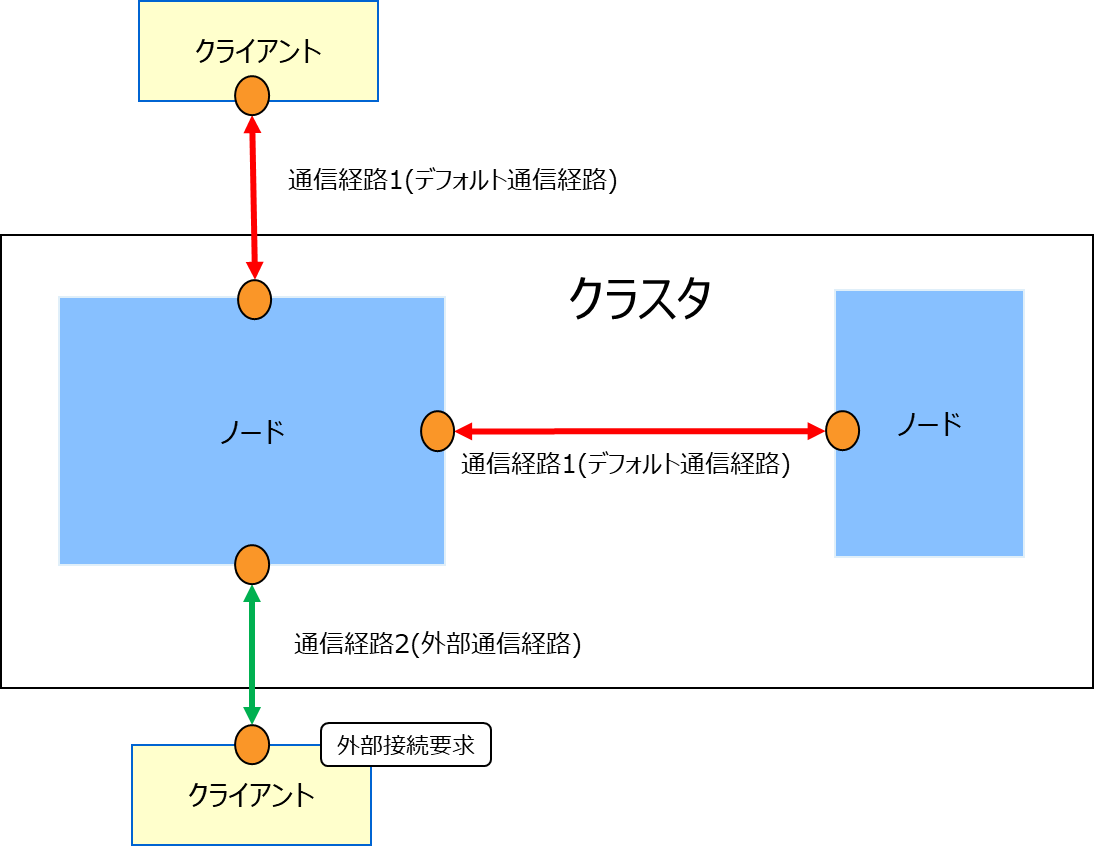

4.2.2 複数通信経路

GridDBクラスタはクライアントに対する複数の通信経路を設定することができます。デフォルトのクラスタ-クライアント間の通信経路は、クラスタノード間の通信経路と共通のものとなりますが、複数通信経路設定を行うと、これとは別の通信経路を用いた接続が可能となります。この通信経路を外部通信経路と呼びます。クライアントはどちらの通信経路を利用するかを個別に指定することが可能となります。

このような複数通信経路を用いたネットワーク構成は以下のような場合に用いられます。

- クラウド外にあるユーザのオンプレミス環境から、クラウド上で提供されるGridDBサービスを外部通信経路を用いて直接参照、操作を行うことにより、利便性を向上させたい。

- クラウド外にあるユーザのオンプレミス環境からの利用だけでなく、クラウド内の環境からデフォルトの通信経路を利用した高速なアプリケーション処理を実現したい。

4.2.3 ラックゾーンアウェアネス

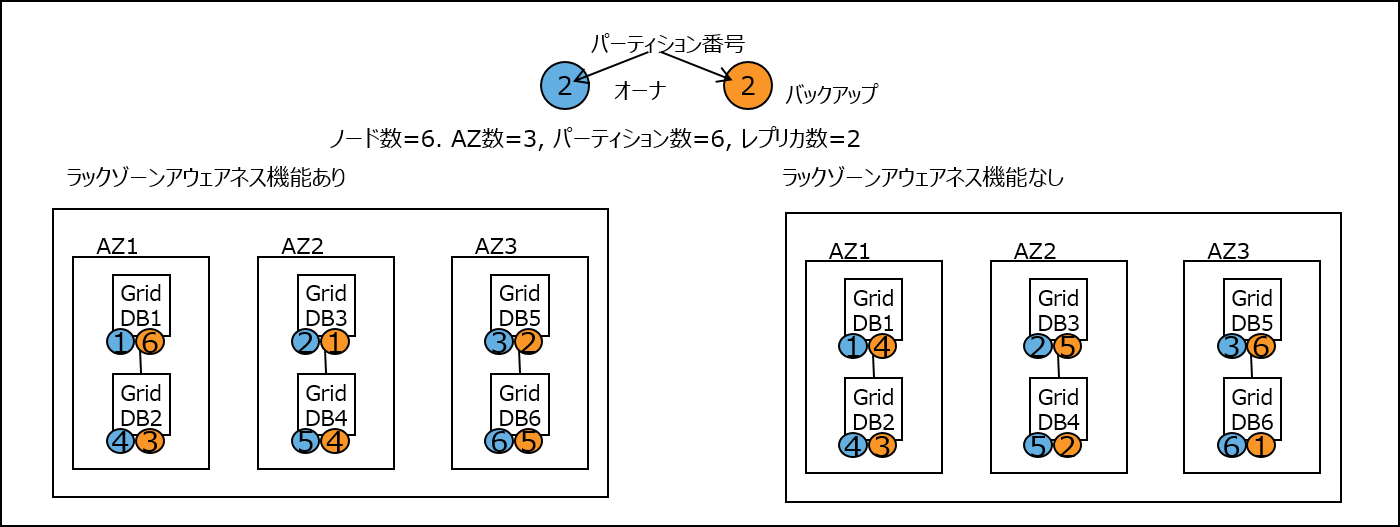

GridDBは、ラックやアベイラビリティゾーンなどの物理的な構成グループ単位の障害が発生した場合の可用性を向上させる、ラックゾーンアウェアネス機能を提供します。あるデータのオーナとバックアップがともに同じ構成グループに配置されていると、そのグループに障害が発生した場合にはそのデータへのアクセスができなくなります。ラックゾーンアウェアネス機能を利用すると、クラスタのノードが属するグループを事前に定義しておくことができ、GridDBは、その定義を参照し、オーナとバックアップを別グループに配置するように制御します。これにより、あるグループに障害が発生した場合でも、別のグループにデータのバックアップがあるため、データへのアクセスが可能になります。また、この際、オーナとバックアップが各グループ、各ノードにできるだけ均等に配置されるような割り当てが行われます。

ラックゾーンアウェネス機能は、ラックやアベイラビリティゾーンなどの構成グループを利用できる場合に、効果的に可用性を高める機能です。一般的に可用性を向上させるにはレプリカ数を多く設定する必要がありますが、レプリカ数を増やすとトランザクション性能が劣化するトレードオフ関係が発生します。ラックゾーンアウェアネス機能はグループ単位での障害に備えて配置を優先して計算します。そのため、構成グループを利用できる場合には、レプリカ数を抑えつつ(トランザクション性能を維持しつつ)可用性を向上することができます。この機能を利用するには、設定ファイルにラックゾーンに関する設定を行う必要があります。これ以外の特別な運用操作は必要ありません。

ノード数=6, グループ数=3,パーティション数=6, レプリカ数=2でクラスタを構成した場合のデータ配置の違いを説明します。(下図ではクラウドのアベイラビリティゾーン(AZ)を使用した例を示しています。)下図の左側がラックゾーンアウェネス機能を利用した場合、右側がラックゾーンアウェネス機能を利用しない通常のデータ配置です。

右側のラックゾーンアウェアネス機能なしの場合、データのオーナとバックアップが同一AZ内に配置されることがありえます。例えば、AZ1のGridDB2には、クラスタパーティション4のデータのオーナ(青)が配置されています。同時に、このクラスタパーティション4のデータのバックアップ(橙)は、同じAZ1のGridDB1に配置されています。このようなデータ配置では、AZ1に障害が発生した場合、このクラスタパーティション4のデータにアクセスできなくなります。一方、左側のラックゾーンアウェアネス機能ありの場合は、このような配置にならないことを保証します。例えば、クラスタパーティション4のデータのオーナ(青)はAZ1に配置されています。同時に、このデータのバックアップ(橙)は、AZ1とは別のAZ2に配置されています。他のクラスタパーティションのデータについても同様です。

このように、ラックゾーンアウェアネス機能は、全てのクラスタパーティションデータのオーナとバックアップを別々のAZに配置することで、どのAZに障害が発生したとしても、全てのクラスタパーティションのデータにアクセスできるようにします。ただし、同一ラックゾーンに対する配置を抑制するため、各ノードのオーナ、バックアップの割当て個数には若干偏りが生じる場合があります。また、障害発生からクラスタ安定状態(データ同期処理が発生する時間)になるまでの時間も若干増加する傾向がありますが、 GridDBではこれらデータ偏りや安定状態までの時間をできるだけラックゾーンアウェアネス無の場合と大きな違いがないように最適化します。

【メモ】ラックゾーンアウェアネス機能はクラスタパーティションの割付規則を決定する機能であり、同様の機能を持つ、6.11.1 生成規則の指定と6.11.2 配置表の固定化指定と併用利用することができません。用途に応じていずれかを使い分けるようにしてください。

4.2.4 設定方法

4.2.4.1 クラスタ構成方法

クラスタ構成方法として、マルチキャスト方式、固定リスト方式、プロバイダ方式の3つの方式があり、これらをクラスタを構成するノード間、クラスタとクライアント間の個別に設定することになりますが、以下は前者の設定のみを記載します。後者の設定は、各種クライアントのAPIリファレンスを参照してください。

4.2.4.1.1 マルチキャスト方式

マルチキャストアドレスを与えてノードを起動することで、マルチキャストを利用したクラスタを構成します。マルチキャストはクラスタ、トランザクション、SQLの3つのサービスに対して定義しますが、クラスタサービスとしてマルチキャストを選択した場合は、トランザクション、SQLサービスも必ずマルチキャスト方式にする必要があります。

マルチキャスト方式でクラスタを構成する場合は、クラスタ定義ファイルのパラメータを設定します。

クラスタ定義ファイル

| パラメータ | データ型 | 意味 |

|---|---|---|

| /cluster/notificationAddress | string | クラスタ構成に必要なマルチキャストのIPアドレスを指定します。 |

| /cluster/notificationPort | int | クラスタ構成に必要なマルチキャストのポート番号を指定します。 |

| /transaction/notificationAddress | string | クライアントとのトランザクション処理に必要なマルチキャストのIPアドレスを指定します。 |

| /transaction/notificationPort | int | クライアントとのトランザクション処理に必要なマルチキャストのポート番号を指定します。 |

| /sql/notificationAddress | string | クライアントとのSQL処理に必要なマルチキャストのIPアドレスを指定します。 |

| /sql/notificationPort | int | クライアントとのSQL処理に必要なマルチキャストのポート番号を指定します。 |

マルチキャストが利用できない場合は固定リスト、もしくはプロバイダ方式を利用して下さい。

{

:

:

"cluster":{

"clusterName":"yourClusterName",

"replicationNum":2,

"heartbeatInterval":"5s",

"loadbalanceCheckInterval":"180s",

"notificationAddress":"239.0.0.1",

"notificationPort":20000

},

"transaction":{

"notificationAddress":"239.0.0.1",

"notificationPort":31999

},

"sql":{

"notificationAddress":"239.0.0.1",

"notificationPort":41999

}

:

:

}

4.2.4.1.2 固定リスト方式

固定のアドレスリストを与えてノードを起動することで、そのリストを利用してクラスタを構成します。

固定リスト方式でクラスタを構成する場合は、クラスタ定義ファイルのパラメータを設定します。

クラスタ定義ファイル

| パラメータ | データ型 | 意味 |

|---|---|---|

| /cluster/notificationMember | string | クラスタ構成方式を固定リスト方式にする際に、アドレスリストを指定します。 |

/cluster/notificationMemberの要素は各サービスごとに以下を記述します。 "サービス名":{"address"}:"IPアドレス","port":ポート番号

/cluster/notificationMember中の要素は以下の通りとなります。複数接続経路を用いる場合、 transactionPublicおよびsqlPublicの項目を追加して、それぞれの外部接続用IPアドレス、ポート番号を記述します。これらIPアドレスはノード起動時にノード定義ファイルで設定するtransaction/sqlのpublicServiceAddressと同じにする必要があります。また、ポート番号はtransaction/sqlのservicePortと同じにする必要があります。

| パラメータ | データ型 | 意味 |

|---|---|---|

| /cluster/address | string | クラスタサービス通信用のIPアドレスを指定します。 |

| /cluster/port | int | 上記のポート番号を指定します。 |

| /sync/address | string | シンクサービス通信用のIPアドレスを指定します。 |

| /sync/port | int | 上記のポート番号を指定します。 |

| /system/address | string | システムサービス通信用のIPアドレスを指定します。 |

| /system/port | int | 上記のポート番号を指定します。 |

| /transaction/address | string | デフォルト通信経路となるトランザクションサービス通信用のIPアドレスを指定します。 |

| /transaction/port | int | 上記のポート番号を指定します。 |

| /sql/address | string | デフォルト通信経路となるSQLサービス通信用のIPアドレスを指定します。 |

| /sql/port | int | 上記のポート番号を指定します。 |

| /transactionPublic/address | string | 外部通信経路となるトランザクションサービス通信用のIPアドレスを指定します。 |

| /transactionPublic/port | int | 上記のポート番号を指定します。 |

| /sqlPublic/address | string | 外部通信経路となるSQLサービス通信用のIPアドレスを指定します。 |

| /sqlPublic/port | int | 上記のポート番号を指定します。 |

デフォルトの通信経路を用いる場合のクラスタ定義ファイルの設定例は以下のとおりです。

{

:

:

"cluster":{

"clusterName":"yourClusterName",

"replicationNum":2,

"heartbeatInterval":"5s",

"loadbalanceCheckInterval":"180s",

"notificationMember": [

{

"cluster": {"address":"172.17.0.44", "port":10010},

"sync": {"address":"172.17.0.44", "port":10020},

"system": {"address":"172.17.0.44", "port":10040},

"transaction": {"address":"172.17.0.44", "port":10001},

"sql": {"address":"172.17.0.44", "port":20001}

},

{

"cluster": {"address":"172.17.0.45", "port":10010},

"sync": {"address":"172.17.0.45", "port":10020},

"system": {"address":"172.17.0.45", "port":10040},

"transaction": {"address":"172.17.0.45", "port":10001},

"sql": {"address":"172.17.0.45", "port":20001}

},

{

"cluster": {"address":"172.17.0.46", "port":10010},

"sync": {"address":"172.17.0.46", "port":10020},

"system": {"address":"172.17.0.46", "port":10040},

"transaction": {"address":"172.17.0.46", "port":10001},

"sql": {"address":"172.17.0.46", "port":20001}

}

]

},

:

:

}

4.2.4.1.3 プロバイダ方式

アドレスプロバイダが提供するアドレスリストを取得してクラスタ構成を行います。

プロバイダ方式でクラスタを構成する場合は、クラスタ定義ファイルのパラメータを設定します。

クラスタ定義ファイル

| パラメータ | データ型 | 意味 |

|---|---|---|

| /cluster/notificationProvider/url | string | クラスタ構成方式をプロバイダ方式にする際に、アドレスプロバイダのURLを指定します。 |

| /cluster/notificationProvider/updateInterval | string | アドレスプロバイダからリストを取得する間隔を指定します。1s以上、231s未満の値を指定します。 |

プロバイダが返却するノードリストの書式は固定リストの規則と同じになります。

クラスタ定義ファイルの設定例は以下のとおりです。

{

:

:

"cluster":{

"clusterName":"yourClusterName",

"replicationNum":2,

"heartbeatInterval":"5s",

"loadbalanceCheckInterval":"180s",

"notificationProvider":{

"url":"http://example.com/notification/provider",

"updateInterval":"30s"

}

},

:

:

}

アドレスプロバイダはWebサービスとして構成するか、静的コンテンツとして構成することができます。 アドレスプロバイダは以下の仕様を満たす必要があります。

- GETメソッドに対応。

- URLにアクセスすると、そのURLが書かれたクラスタ定義ファイルを持つクラスタのノードのアドレスリストをレスポンスとして返す。

- レスポンスボディ:固定リスト方式において指定するノードリストの内容と同等のJSON

- レスポンスヘッダ:Content-Type:application/jsonを含む

アドレスプロバイダからのレスポンスの例は以下のとおりです。複数通信経路を設定した場合は、transactionPublicおよびsqlPublicの記載も必要となります。

$ curl http://example.com/notification/provider

[

{

"cluster": {"address":"172.17.0.44", "port":10010},

"sync": {"address":"172.17.0.44", "port":10020},

"system": {"address":"172.17.0.44", "port":10040},

"transaction": {"address":"172.17.0.44", "port":10001},

"sql": {"address":"172.17.0.44", "port":20001}

},

{

"cluster": {"address":"172.17.0.45", "port":10010},

"sync": {"address":"172.17.0.45", "port":10020},

"system": {"address":"172.17.0.45", "port":10040},

"transaction": {"address":"172.17.0.45", "port":10001},

"sql": {"address":"172.17.0.45", "port":20001}

},

{

"cluster": {"address":"172.17.0.46", "port":10010},

"sync": {"address":"172.17.0.46", "port":10020},

"system": {"address":"172.17.0.46", "port":10040},

"transaction": {"address":"172.17.0.46", "port":10001},

"sql": {"address":"172.17.0.46", "port":20001}

}

]

【メモ】

- クラスタ定義ファイルの/cluster/notificationAddress、/cluster/notificationMember、/cluster/notificationProviderは、使用するクラスタ構成方式に合わせていずれか1つを設定してください。

4.2.4.2 複数通信経路

GridDBクラスタにおいて複数通信経路を有効にするには、クラスタを構成する各ノードにおけるノード定義ファイルで外部通信経路のIPアドレスを指定してクラスタを構成します。ポート番号はservicePortに記載した値と共通のものになるため新たな記載は必要ありません。

ノード定義ファイル

| パラメータ | データ型 | 意味 |

|---|---|---|

| /transaction/publicServiceAddress | string | トランザクションサービス外部通信経路に対応するIPアドレスを指定します。 |

| /sql/publicServiceAddress | string | SQLサービス外部通信経路に対応するIPアドレスを指定します。 |

ノード定義ファイルの設定例は以下のとおりです。

{

:

:

"transaction":{

"serviceAddress":"172.17.0.44",

"publicServiceAddress":"10.45.1.10",

"servicePort":10001

},

"sql":{

"serviceAddress":"172.17.0.44",

"publicServiceAddress":"10.45.1.10",

"servicePort":20001

},

:

:

複数通信経路を有効にする場合のノードリストのサンプルは以下になります。

{

:

:

"cluster":{

"clusterName":"yourClusterName",

"replicationNum":2,

"heartbeatInterval":"5s",

"loadbalanceCheckInterval":"180s",

"notificationMember": [

{

"cluster": {"address":"172.17.0.44", "port":10010},

"sync": {"address":"172.17.0.44", "port":10020},

"system": {"address":"172.17.0.44", "port":10040},

"transaction": {"address":"172.17.0.44", "port":10001},

"sql": {"address":"172.17.0.44", "port":20001},

"transactionPublic": {"address":"10.45.1.10", "port":10001},

"sqlPublic": {"address":"10.45.1.10", "port":20001}

},

{

"cluster": {"address":"172.17.0.45", "port":10010},

"sync": {"address":"172.17.0.45", "port":10020},

"system": {"address":"172.17.0.45", "port":10040},

"transaction": {"address":"172.17.0.45", "port":10001},

"sql": {"address":"172.17.0.45", "port":20001},

"transactionPublic": {"address":"10.45.1.11", "port":10001},

"sqlPublic": {"address":"10.45.1.11", "port":20001}

},

{

"cluster": {"address":"172.17.0.46", "port":10010},

"sync": {"address":"172.17.0.46", "port":10020},

"system": {"address":"172.17.0.46", "port":10040},

"transaction": {"address":"172.17.0.46", "port":10001},

"sql": {"address":"172.17.0.46", "port":20001},

"transactionPublic": {"address":"10.45.1.12", "port":10001},

"sqlPublic": {"address":"10.45.1.12", "port":20001}

}

]

},

:

:

}

4.2.4.3 ラックゾーンアウェアネス

クラスタ定義ファイル

| パラメータ | データ型 | 意味 |

|---|---|---|

| /cluster/rackZoneAwareness | bool | ラックゾーンアウェイアウェアネス機能を利用したデータ配置戦略を行うかどうかを指定します。利用する場合はtrueとしてrackZoneIdを必ず指定してください。 |

| /cluster/rackZoneId | string | ラックゾーンアウェアネス機能で必要となる、グルーピング単位に付与する識別子です。1以上64文字以内の英数字となります。 |

ノード定義ファイルの設定の例は以下の通りです。

{

:

:

"cluster":{

"servicePort":10010

"rackZoneAwareness":true,

"rackZoneId":"zone-01",

},

:

:

}

5 データモデル

GridDBは、Key-Valueに似た独自のKey-Container型データモデルです。以下の特徴があります。

- Key-Valueをグループ化するコンテナというRDBのテーブルに似た概念を導入

- コンテナに対してデータ型を定義するスキーマ設定が可能。カラムにインデックスを設定可能。

- コンテナ内のロウ単位でトランザクション操作が可能。また、コンテナ単位でACIDを保証します。

GridDBのデータは、ブロック、コンテナ、テーブル、ロウ、パーティションという単位でデータ管理されています。

ブロック

ブロックとは、ディスクへのデータ永続化処理(以降、チェックポイントと呼びます)のデータ単位であり、GridDBの物理的なデータ管理の最小単位です。ブロックには複数のコンテナのデータが配置されます。ブロックサイズは、GridDBの初期起動前に定義ファイル(クラスタ定義ファイル)で設定します。

GridDBは、システムの初期起動とともにデータベースファイルが作成されるため、初期起動以降ブロックサイズの変更はできません。

コンテナ(テーブル)

利用者とのI/Fとなるデータ構造です。 複数のブロックで構成されます。 NoSQL I/Fで操作する場合はコンテナ、NewSQL I/Fで操作する場合はテーブルと呼びます。コンテナ(テーブル)には、コレクション(テーブル)と時系列コンテナ(時系列テーブル)の2種類のデータタイプが存在します。

アプリケーションでデータを登録する前には、必ずコンテナ(テーブル)を作成しておく必要があります。

ロウ

ロウは、コンテナやテーブルに登録される1行のデータを指します。コンテナやテーブルには複数のロウが登録されますが、データは同じブロックに配置されるわけではありません。登録・更新されるタイミングに応じて、パーティション内の適切なブロックに配置されます。

ロウは複数のデータ型のカラムから構成されます。

パーティション

パーティションは、1つ以上のコンテナやテーブルを含むデータ管理の単位です。

パーティションはクラスタ間でのデータ配置の単位であり、ノード間の負荷バランスを調整するためのデータ移動や、障害発生に備えたデータ多重化(レプリカ)管理のための単位です。データのレプリカはパーティション単位にクラスタを構成するノードに配置されます。

パーティション内のコンテナに対して更新操作ができるノードはオーナノードと呼ばれ、1つのパーティションに対して1つのノードが割り当てられます。オーナノード以外でレプリカを保持するノードは、バックアップノードとなります。パーティションには、レプリカの数の設定値に応じてマスタデータと複数のバックアップデータがあります。

コンテナとパーティションの関連は恒久的なもので、コンテナ作成時に、所属するパーティションが決定した後は変わりません。パーティションとノードの関連は一時的なもので、自律的データ配置によってパーティションが別のノード上に移動する場合があります。

また、パーティションの保持するデータがOSのディスクに保存される物理的なデータベースファイルとなります。

5.1 コンテナ

GridDBにデータを登録し、検索するには、データを格納するコンテナ(テーブル)を作成する必要があります。 NoSQL I/Fで操作する場合はコンテナ、NewSQL I/Fで操作する場合はテーブルと呼びます。

コンテナ(テーブル)もデータベースと同様の命名規則があります。

- 指定可能な文字列は、英数字およびアンダースコア_、ハイフン-、ドット.、スラッシュ/、イコール=です。ただし、先頭文字に数字は指定できません。

- 命名時の大文字・小文字は保持されますが、大文字小文字を同一視した場合に同一名となるコンテナ(テーブル)は作成できません。

[メモ]

- 同一のデータベースの中で、ビューと同じ名前のコンテナは作成できません。

5.1.1 種別

コンテナ(テーブル)には、2つのデータタイプがあります。時々刻々発生するデータを発生した時刻とともに管理するのに適したデータタイプである 時系列コンテナ(時系列テーブル) とさまざまなデータを管理する コレクション(テーブル) です。

5.1.2 データ型

コンテナ(テーブル)にはスキーマを設定できます。登録できるデータ型には、基本的なデータ型である 基本型 と 配列型 があります。

5.1.2.1 基本型

登録できる基本型のデータを説明します。基本型とは、他の型の組み合わせで表現できない、基本的な型です。

| データ型 | 説明 |

|---|---|

| BOOL型 | 真または偽のいずれかの値 |

| STRING型 | Unicodeコードポイントを文字とする、任意個数の文字の列より構成 |

| BYTE型 | -27から27-1 (8ビット)の整数値 |

| SHORT型 | -215から215-1 (16ビット)の整数値 |

| INTEGER型 | -231から231-1 (32ビット)の整数値 |

| LONG型 | -263から263-1 (64ビット) の整数値 |

| FLOAT型 | IEEE754で定められた単精度型(32ビット)浮動小数点数 |

| DOUBLE型 | IEEE754で定められた倍精度型(64ビット)浮動小数点数 |

| TIMESTAMP型 | 年月日ならびに時分秒からなる時刻を表す型。データベースに保持されるデータ形式はUTCで、精度はミリ秒 |

| GEOMETRY型 | 空間構造を表すためのデータ型 |

| BLOB型 | 画像や音声などのバイナリデータのためのデータ型 |

STRING型、GEOMETRY型、BLOB型は管理できるデータのサイズに以下の制限があります。制限値は、GridDBの定義ファイル(gs_node.json)のデータベースの入出力単位であるブロックサイズに応じて値が異なります。

| 型 | ブロックサイズ(64KB) | ブロックサイズ (1MB~32MB) |

|---|---|---|

| STRING型 | 最大31KB (UTF-8エンコード相当) | 最大128KB (UTF-8エンコード相当) |

| GEOMETRY型 | 最大31KB (内部格納形式相当) | 最大128KB (内部格納形式相当) |

| BLOB型 | 最大1GB - 1Byte | 最大1GB - 1Byte |

GEOMETRY型(空間型)

GEOMETRY型(空間型)のデータは地図情報システムなどでよく利用されています。空間型のデータは、NoSQLインターフェースでのみ使用できます。NewSQLインターフェースでは未サポートです。

GEOMETRY型のデータは、WKT(Well-known text)を用いて記述します。WKTは、地理空間に関する情報の標準化などを推進している非営利団体OGC(Open Geospatial Consortium)にて策定されています。GridDBでは、コンテナのカラムをGEOMETRY型に設定することで、WKTで記述された空間情報をカラムに格納できます。

GEOMETRY型では以下のWKT形式をサポートします。

- POINT

- 2次元または3次元の座標により生成される点。

- 記述例: POINT(0 10 10)

- LINESTRING

- 2つ以上の点により表現される、2次元または3次元空間上の直線の集合。

- 記述例: LINESTRING(0 10 10, 10 10 10, 10 10 0)

- POLYGON

- 直線の集合により表現される、2次元または3次元空間上の閉じた領域。POLYGONの頂点は反時計回りに指定します。POLYGON内に島をつくる場合、内部の点は時計回りで指定します。

- 記述例: POLYGON((0 0,10 0,10 10,0 10,0 0))、POLYGON ((35 10, 45 45, 15 40, 10 20, 35 10),(20 30, 35 35, 30 20, 20 30))

- POLYHEDRALSURFACE

- 2次元または3次元の座標により生成される点

- 記述例: POLYHEDRALSURFACE (((0 0 0, 0 1 0, 1 1 0, 1 0 0, 0 0 0)), ((0 0 0, 0 1 0, 0 1 1, 0 0 1, 0 0 0)),((0 0 0, 1 0 0, 1 0 1, 0 0 1, 0 0 0)), ((1 1 1, 1 0 1, 0 0 1, 0 1 1, 1 1 1)),((1 1 1, 1 0 1, 1 0 0, 1 1 0, 1 1 1)),((1 1 1, 1 1 0, 0 1 0, 0 1 1, 1 1 1)) )

- QUADRATICSURFACE

- 定義式f(X) = <AX, X> + BX + cにより表現される、3次元空間上の2次曲面。

ただし、空間構造QUADRATICSURFACEはコンテナに登録することはできず、検索条件としてのみ使用できます。

GEOMETRY型を利用した演算は、APIやTQLで実行できます。

TQLでは2次元、3次元の空間を定義する空間生成関数と空間型データ間での演算の関数を提供します。TQLではコンテナ内のGEOMETRY型のカラムと指定した空間データで演算を行いその結果を以下のようにして得ることができます。

SELECT * WHERE ST_MBRIntersects(geom, ST_GeomFromText('POLYGON((0 0,10 0,10 10,0 10,0 0))'))

TQLで提供する関数の詳細は『GridDB TQL リファレンス』(GridDB_TQL_Reference.html)を参照ください。

5.1.2.2 複合型

コンテナに登録できる、基本型の組み合わせで構成される型を定義します。 現バージョンでは配列型のみです。

配列型

値の列を表します。基本型のデータの内、GEOMETRY型とBLOB型を除く基本型を配列型として、データを保持することができます。配列で保持できるデータ量の制限は、データベースのブロックサイズに応じて値が異なります。

型 ブロックサイズ(64KB) ブロックサイズ (1MB~32MB) 配列数 4000 65000

【メモ】

配列型カラムでは、TQLでの操作に以下の制約があります。

配列型カラムのi番目の値の比較はできますが、全要素に関する演算(集計演算)はできません。

(例)columnAが配列型で定義されたとした場合

select * where ELEMENT(0, columnA) > 0 のような配列内の要素を指定した比較はできます。ただし、ELEMENTの"0"の部分に変数は指定できません。

select SUM(columnA) のような集計計算はできません。

5.1.3 主キー

コンテナ(テーブル)には、主キーを設定できます。主キーによって、コンテナ(テーブル)のロウの一意性を保証します。また主キーを設定したカラムには、NULL値を許容しません。

主キーは、コンテナではROWKEY(ロウキー)、テーブルではPRIMARY KEY(プライマリキー)と呼びます。

- 時系列コンテナ(時系列テーブル)の場合

- ROWKEY(PRIMARY KEY)は先頭カラムに設定できます。(GridDBではカラムを0番から数えるため、カラム番号0に設定します。)

- ROWKEY(PRIMARY KEY)は、TIMESTAMP型です。

- 指定は必須です。

- コレクション(テーブル)の場合

- ROWKEY(PRIMARY KEY)は先頭カラムより連続した複数のカラムに設定できます。ロウキーを複数のカラムに設定した場合は、複合ロウキーと呼びます。設定できるカラム数の上限は16個です。

- 例) 先頭カラムより連続したカラムであるstr1, str2, str3をロウキーに設定できます。

CREATE TABLE sample_table1 (str1 string, str2 string, str3 string, str4 string, str5 string, int1 integer, PRIMARY KEY(str1, str2, str3)); - 例) 連続していないカラムであるstr1, str3, str4をロウキーに設定することはできません。以下のSQLを実行するとエラーになります。

CREATE TABLE sample_table2 (str1 string, str2 string, str3 string, str4 string, str5 string, int1 integer, PRIMARY KEY(str1, str3, str4));

- 例) 先頭カラムより連続したカラムであるstr1, str2, str3をロウキーに設定できます。

- ROWKEY(PRIMARY KEY)は、STRING、INTEGER、LONG、TIMESTAMPのいずれかの型のカラムです。

- 指定は必須ではありません。

- ROWKEY(PRIMARY KEY)は先頭カラムより連続した複数のカラムに設定できます。ロウキーを複数のカラムに設定した場合は、複合ロウキーと呼びます。設定できるカラム数の上限は16個です。

ROWKEY(PRIMARY KEY)に設定したカラムには、カラムの型に応じてあらかじめ既定された、デフォルトの索引が設定されます。

GridDBの現バージョンでは、ROWKEY(PRIMARY KEY)に指定できるSTRING、INTEGER、LONG、TIMESTAMPのすべての型のデフォルトの索引はTREE索引です。

[メモ]

- NoSQLインターフェースにて、複合ロウキーを設定する例は『GridDB プログラミングガイド』(GridDB_ProgrammingGuide.html)の「複合ロウキーを扱う」を参照ください。

5.2 ビュー

コンテナのデータを参照するためのビューを作成できます。

ビュー作成時に、コンテナに対する参照(SELECT文)を定義します。ビューはコンテナと似たオブジェクトですが実データを持ちません。ビューを含むクエリの実行時に、ビュー作成時に定義されたSELECT文を評価して結果を返します。

ビューは参照(SELECT)のみ可能です。ビューに対して、データの追加(INSERT)/更新(UPDATE)/削除(DELETE)を行うことはできません。

[メモ]

- 同一のデータベースの中で、コンテナと同じ名前のビューは作成できません。

- ビューの命名規則は、コンテナの命名規則と同様です。

6 データベース機能

6.1 リソースの管理

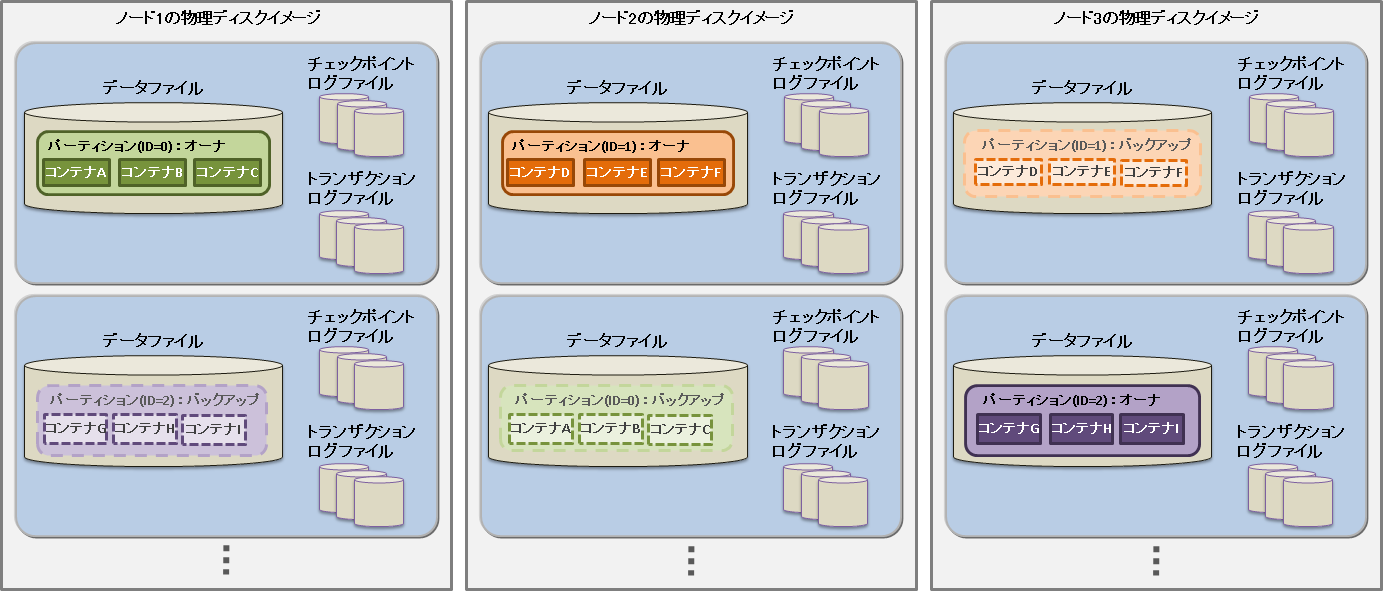

GridDBのクラスタを構成するリソースには、メモリ上のデータベースのほかにディスク上に永続化されるリソースがあります。 永続化リソースには、以下のものがあります。

データベースファイル

クラスタを構成するノードの保有するデータをディスクやSSDに書き込み、永続化したファイル群です。データベースファイルは、定期的にメモリ上のデータベースが書き込まれるデータファイル/チェックポイントログファイルと、データ更新の都度保存されるトランザクションログファイルを総称します。

データファイル

パーティションがディスクに永続化されたファイルです。ノード定義ファイルのサイクル(/checkpoint/checkpointInterval)でメモリ上の更新情報が反映されます。 ファイルのサイズはデータ容量に応じて拡張します。一度拡張したデータファイルのサイズは、コンテナやロウなどのデータを削除しても減少しません。なお、データ削除後の空き領域は再利用されます。データファイルは複数に分割することも可能です。

チェックポイントログファイル

パーティションのブロック管理情報がディスクに永続化されたファイルです。ノード定義ファイルのサイクル(/checkpoint/checkpointInterval)でブロック管理情報の書き込みを分割で行います。 パーティションごとにファイルをデフォルトで最大10個作成します。ノード定義ファイルの分割数(/checkpoint/partialCheckpointInterval)で調整できます。

トランザクションログファイル

トランザクションの更新情報がログとしてシーケンシャルに保存されるファイルです。ひとつのファイルには、前回のチェックポイント開始から次のチェックポイント開始までに実行されたトランザクションログを格納します。パーティションごとにファイルをデフォルトで最大3個(現在のログファイルと過去2世代分のログファイル)作成します。

定義ファイル

クラスタを構成する際のパラメータファイル(gs_cluster.json:以降、クラスタ定義ファイルと呼ぶ)と、クラスタ内でのノードの動作やリソースを設定するパラメータファイル(gs_node.json:以降、ノード定義ファイルと呼ぶ)の2つがあります。また、GridDBの管理ユーザのユーザ定義ファイルもあります。

イベントログファイル

GridDBサーバのイベントログが保存されます。イベントログにはエラーや警告などのメッセージが含まれます。

監査ログファイル

GridDBサーバの監査ログが保存されます。監査ログにはアクセスログ、操作ログ、エラーログを記録したメッセージが含まれます。

バックアップファイル

GridDBのデータファイルのバックアップデータが保持されます。

これらのリソースは、GridDBホーム(環境変数GS_HOMEで指定されるパス)で配置を定義します。 初期インストール状態では、/var/lib/gridstoreディレクトリがGridDBホームで、このディレクトリの下に各リソースの初期データが配置されます。

初期の配置状態は以下のとおりです。

/var/lib/gridstore/ # GridDBホームディレクトリ

admin/ # 統合運用管理機能ホームディレクトリ

backup/ # バックアップディレクトリ

conf/ # 定義ファイルディレクトリ

gs_cluster.json # クラスタ定義ファイル

gs_node.json # ノード定義ファイル

password # ユーザ定義ファイル

data/ # データファイル,チェックポイントログディレクトリ

txnlog/ # トランザクションログディレクトリ

expimp/ # Export/Importツールディレクトリ

log/ # サーバイベントログ・運用ツールログディレクトリ

audit/ # サーバ監査ログディレクトリ(監査ログ設定時のみ)

GridDBホームは、OSユーザgsadmの.bash_profileファイルの設定で変更できます。GridDBホームを変更する場合は、上記ディレクトリのリソースも適宜移動してください。

.bash_profileファイルには、環境変数GS_HOMEとGSLOGの2つの環境変数の設定がされています。

vi .bash_profile

# GridStore specific environment variables

GS_LOG=/var/lib/gridstore/log

export GS_LOG

GS_HOME=/var/lib/gridstore ★GridDBホームの変更

export GS_HOME

データベースディレクトリやバックアップディレクトリ、サーバイベントログディレクトリ、サーバ監査ログディレクトリは、ノード定義ファイルの設定値を変更することで変更できます。

クラスタ定義ファイルやノード定義ファイルで設定できる内容に関しましてはパラメータを参照してください。

6.2 データアクセス機能

GridDBのデータにアクセスするには、NoSQLインターフェースもしくはNewSQLインターフェースを用いてアプリケーションを開発する必要があります。データアクセスでは、コンテナやテーブルがクラスタデータベースのどこに配置されているかの位置情報を意識する必要はなく、GridDBのクラスタデータベースに接続するだけでアクセスができます。コンテナがクラスタを構成するどのノードに配置されているのかをアプリケーションシステムが意識する必要はありません。

GridDBのAPIでは、クラスタデータベースへの初期接続時に、ノード情報(パーティション)とともにコンテナの配置ヒント情報をクライアント側に保持(キャッシュ)します。

アプリケーションが利用するコンテナが切り替わる度に、配置されているノードを探す処理のためクラスタにアクセスする必要はなく、コンテナを保持するノードに直に接続して処理をするため、通信のオーバヘッドを最小限としています。

GridDBではリバランス処理により、コンテナ配置は動的に変わりますが、クライアントキャッシュは定期的に更新されるため、コンテナの位置は透過です。タイミングによってクライアントからのアクセスでノードがミスヒットした時でも、自動的に再配置情報を取得して処理を継続します。

6.2.1 TQLとSQL

データベースのアクセス言語として、TQLとSQL-92準拠のSQLをサポートしています。

TQLとは

簡易版SQLとして、コンテナを単位とした検索、集計演算などの機能をサポートします。TQLはNoSQLインターフェースから利用します。

TQLは、小規模なコンテナに対して少量ヒットするような検索に適しています。データ量・ヒット件数が少ない場合には、SQLより低いレイテンシで検索できることが特徴です。ヒット件数を少量にする手段の一つとして、TQL構文のLIMIT節の指定があります。

大量データを含むコンテナを検索する場合は、SQLの利用を推奨します。

NewSQLインターフェースで作成したコンテナや、パーティショニングされたテーブルに対しても、TQLを利用することができます。パーティショニングされたテーブルに対するTQLについては、次の制限があります。

構文では、WHERE節の条件式によるフィルタリングが利用できます。集計演算、時系列データ選択・補間演算、最大値・最小値のロウ集合選択演算、ORDER BYなどは利用できません。

更新用ロックをかけることはできません。

TQLの詳細は『GridDB TQL リファレンス』(GridDB_TQL_Reference.html)を参照ください。

SQLとは

ISOで言語仕様の標準化が行われており、GridDBではSQL-92に準拠したデータの操作や定義を行うためのインターフェースをサポートします。SQLはNewSQLインターフェースから利用します。

NoSQLインターフェースで作成したコンテナに対しても、SQLを利用することができます。

SQLの詳細は『GridDB SQLリファレンス』(GridDB_SQL_Reference.html)を参照ください。

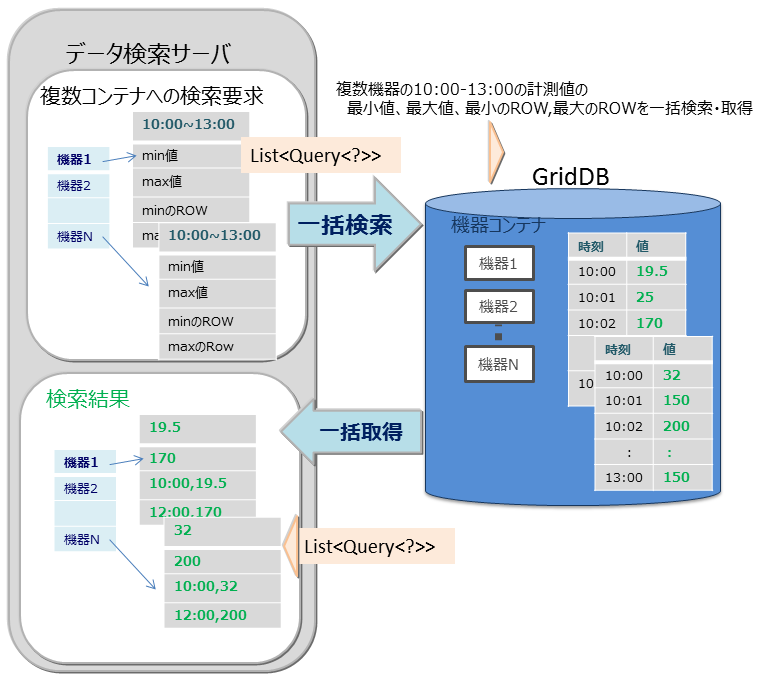

6.2.2 複数コンテナへの一括処理機能

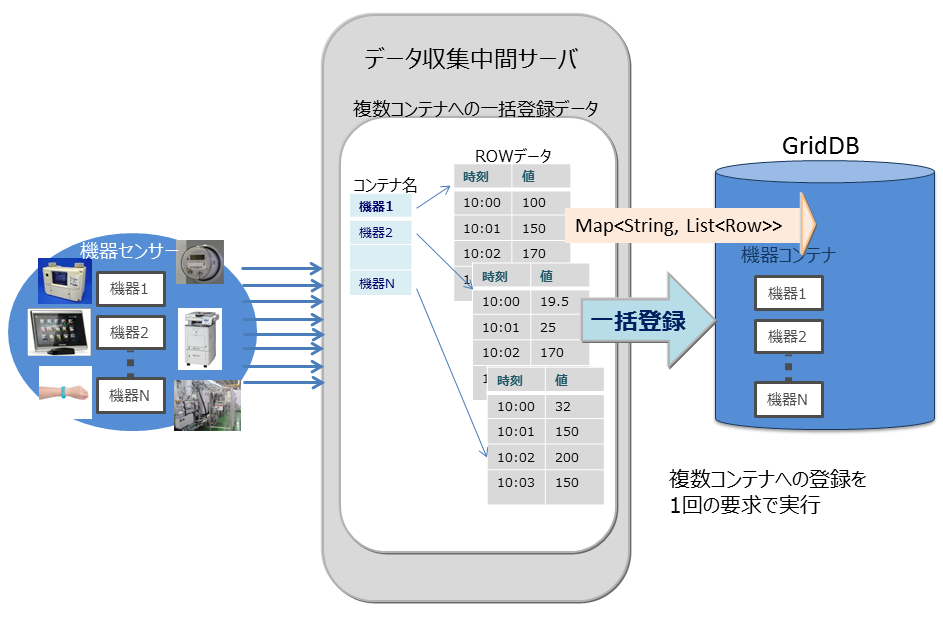

GridDBが提供するNoSQL I/Fでは、時々刻々発生するイベント情報を高速に処理するためのインターフェースを用意しています。

大量に発生するイベントを発生の都度データベースサーバに送信していると、ネットワークへの負荷が高くなりシステムのスループットがあがりません。通信回線帯域が狭い場合特に顕著な影響がでます。NoSQL I/Fでは複数のコンテナに対する複数のロウの登録や、複数のコンテナへの複数の問い合わせ(TQL)を1リクエストで処理するためのマルチ処理が用意されています。頻繁にデータベースサーバにアクセスしないため、システム全体のスループットがあがります。

以下に例を挙げます。

マルチプット(multiput)

複数のセンサのイベント情報をデータベースに登録する処理として、センサ名毎にコンテナを用意します。センサ名とセンサの時系列イベントのロウ配列を作り、複数のセンサ分まとめたリスト(Map)を作成します。このリストデータを1回のAPI呼び出しでGridDBのデータベースに登録します。

マルチプットのAPIでは、複数クラスタからなるGridDBのノードに対して、1個以上のコンテナへの登録要求をまとめて行うことで通信処理を効率化します。また、マルチ登録処理では、トランザクション実行時のMVCCは行わず、高速に処理します。

マルチプットでは、トランザクションのコミットは、autocommitとなります。1件単位にデータが確定されます。

マルチクエリ(fetchAll)

- センサのイベント情報を集計する処理などで、コンテナへのクエリ問い合わせを複数実行するのではなく、1つの問い合わせで実行することができます。たとえば、センサから取得したデータの一日の最大値、最小値、平均値などの集計結果の取得や、最大値や最小値をもつロウ集合や特定の条件に合致するロウ集合といったロウ集合のデータ取得を最適化します。

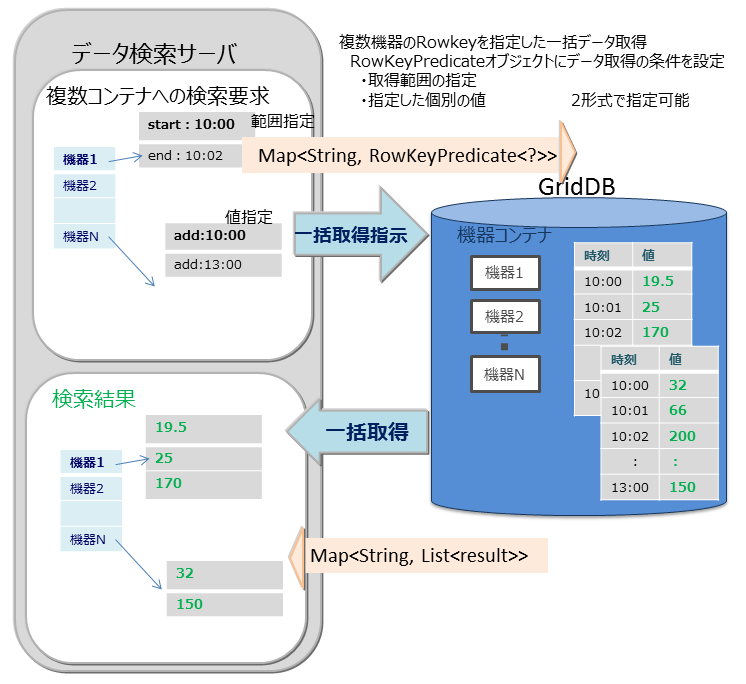

マルチゲット(multiget)

センサのイベント情報を取得する処理などで複数機器のRowkeyを指定した一括データ取得ができます。 RowKeyPredicateオブジェクトにデータ取得の条件を設定し、複数の機器のデータを一括で取得します。

RowKeyPredicateオブジェクトでは以下の2形式のいずれかで取得条件を設定します。

- 取得範囲の指定

- 指定した個別の値

6.3 索引機能

コンテナ(テーブル)のカラムに対し索引を作成することで、条件付き検索が高速に処理できます。

索引タイプにはツリー索引(TREE)、空間索引(SPATIAL)の2種類があります。設定できる索引はコンテナ(テーブル)のタイプやカラムのデータ型に応じて異なります。

- ツリー索引(TREE)

- 等価検索、範囲(より大きい/等しい、より小さい/等しいなど)を含む参照に利用します。

- 時系列コンテナ(時系列コレクション)のROWKEY(PRIMARY KEY)に対応するカラムを除く、任意種別のコンテナ(テーブル)における次に示す型のカラムに対して設定できます。

- STRING

- BOOL

- BYTE

- SHORT

- INTEGER

- LONG

- FLOAT

- DOUBLE

- TIMESTAMP

- ツリー索引のみ、複数のカラムを指定した索引を作成できます。これを複合索引と呼びます。1つの複合索引に指定できるカラム数の上限は16個で、同じカラムを複数回指定することはできません。

- 空間索引(SPATIAL)

- コレクションにおけるGEOMETRY型カラムに対してのみ設定できます。空間検索を高速に行う場合に指定します。

コンテナに作成できる索引の数に制限はありませんが、索引の作成は慎重に設計する必要があります。索引は、設定されたコンテナのロウに対して挿入、更新、または削除の各操作が実行されると更新されます。したがって、頻繁に更新されるロウのカラムに多数の索引を作成すると、挿入、更新、または削除の各操作でパフォーマンスに影響ができます。

索引は以下のようなカラムに作成します。

- 頻繁に検索されたり、ソートされたりするカラム

- TQLのWHERE節の条件で頻繁に使用されるカラム

- カーディナリティの高い(重複した値があまり含まれない)カラム

【メモ】

- テーブル(時系列テーブル)のカラムには、ツリー索引のみ設定できます。

6.4 時系列データ特有の機能

GridDBでは、高頻度で発生するセンサなどのデータ管理のために、メモリを最大限有効利用するデータ配置アルゴリズム(TDPA:Time Series Data Placement Algorithm)に従いデータ配置処理します。時系列コンテナ(時系列テーブル)では、内部データを周期性で分類しながらメモリ配置します。アフィニティ機能でヒント情報を与えるとさらに配置効率が上がります。また、データを必要に応じてディスクに追い出しながら、ほぼゼロコストで有効期限切れのデータを解放しています。

時系列コンテナ(時系列テーブル)は、TIMESTAMP型のROWKEY(PRIMARY KEY)を持ちます。

6.4.1 TQLの演算機能

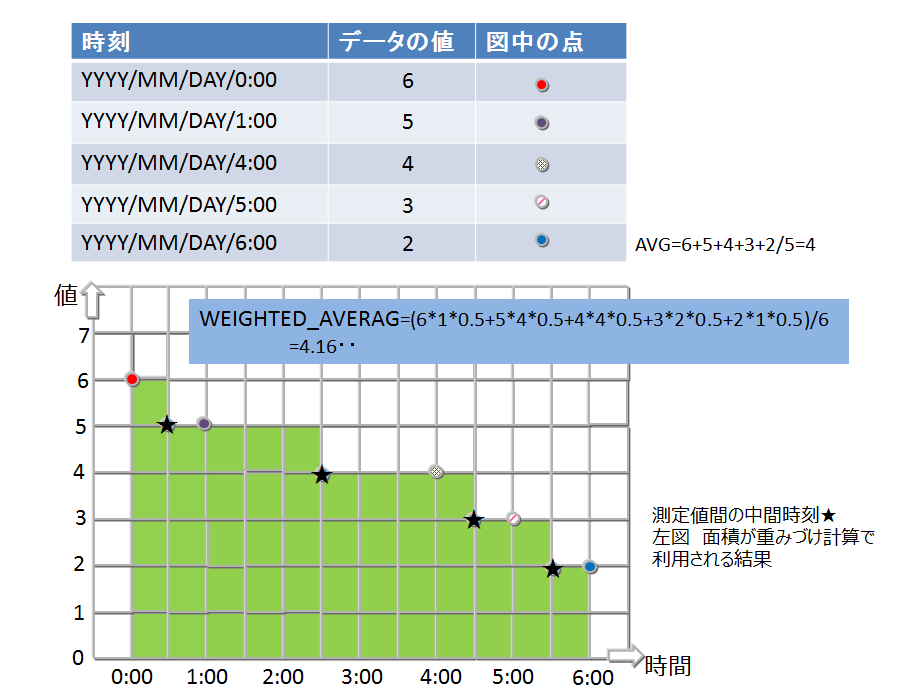

6.4.1.1 集計演算

採取したデータの時間間隔でデータに重みをつけて計算します。つまり、時間間隔が長い場合、長時間その値が続いたことを想定した計算となります。

集計演算には以下の関数があります。

TIME_AVG

- 重み付きで平均を求める演算です。

- 検索の条件に合致した各ロウについて、前後それぞれの時刻のロウとの中間時刻間の期間を特定の単位で換算したものを、重み付け値として使用します。条件で指定した時刻のロウのみが存在しない場合は、存在しないロウの代わりに条件に指定した時刻の直前、直後のロウを用いて重みづけ計算をします。

- 計算の詳細イメージを図示します。

6.4.1.2 選択・補間演算

時刻データは、収集されるデータの内容や収集タイミングにより想定した時刻より多少の時間のずれが発生することがあります。したがって時刻データをキーにして検索する際にも、指定した時刻周辺のデータが取得できる機能が必要です。

時系列コンテナ(時系列テーブル)を検索し、指定したロウを取得するための以下のような関数があります。

TIME_NEXT(*, timestamp)

指定の時刻と同一またはその直後の時刻を持つ1つのロウを選択します。

TIME_NEXT_ONLY(*, timestamp)

指定の時刻の直後の時刻を持つ1つのロウを選択します。

TIME_PREV(*, timestamp)

指定の時刻と同一またはその直前の時刻を持つ1つのロウを選択します。

TIME_PREV_ONLY(*, timestamp)

指定の時刻の直前の時刻を持つ1つのロウを選択します。

また、実体のロウのカラムの値を補間演算で計算するための以下のような関数があります。

TIME_INTERPOLATED(column, timestamp)

指定の時刻に関して、一致するロウの指定のカラムの値、または、隣接する前後のロウの指定カラムの値を線形補間して得られた値を求めます。

TIME_SAMPLING(*|column, timestamp_start, timestamp_end, interval, DAY|HOUR|MINUTE|SECOND|MILLISECOND)

開始・終了時刻を指定して、特定範囲のロウ集合をサンプリングします。

サンプリング位置の時刻は、開始時刻に対し非負整数倍のサンプリング間隔を加えた時刻のうち、終了時刻と同じかそれ以前のもののみです。

各サンプリング位置の時刻と一致するロウが存在する場合は該当ロウの値を使用します。存在しない場合は補間された値を使用します。

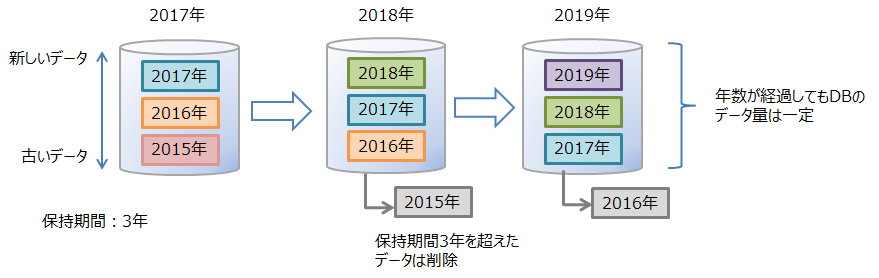

6.4.2 期限解放機能

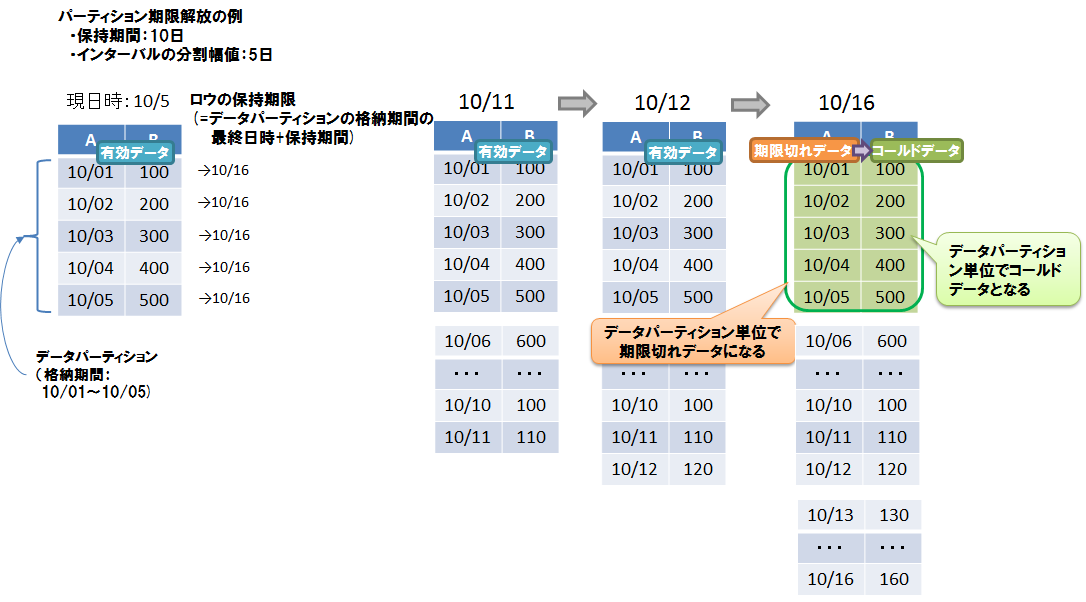

期限解放とは、設定した保持期間を超えたロウデータを、検索や削除などの操作対象から外して参照不可とした後、DBから物理的に削除する機能です。 利用されなくなった古いデータを操作の対象から外して削除することで、DBサイズを一定に保ち、データベースサイズ肥大化によるパフォーマンス低下を防ぐことができます。

保持期間はコンテナ単位に設定します。保持期間を越えたロウを「期限切れデータ」と呼びます。期限切れデータは参照不可となってAPIから操作できなくなるので、アプリケーションからはそのロウは存在しない状態になります。期限切れデータは、一定期間が経過すると、DBから物理的に削除する対象のデータになります。この削除対象となった期限切れデータを「コールドデータ」と呼びます。コールドデータは、そのまま自動的にDBから削除します。

6.4.2.1 期限解放の設定

期限解放は、パーティショニングされたコンテナ(テーブル)で利用可能です。

- インターバル、インターバルハッシュでパーティショニングされた以下のテーブルに設定できます。

- 時系列テーブル

- パーティショニングキーがTIMESTAMP型のコレクションテーブル

- 設定項目は、保持期間、保持期間の単位です。

- 保持期間の単位として設定できるのは、日/時/分/秒/ミリ秒の単位です。年単位、月単位の指定はできません。

- ロウの保持期限は、データパーティションのロウ格納期間の最終日時に保持期間を足した日時です。同じデータパーティションに格納されているロウは、全て同じ保持期限になります。

- コールドデータになる単位は、データパーティションです。物理的データ削除はデータパーティション単位で行われます。

【メモ】

期限解放の設定は、テーブル作成時に行います。作成後に設定を変更することはできません。

保持期限超過の判定に使用される現在時刻は、GridDBの各ノードの実行環境に依存します。したがって、ネットワークの遅延や実行環境の時刻設定のずれなどにより、クライアントの時刻よりGridDBのノードの時刻が進んでいる場合、期限切れ前のロウにアクセスできなくなる場合があります。逆にクライアントの時刻のみ進んでいる場合は、期限切れロウにアクセスできる場合があります。意図しないロウの喪失を避けるために、最低限必要な期間よりも大きな値を設定することを推奨します。

期限切れのロウは、検索や更新といったロウ操作の対象から外れ、存在しないものとみなされます。期限切れのロウに対して行われた操作はエラーにはなりません。

- 例) 保持期限が30日の設定の場合、現在から31日前の日時のロウを登録しても登録処理はエラーにはならず、かつ、テーブルにはそのロウは保存されません。

期限解放を設定する場合は、必ずクラスタの全ノードの時刻を同期してください。時刻がずれていると、ノード間で期限解放されるタイミングが異なるなどの問題が生じる場合があります。

期限切れデータからコールドデータになるまでの期間は、期限解放の保持期間の設定によって異なります。

保持期間 期限切れからコールドデータになるまでの最大期間 ~3日 約1.2時間 3日~12日 約5時間 12日~48日 約19時間 48日~192日 約3日 192日~768日 約13日 768日~ 約50日

6.4.2.2 コールドデータの自動削除

1秒間に1回、定期的にDBファイルの管理情報をスキャンして、その時点でコールドデータになっているロウを物理的に削除します。DBファイルの管理情報をスキャンする量は1回の実行につき2000ブロック分です。スキャンする量は、ノード定義ファイル(gs_node.json)の/dataStore/batchScanNumで設定できます。登録量が多いシステムなどでは、自動削除の速度が登録に追いつかずに、DBサイズが増加し続ける可能性があります。その場合はスキャンする量を増やしてください。

6.5 テーブルパーティショニング機能

複数ノードで動作するGridDBのアプリケーションを高速化するには、処理するデータをできるだけメモリに配置することが重要です。 データ登録数が多い巨大なコンテナ(テーブル)では、テーブルのデータを分割してノードに分散配置することで、複数ノードのCPUやメモリリソースを効率的に活用した処理が可能です。分割したデータは、「データパーティション」という複数の内部コンテナに格納します。データをどのデータパーティションに格納するかは、テーブル作成時に指定された「パーティショニングキー」のカラムの値を基に決定します。

GridDBではテーブルパーティショニングの方法として、ハッシュパーティショニング、インターバルパーティショニング、インターバル-ハッシュパーティショニングの3種類があります。

テーブルの作成・削除はNewSQLインターフェースのみ、データの登録・更新・検索はNewSQL/NoSQLインターフェースで実行できます。(一部制限があります。詳細はTQLとSQLを参照ください)

データ登録

テーブルにデータを登録すると、パーティショニングキーの値とパーティショニングの方法に応じて、適切なデータパーティションにデータが自動的に登録されます。データパーティションを直接指定してデータ登録することはできません。

索引

テーブルに索引を作成した場合、データパーティション単位でのローカル索引が作成されます。テーブル全体でのグローバル索引を作成することはできません。

データ操作

パーティショニングキーに指定したカラムがプライマリキーである場合、パーティショニングキーに対するデータ更新操作は、エラーになります。データを削除してから再登録してください。

パーティショニングキーに指定したカラムがプライマリキーでない場合、NoSQL I/Fでのみ更新操作が可能です。

期限解放機能

インターバル、インターバルハッシュでパーティショニングされた以下のテーブルに期限解放を設定できます。

- 時系列テーブル

- パーティショニングキーがTIMESTAMP型のコレクションテーブル

注意点

V4.3より、プライマリキーが存在する場合に、プライマリキー以外のカラムをパーティショニングキーに指定すると、デフォルトではエラーとなります。指定可能とするにはクラスタ定義ファイル(gs_cluster.json)の/sql/partitioningRowkeyConstraintにfalseを設定する必要があります。

プライマリキー以外のカラムをパーティショニングキーに指定した場合、プライマリキーの制約は、データパーティションの単位では保証しますが、テーブル全体では保証しません。そのため、テーブル全体としては、プライマリキーに同じ値が重複して登録される場合があります。

6.5.1 テーブルパーティショニングの利点

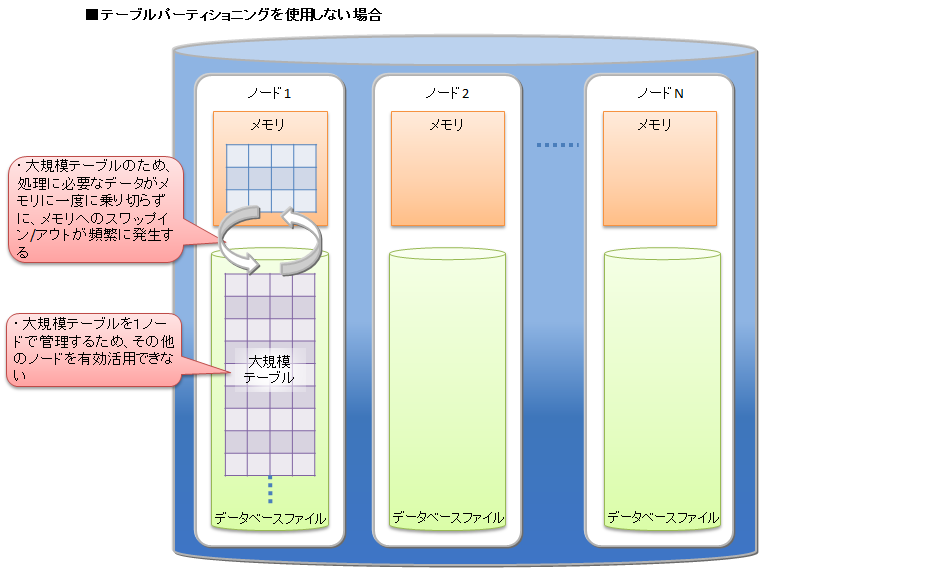

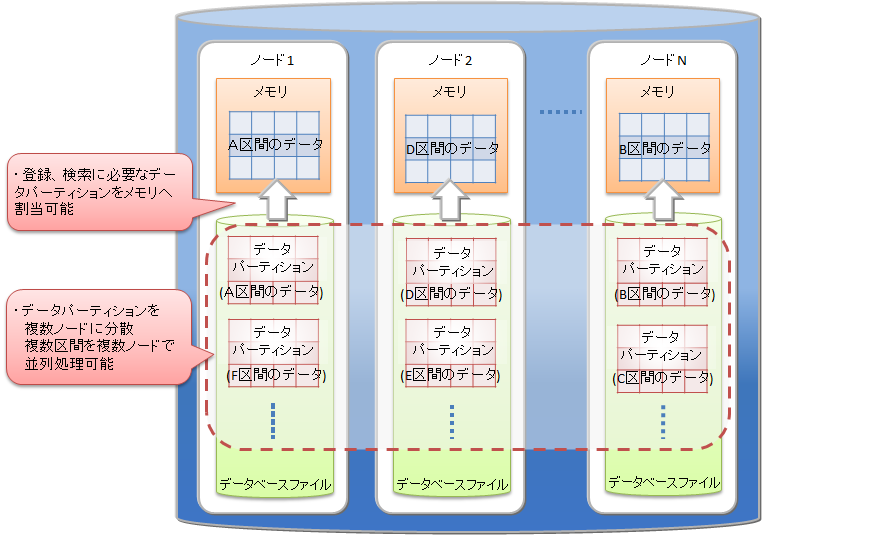

テーブルパーティショニングを利用して、大規模なデータを分割することで、メモリの効率的な利用や検索の処理対象データの絞込みによる性能向上の効果があります。

メモリの効率的な利用

登録や検索などの処理では、処理に必要なデータパーティションがメモリに読み込まれます。処理対象外のデータパーティションは読み込まれないため、処理対象のデータが局所的で一部のデータパーティションに集中する場合は、メモリ上に読み込むデータ量が少なくなります。メモリへのスワップイン/スワップアウトの頻度が低減して、パフォーマンスが向上します。

検索の処理対象データの絞込み

検索する際に、問合わせの絞込み条件に合致するデータパーティションのみを処理対象とします。必要ではないデータパーティショニングにはアクセスしません。この機能をプルーニングと呼びます。 処理対象となるデータ量が小さくなるため、パフォーマンスが向上します。プルーニングが有効になる問合せの絞込み条件は、パーティショニング種別ごとに異なります。

上記の点について、テーブルパーティショニングを利用しない場合と利用する場合の特徴を説明します。

テーブルパーティショニングを利用せずに大規模データをひとつのテーブルに格納する場合、処理に必要なデータをすべてメモリ上に載せることができず、メモリとデータベースファイル間でのスワップイン/スワップアウトが頻繁に発生してパフォーマンスが低下します。特に大規模テーブルのデータ量よりもGridDBノードのメモリが小さい場合に低下が顕著になります。また、テーブルに対するアクセスが1ノードに集中するため、並列度が低くなります。

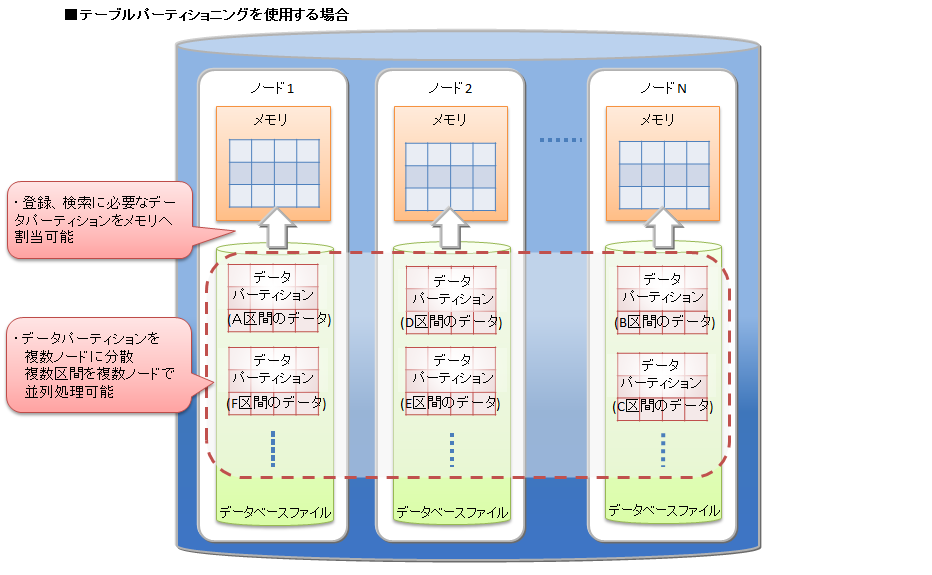

テーブルパーティショニングを利用した場合、大規模データを各データパーティションに分割して、複数ノードに分散配置します。

登録や検索などの処理の際には、処理に必要なデータパーティションがメモリに読み込まれます。処理対象外のデータパーティションは読み込まれないため、テーブルパーティショニングを使わない大規模テーブルと比較すると必要なデータ量は小さくなる場合が多く、メモリへのスワップイン/スワップアウトの頻度が低減します。各データパーティションにデータを偏りなく均等に分割した方が各ノードのCPUやメモリリソースを有効に活用することができます。

また、データパーティションはノードに分散配置されるため、データへの並列アクセスが可能になります。

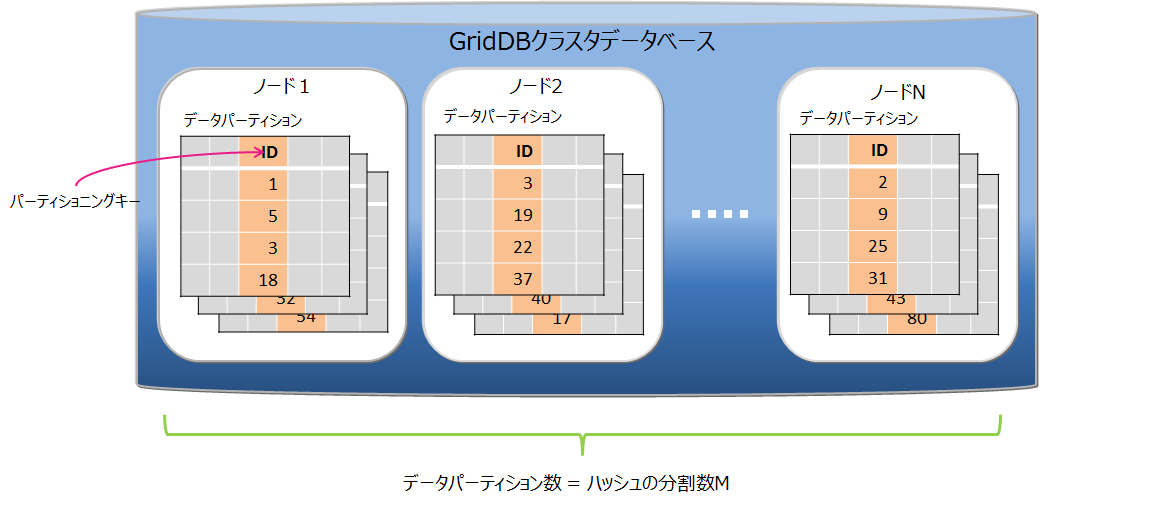

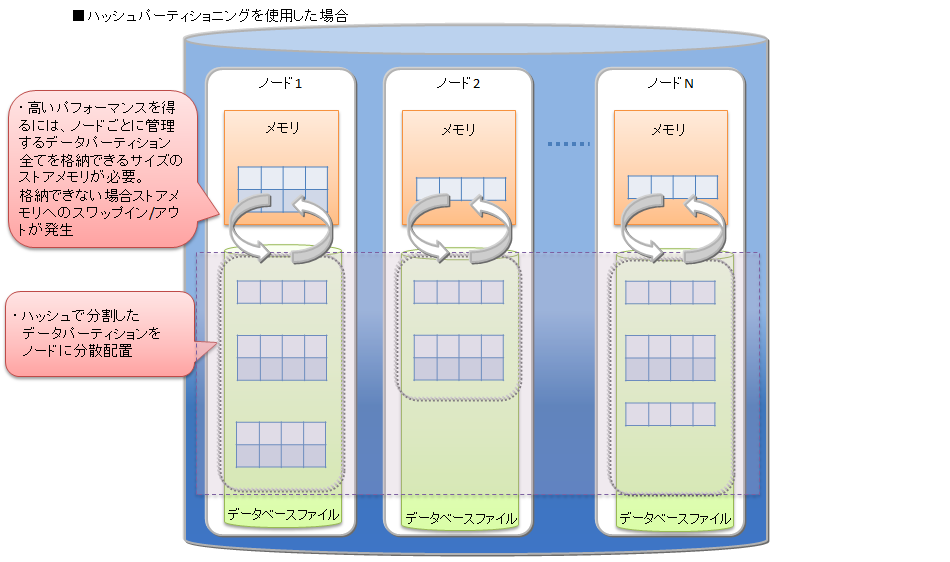

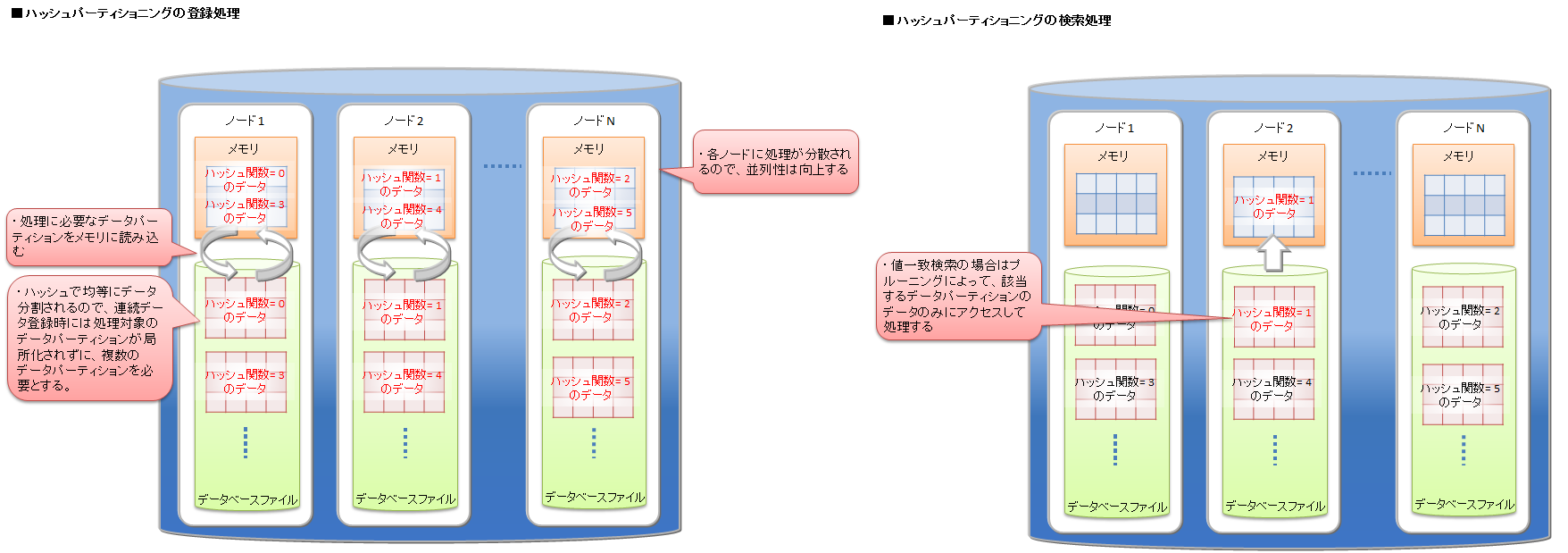

6.5.2 ハッシュパーティショニング

ハッシュパーティショニングでは、ハッシュ値 (HASH) に基づいてテーブルパーティションに均等にデータを分割して格納します。

高い頻度でデータ登録を行うアプリケーションシステムでの利用においては、テーブルの末尾にアクセスが集中し、待ち時間が発生する場合があります。ハッシュ分割を使用すると複数のテーブルが用意されるため、アクセス分散できます。

データの分割

パーティショニングキーとハッシュの分割数Mを指定されることで、パーティショニングキーの値から1~Mの整数を返すハッシュ関数を定義し、その返値に基づいてデータ分割を行います。分割数Mの最大値は1024です。

パーティショニングキー

パーティショニングキーに指定できるカラムのデータ型に制限はありません。

データパーティションの作成

テーブル作成時に、指定されたハッシュの分割数Mの数のデータパーティションを自動的に作成します。テーブル作成後は、データパーティションの数は変更できません。変更する場合は、テーブルの再作成が必要となります。

データパーティションの削除

データパーティション単体を指定して削除することはできません。

テーブルの削除により、そのテーブルを構成するデータパーティションをすべて削除します。

プルーニング

ハッシュの場合は、パーティショニングキーの値一致検索を行う場合にプルーニングが適用され、条件に適したデータパーティションのみ処理対象とするため、処理速度の向上やメモリ使用量削減の効果があります。

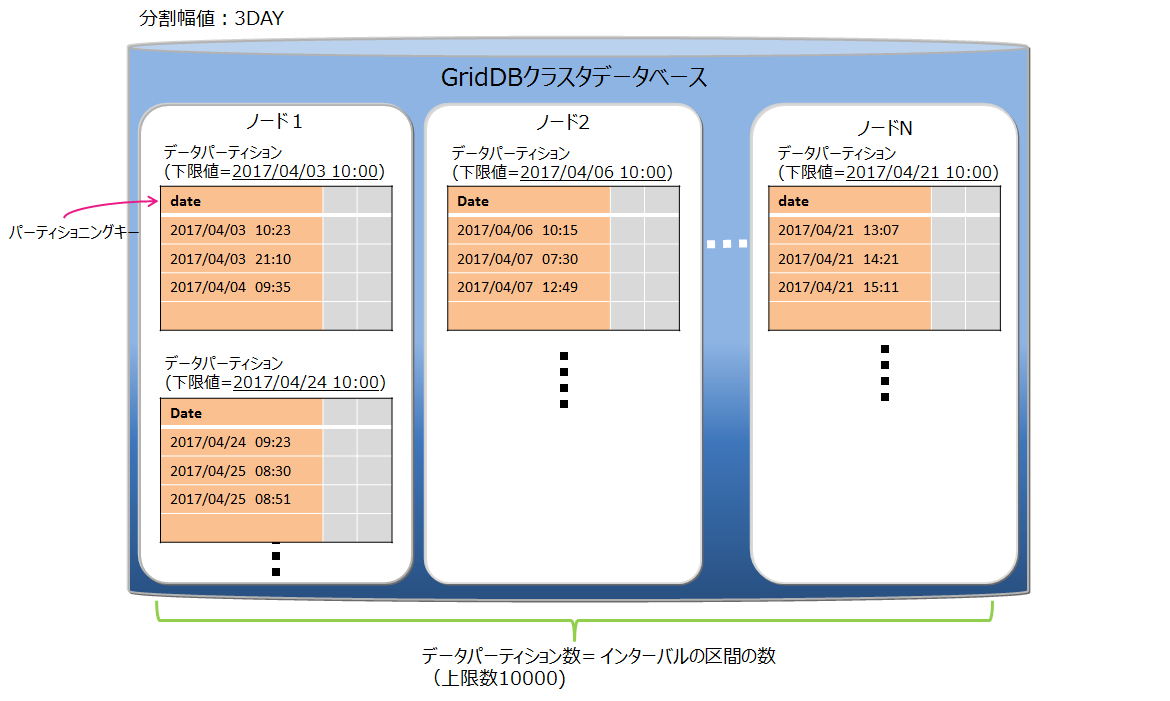

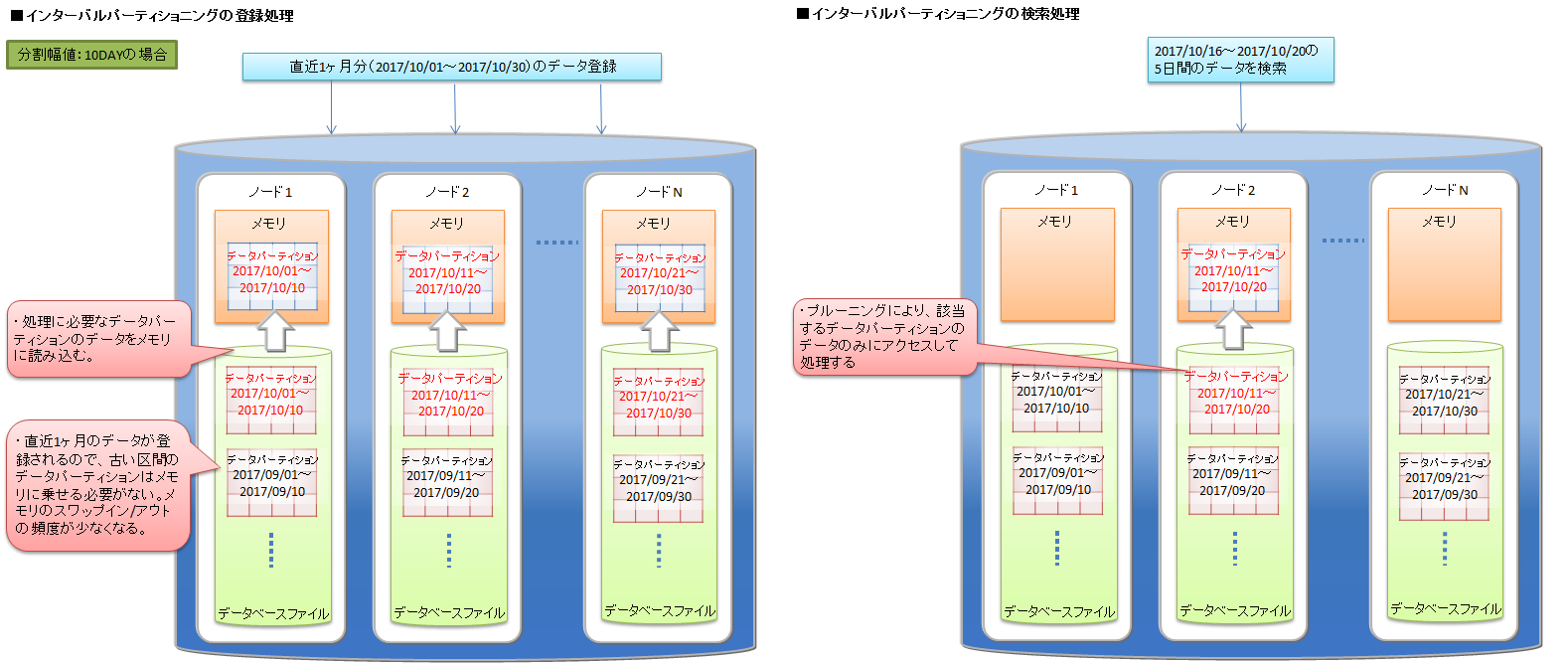

6.5.3 インターバルパーティショニング

インターバルパーティショニングでは、指定された一定の値間隔でデータを分割して、データパーティションに格納します。各データパーティションに格納するデータの区間(下限値から上限値)は、指定された値間隔を基に自動的に決定します。

ある一定の範囲の値を持つデータを同じデータパーティション上に格納するので、登録するデータが連続値の場合や、特定期間の範囲の検索を行う場合などに、より少ないメモリで処理できます。

データの分割

値間隔の基準値(分割幅値)に基づいてデータ分割を行います。 パーティショニングキーの型によって、指定できる分割幅値の範囲が異なります。

- BYTE型 : 1~27-1

- SHORT型 : 1~215-1

- INTEGER型 : 1~231-1

- LONG型 : 1000~263-1

- TIMESTAMP型 : 1以上

パーティショニングキーがTIMESTAMP型の場合は、単位に「DAY」を指定します。

パーティショニングキー

パーティショニングキーに指定できるデータ型は、BYTE型, SHORT型, INTEGER型, LONG型, TIMESTAMP型です。 パーティショニングキーはひとつのカラムで、NOT NULL制約を設定する必要があります。

データパーティションの作成

テーブル作成時には、データパーティションを作成しません。データ登録時、該当するデータパーティションが存在しない場合に、データパーティションを自動的に作成します。

データパーティション数の上限値は10000個です。データパーティション数が上限値に達すると、新規のデータパーティションが必要なデータ登録はエラーになります。エラーが発生した場合は、不要なデータパーティションを削除して、データ登録を再実行してください。

テーブル作成時には、登録するデータの分布とデータパーティション上限数10000を考慮して、分割幅値を決定してください。分割幅値に対してデータの範囲が幅広く、データパーティションが大量に作成されるようなテーブルでは、データパーティション削除のメンテナンスが頻繁に必要になります。

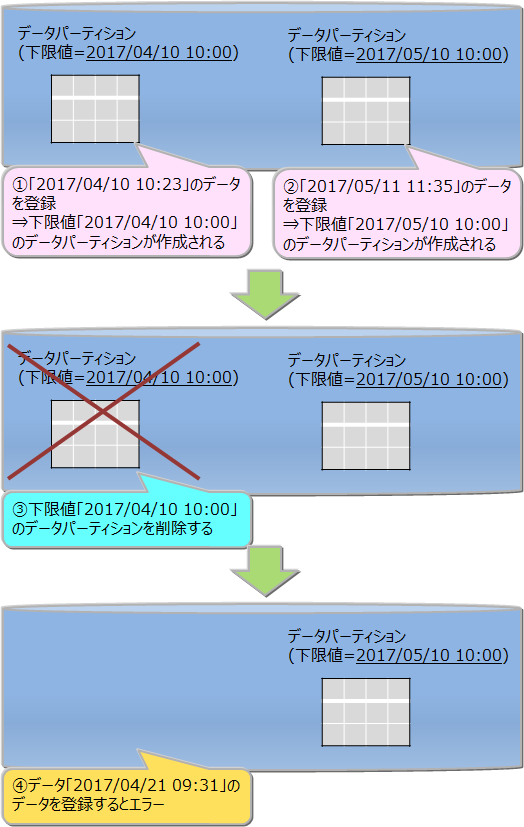

データパーティションの削除

データパーティション単体を削除できます。一度削除したデータパーティションは、再作成できません。削除したデータパーティションに対する新規データ登録はすべてエラーとなります。データパーティションを削除する前には、メタテーブルで削除対象のデータパーティションが管理するデータの範囲を確認してください。メタテーブルの詳細は『GridDB SQLリファレンス』(GridDB_SQL_Reference.html)をご参照ください。

テーブルを削除すると、そのテーブルを構成するデータパーティションをすべて削除します。

テーブル全体に対する検索を行った場合、すべてのデータパーティションが処理対象になるため、不要なデータパーティションはあらかじめ削除した方が効率的な検索ができます。

データパーティションのメンテナンス

データパーティション数が10000に達する場合、または、不要なデータパーティションがある場合は、データパーティションを削除してメンテナンスする必要があります。

データパーティション数の確認方法

データパーティションの情報を管理しているメタテーブルを参照して確認します。詳細は『GridDB SQLリファレンス』 (GridDB_SQL_Reference.html)を参照ください。

データパーティションの削除方法

テーブルパーティションの下限値を指定して削除を行います。詳細は『GridDB SQLリファレンス』(GridDB_SQL_Reference.html)を参照ください。

プルーニング

where句の条件にパーティショニングキーを指定した検索を行う場合、条件に適したデータパーティションのみ処理対象とするため、処理速度の向上やメモリ使用量削減の効果があります。

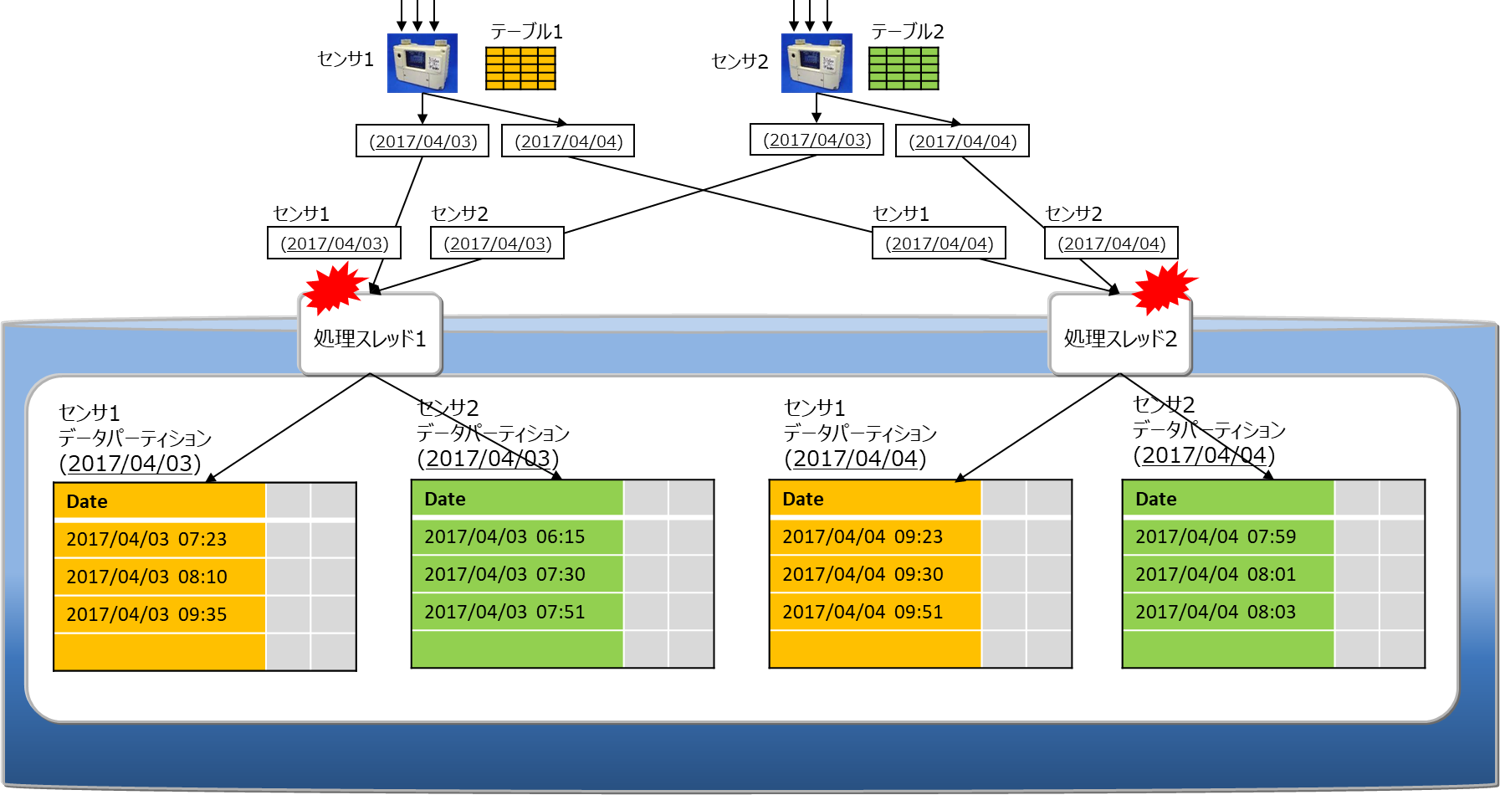

6.5.3.1 ユーザ指定データパーティション配置

対象テーブルがインターバルパーティションで、パーティショニングキーがTIMESTAMP型の場合は、ユーザがデータパーティションの配置先を指定したテーブル生成を行うことができます。

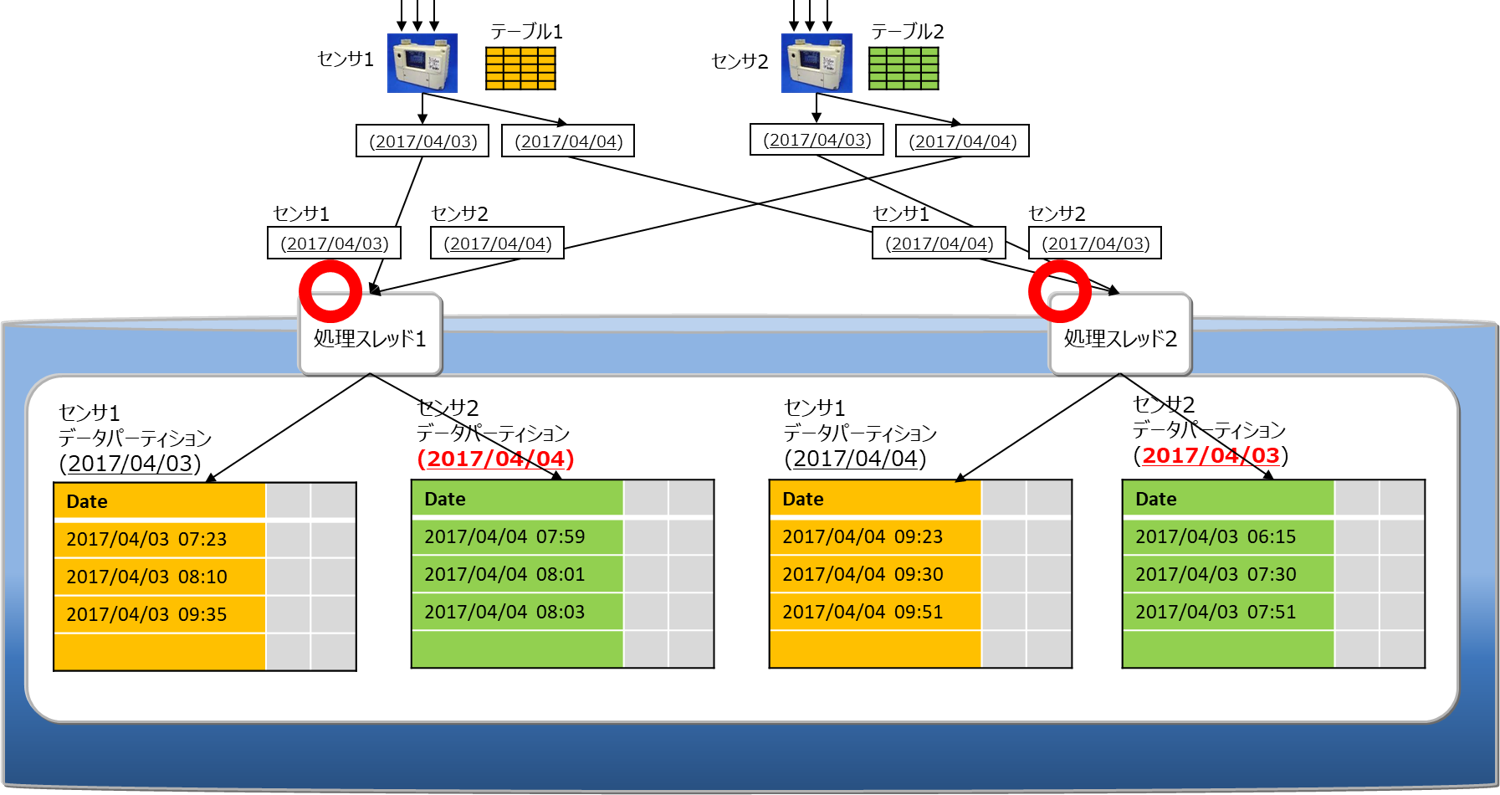

通常のテーブル生成SQLでは、データパーティションの配置先はサーバが独自の規則を用いて決定しますが、複数のインターバルパーティショニングテーブルに対して、特定の日付のデータパーティション配置先が競合する場合があります。下図はそれを示したもので、同一日時の配置先が競合により処理スレッドが競合するので、データ処理の同時実行性能が低下することがあります。

テーブル生成時に区間グループ番号を指定することで、データパーティションの配置に規則性を設けて、グループ番号が異なるテーブル同士は同一日時において処理スレッドが競合しないような割付が行われます。以下にその例を示します。

注意点 本機能を効果的に利用するには幾つか条件があり、それらを運用開始時点で検討する必要があります。

クラスタを構成する全ノードの並列度を揃えておく必要があります。また、テーブル生成以降は並列度を変更すると十分な効果が得られなくなるため、開始時点の並列度を維持した運用が必要となります。

競合を回避したいテーブルの個数は基本的には並列度以下となるようにテーブルの設計を行います。これ以上の指定を行った場合は性能が劣化するケースがあります。

安定した性能を維持し続けるには、テーブル生成した時点のクラスタノード構成および各ノードのオーナ、バックアップなどのクラスタパーティション配置を運用によって維持し続ける必要があります。また、ノード増設なども変動要因になるため、できる限り固定的な環境での運用が推奨となります。

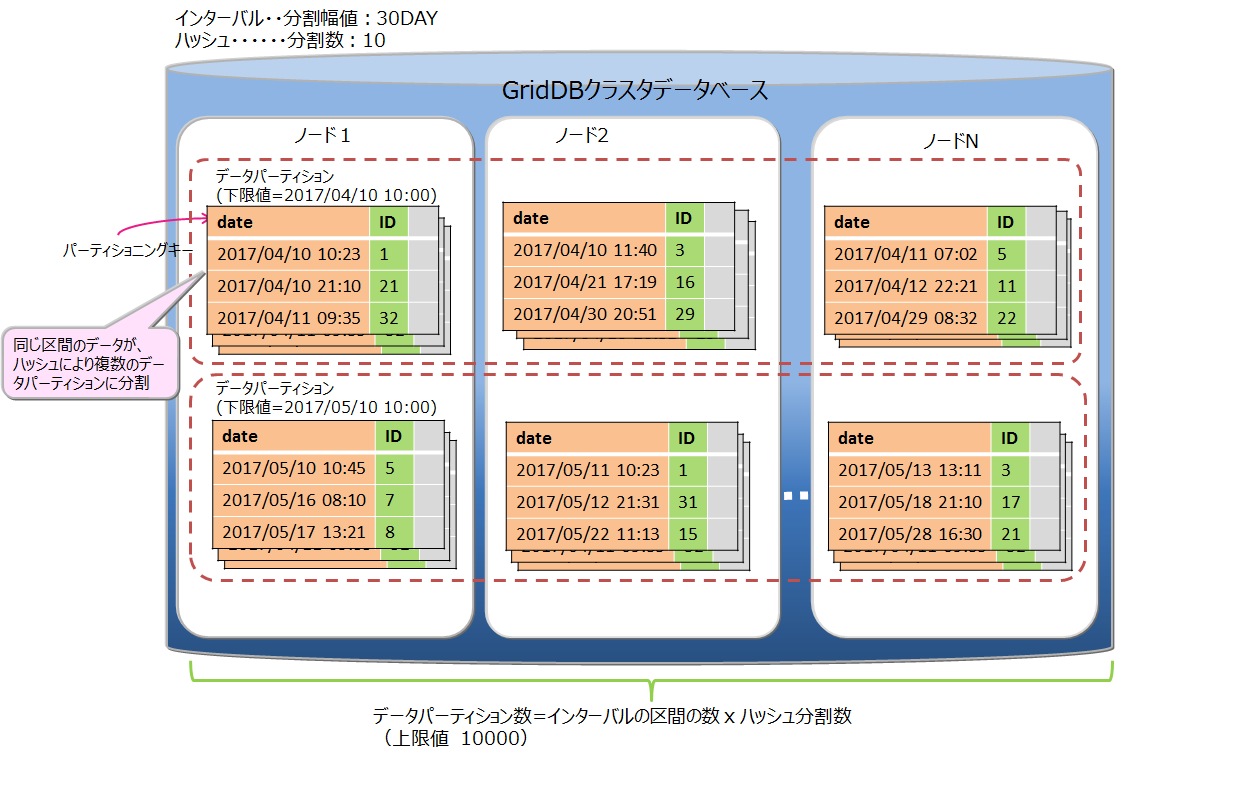

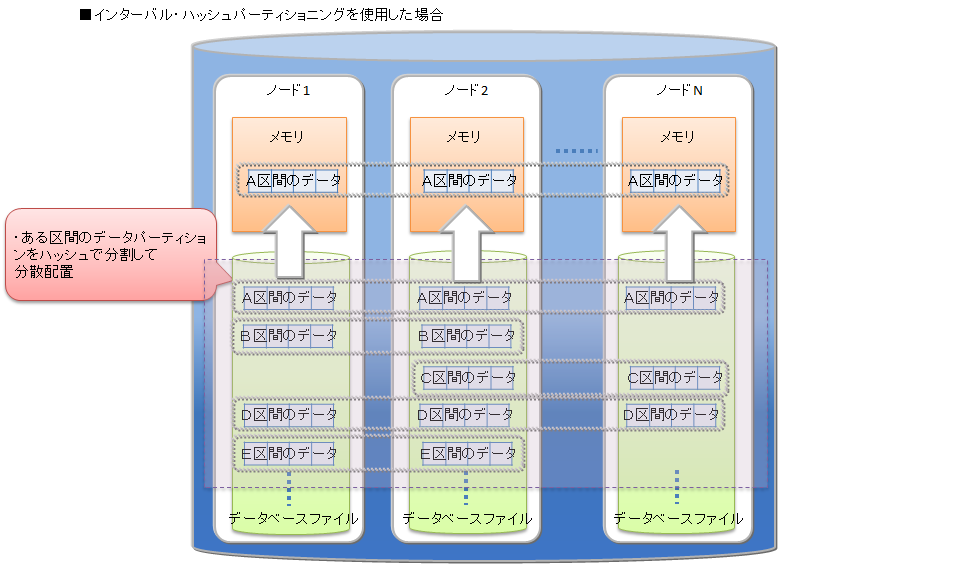

6.5.4 インターバル-ハッシュパーティショニング

インターバル-ハッシュパーティショニングは、インターバルパーティショニングとハッシュパーティショニングを組み合わせたものです。まずインターバルパーティショニングでデータを分割し、その分割されたデータに対して、さらにハッシュパーティショニングが行われます。 データパーティショニングの数は、インターバルパーティションニングによって分割した区間の数×ハッシュの分割数になります。

インターバルパーティショニングで分割したデータパーティションを、さらにハッシュによって適切にノードに分散することができます。一方で、データパーティション数が多くなることで、検索時のオーバヘッドが発生します。ノード分散と処理のオーバヘッドを考慮してご利用ください。

インターバル-ハッシュパーティショニングは、インターバルパーティショニングとハッシュパーティショニングを組み合わせたものなので、基本的な機能はそれぞれのパーティショニングの機能と同等です。インターバル-ハッシュパーティショニングに特有の点のみ説明します。

データの分割

インターバル-ハッシュパーティショニングでの分割幅値は、LONGの場合のみインターバルパーティションと値の範囲が異なります。

- BYTE型 : 1~27-1

- SHORT型 : 1~215-1

- INTEGER型 : 1~231-1

- LONG型 : 1000×ハッシュの分割数~263-1

- TIMESTAMP型 : 1以上

データパーティションの数

ハッシュで分割された数も含めて、データパーティション数の上限値は10000個です。上限に達した場合の動作やメンテナンスが必要な点については、インターバルパーティショニングと同様です。

データパーティションの削除

インターバルで分割した単位でデータパーティション群を削除できます。同じインターバル区間をハッシュ分割したデータパーティション単体の削除はできません。

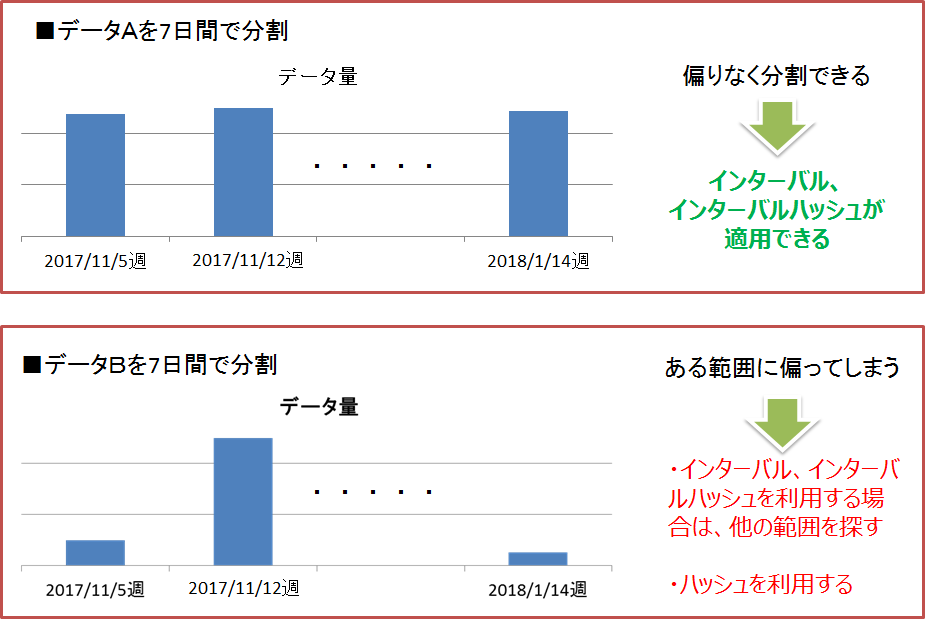

6.5.5 テーブルパーティショニング種別の選択基準

GridDBでは、テーブルパーティショニングの分割の種別として、ハッシュ、インターバル、インターバルハッシュをサポートします。

検索やデータアクセスの条件となるようなカラムを、テーブルを分割するためのパーティショニングキーとします。そのパーティショニングキーの値に対して、大量データを均等に分割するための範囲が決定できる場合にはインターバルパーティショニングもしくはインターバル-ハッシュパーティショニング、決定が困難な場合にはハッシュを選択します。

インターバルパーティショニング、インターバル-ハッシュパーティショニング

データを均等に分割するための区間(分割幅値)が事前に決定できる場合には、インターバルパーティショニングを選択します。 インターバルパーティションへの問合せでは、プルーニングによって、条件に合致するデータパーティションのみにアクセスして結果を取得するため、パフォーマンスが改善します。また、検索だけでなく、特定の範囲にデータを連続登録する場合もパフォーマンスが改善します。

インターバルパーティショニング 従って、インターバルパーティショニングを利用する場合は、アプリケーションで頻繁に登録・検索するデータ範囲を意識して分割幅値を決定することで、使用するメモリの削減が可能です。例えば、センサデータなどの時系列データで、かつ直近データに対する検索が多いシステムの場合には、検索対象の範囲をインターバルパーティショニングの分割幅値にすると、処理対象となるデータパーティションサイズのメモリで検索のパフォーマンスを保つことができます。

インターバルパーティショニングの登録と検索処理の例 さらに、インターバル-ハッシュパーティショニングを利用して、インターバルパーティショニングで分割したデータパーティションをハッシュパーティショニングで均等分割してノードに分散配置することで、特定範囲のデータに対する並列アクセスも可能になります。

インターバルハッシュパーティショニング ハッシュパーティショニング

格納するデータの特徴が事前にわからない場合、また、データを均等に分割可能な区間をあらかじめ決めることが困難な場合には、ハッシュパーティショニングを選択します。パーティショニングキーにユニークな値のカラムを指定することで、自動的に大量データを均等分割することができます。

ハッシュパーティショニング ハッシュパーティショニングにより、テーブル全体への並列アクセス、および一致検索に限ってパーティションプルーニングが可能なため、システムのパフォーマンスを改善できます。ただし、高いパフォーマンスを得るためには、ノード毎に管理するテーブルパーティション全てを格納できるサイズのメモリが必要です。

ハッシュパーティショニングの登録と検索処理の例

6.6 トランザクション機能

GridDBではコンテナ単位のトランザクション処理をサポートし、トランザクションの特性として一般的に言われるACID特性をサポートしています。以下にトランザクション処理でサポートしている機能の詳細を説明していきます。

6.6.1 トランザクションの開始と終了

コンテナに対して、ロウの検索・更新などの操作を行ったときに新たなトランザクションが開始され、データの更新結果を確定(コミット)または破棄(アボート)した時にトランザクションが終了します。

【メモ】

- コミットとは、処理中のトランザクションの情報を確定し、データを永続化させる処理です。

- GridDBではコミット処理でトランザクションの更新したデータがトランザクションログとして保管され、保持していたロックが解放されます。

- アボートとは、トランザクションの処理途中のデータをすべてロールバックする(処理を取り消す)処理です。

- GridDBでは処理途中のデータはすべて破棄され、保持していたロックも解放されます。

トランザクションの初期の動作はautocommit(自動コミット)に設定されています。

autocommitでは、アプリケーションからのコンテナに対する更新(データの追加、削除、変更)操作開始毎に新たなトランザクションが開始され、操作終了とともに自動的にコミットされます。 autocommitをオフにすることで、アプリケーションからの要求に応じたタイミングでトランザクションのコミット、アボートを指示できます。

トランザクションのライフサイクルは、トランザクションのコミットやアボートによる完了とともにタイムアウトによるエラー終了があります。トランザクションがタイムアウトによりエラー終了した場合、そのトランザクションはアボートされます。トランザクションのタイムアウトは、トランザクションが開始してからの経過時間です。 トランザクションのタイムアウト時間は、アプリケーション単位にGridDBに接続する際のパラメータとして指定することができます。また、タイムアウト時間の上限値はノード定義ファイル(gs_node.json)に設定できます。

6.6.2 トランザクションの一貫性レベル

トランザクションの一貫性レベルにはimmediate consistencyとeventual consistencyの2種類があります。この指定はアプリケーションごとにGridDBに接続する際のパラメータとして指定することもできます。 デフォルトはimmediate consistencyです。

immediate consistency

- コンテナに対する他のクライアントからの更新結果は、該当トランザクションの完了後即座に反映されます。そのため、常に最新の内容を参照します。

eventual consistency

- コンテナに対する他のクライアントからの更新結果は、該当トランザクションが完了した後でも反映されていない場合があります。 そのため、古い内容を参照する能性があります。

immediate consistencyは更新操作、読み取り操作で有効です。 eventual consistencyは読み取り操作でのみ有効です。 常に最新の結果を読み取る必要のないアプリケーションではeventual consistencyを指定すると読み取り性能が向上します。

6.6.3 トランザクションの隔離レベル

データベースの内容は常に整合性が保たれている必要があります。 複数のトランザクションを同時実行させたとき、一般に以下の現象が課題として挙がります。

ダーティリード

トランザクションが書き込んだコミットされていないデータを、別のトランザクションで読み込んでしまう現象です。

反復不能読み取り

トランザクション内で以前読み込んだデータを再読み込みできなくなる現象です。トランザクション内で以前読み込んだデータを再度読み込もうとしても、別のトランザクションがそのデータを更新、コミットしたために、以前のデータが読み込めなくなります(更新後の新しいデータを読み込むことになります)

ファントムリード

トランザクション内で以前得られた問い合わせの結果が得られなくなる現象です。トランザクション内で以前実行した問い合わせを再実行しても、別のトランザクションがその問い合わせ条件を満たすデータを変更、追加し、コミットしたために、同じ条件で問い合わせを実行しても、以前の結果が得られなくなります(更新後のデータを得ることになります)。

GridDBでは、トランザクションの隔離レベルとして「READ_COMMITTED」をサポートしています。 READ_COMMITTEDでは、確定した最新データを常に読み取ります。

トランザクションを実行する場合、他のトランザクションからの影響を受けないように配慮する必要があります。隔離レベルは、実行トランザクションを他のトランザクションからどの程度隔離するか(どの程度整合性を保てるか)を示す指標であり、4つのレベルがあります。

4つの隔離レベルおよび、それに対して同時実行時の課題であげた現象が起こる可能性は以下のとおりです。

| 隔離レベル | ダーティリード | 反復不能読み取り | ファントムリード |

|---|---|---|---|

| READ_UNCOMMITTED | 発生の可能性あり | 発生の可能性あり | 発生の可能性あり |

| READ_COMMITTED | 安全 | 発生の可能性あり | 発生の可能性あり |

| REPEATABLE_READ | 安全 | 安全 | 発生の可能性あり |

| SERIALIZABLE | 安全 | 安全 | 安全 |

READ_COMMITEDでは、以前読み込んだデータを再度読み込んだ場合に、以前のデータとは異なるデータを得たり、問い合わせを再実行した場合に、同じ検索条件で問い合わせを実行しても異なる結果を得てしまうことがあります。これは前回の読み込み後に、別のトランザクションによって更新、コミットが行われ、データが更新されたためです。

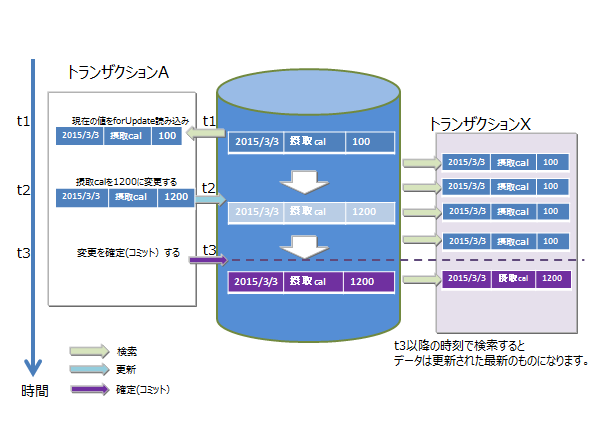

GridDBでは、MVCCによって、更新中のデータを隔離しています。

6.6.4 MVCC

GridDBでは、READ_COMMITTEDを実現するために「MVCC(Multi-Version Concurrency Control:多版型同時実行制御方式)」を採用しています。

MVCCとは、各トランザクションがデータベースに対して問い合わせるときに、別のトランザクションが更新中の最新のデータでなく、更新前のデータを参照して処理を行う方式です。更新前のデータを参照してトランザクションを並行実行できるため、システムのスルー プットが向上します。

実行中のトランザクションの処理がコミットすると、他のトランザクションも最新のデータを参照できます。

6.6.5 ロック

コンテナに対する複数トランザクションからの更新処理要求競合時の一貫性を保つため、データのロック機構があります。

ロックの粒度は、コンテナの種別に応じて異なります。またロックの範囲は、データベースへの操作の種別に応じて異なります。

6.6.5.1 ロックの粒度

コンテナの種別ごとのロックの粒度は次のとおりです。

- コレクション・・・ロウ単位でロックします。

- 時系列コンテナ・・・ロウ集合でロックされます。

- 時系列コンテナは、ブロックをいくつかに分割したデータ処理の単位に複数のロウを配置します。 このデータ処理の単位をロウ集合とよびます。コレクションでのロックの粒度よりもデータ粒度が荒いですが、大量に発生する時系列コンテナを高速に処理するためのデータの管理の単位です。

これらは、コンテナの種別ごとのユースケースの分析に基づいています。

- コレクションデータはRDBのテーブルと同様にデータを管理するため、既存のロウデータが更新されるケースがある

- 時系列コンテナは時々刻々発生するデータを保持するデータ構造であり、特定の時刻のデータが更新されるケースは少ない

6.6.5.2 データベース操作によるロック範囲

コンテナへの操作にはデータの登録、削除のみならず、データ構造の変更に伴うスキーマ変更や、アクセス高速化のための索引作成などの操作があります。ロック範囲は、コンテナ全体への操作、またはコンテナのロウ単位の操作のいずれかによって異なります。

コンテナ単位のロック

- 索引操作(createIndex/dropIndex)

- コンテナ削除

- スキーマ変更

ロックの粒度に従ったロック

- put/update/remove

- get(forUpdate)

ロウへのデータ操作ではロックの粒度に沿ったロックを確保します。

ロック確保で競合した場合、先行したトランザクションがコミットもしくはロールバック処理で実行が完了しロックを解放するまで、後続のトランザクションはロック確保待ちとなります。

ロック確保待ちは、トランザクションの実行完了以外では、タイムアウトでも解消されます。

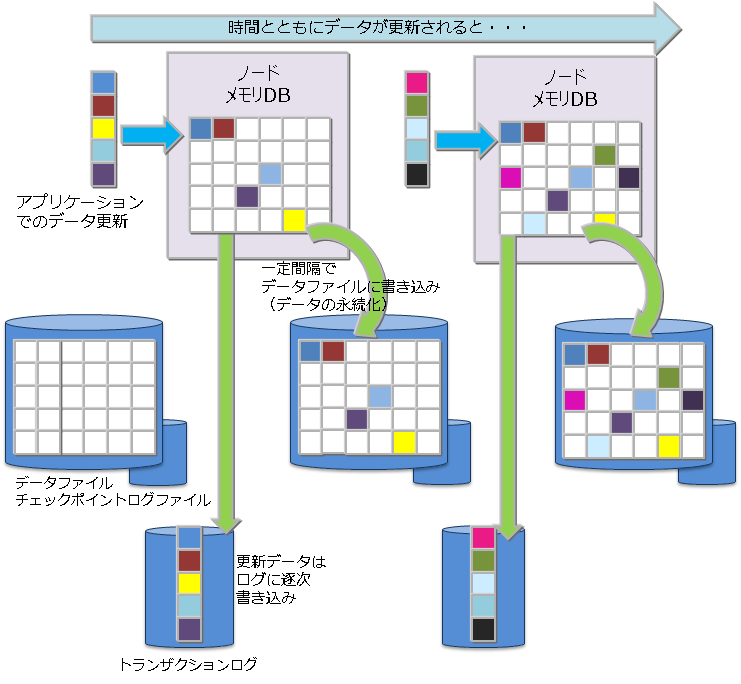

6.6.6 データ永続化

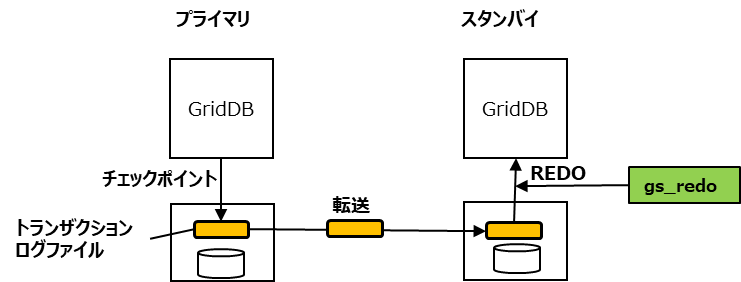

コンテナやテーブルに登録・更新されたデータは、ディスクやSSDに永続化され、ノード障害発生時のデータ消失から保護されます。メモリ上の更新データをブロック単位にデータファイル・チェックポイントログファイルに定期的に保存するチェックポイント処理と、データ更新に同期して更新データをシーケンシャルにトランザクションログファイルに書き込むトランザクションログ処理の2つの処理があります。

トランザクションログの書き込みには、以下のいずれかをノード定義ファイルに設定できます。

- 0: SYNC

- 1以上の整数値: DELAYED_SYNC

"SYNC"では、更新トランザクションのコミット・アボートごとに、ログ書き込みを同期的に行います。"DELAYED_SYNC"では、更新時のログ書き込みを、更新タイミングとは関係なく、指定秒数毎に遅延して行います。デフォルト値は"1(DELAYED_SYNC 1秒)"です。

"SYNC"を指定するとノード障害発生時に最新の更新内容を消失する可能性が低くなりますが更新が多いシステムでは性能に影響します。

一方、"DELAYED_SYNC"を指定すると、更新性能は向上しますが、ノード障害発生時ディスクに書き込まれていない更新内容があるとそれらが失われます。

クラスタ構成でレプリカ数が2以上の場合は、他のノードにレプリカを持つため、"DELAYED_SYNC"設定でも1ノード障害時に最新の更新内容を失う可能性は低くなります。 更新頻度が高く、性能が要求される場合には、"DELAYED_SYNC"を設定することも考慮してください。

チェックポイントでは、更新ブロックをデータベースファイルに更新します。 チェックポイント処理は、ノード単位に設定したサイクルで動作します。チェックポイントのサイクルはノード定義ファイルのパラメータで設定します。初期値は、60秒です。

チェックポイントの実行サイクルの数値を上げることで、ディスクへの永続化を夜間に実施するなど比較的時間に余裕がある時間帯に設定することができます。一方サイクルを長くした場合に、システム処理外でノードを再起動した際にロールフォワードすべきトランザクションログファイルが増え、リカバリ時間が増えるという欠点もあります。

6.6.7 タイムアウト処理

タイムアウト処理は、NoSQL I/F、NewSQL I/Fで設定できる内容が異なります。

6.6.7.1 NoSQL I/Fのタイムアウト処理

NoSQL I/Fでは、アプリケーション開発者に通知されるタイムアウトには2種類のタイムアウトがあります。アプリケーションの処理時間の制限に関するトランザクションタイムアウトと、障害発生時の回復処理のリトライ時間に関するフェイルオーバータイムアウトの2つです。

トランザクションタイムアウト(transactionTimeout)

処理対象のコンテナにアクセスを開始してからタイマが開始され、指定した時間を超えるとタイムアウトが発生します。

長時間更新ロックを保有するトランザクション(更新モードで検索し、ロックを保持したまま解放しないアプリケーション)や長時間大量の結果セットを保持するトランザクション(長時間、クラスタシステムのメモリを解放しないアプリケーション)などからロックやメモリを解放するために用意されたタイムアウト時間です。トランザクションタイムアウトに達したらアプリケーションはアボートされます。

トランザクションタイムアウトは、クラスタ接続時のパラメータとしてアプリケーションで指定できます。タイムアウト時間の上限値はノード定義ファイルで指定します。 タイムアウト時間の上限値の初期値は300秒です。処理に長時間かかるトランザクションの発生を監視をするためには、システムの要件に合わせてタイムアウト時間とその上限値を設定してください。

フェイルオーバータイムアウト(failoverTimeout)

クラスタを構成するノードに障害が発生したとき、ノードに接続しているクライアントが代替えノードに接続する際のエラーリトライ時のタイムアウト時間です。リトライ処理で新たな接続先が見つかった場合、クライアントアプリケーションにはエラーは通知されません。フェイルオーバータイムアウトは、初期接続時のタイムアウトにも利用されます。

フェイルオーバータイムアウトは、クラスタ接続時のパラメータとしてアプリケーションで指定できます。システムの要件に合わせてタイムアウト時間を設定してください。

トランザクションタイムアウト、フェイルオーバータイムアウトともに、Java APIやC APIでGridStoreオブジェクトを用いてクラスタに接続する際に設定できます。詳細は『GridDB Java APIリファレンス』(GridDB_Java_API_Reference.html)や『GridDB C APIリファレンス』(GridDB_C_API_Reference.html)を参照ください。

6.6.7.2 NewSQL I/Fのタイムアウト処理

NewSQL I/Fでは、ログイン(接続)タイムアウト、ネットワーク応答タイムアウト、クエリタイムアウトの3種類のタイムアウトがあります。

ログイン(接続)タイムアウト

クラスタに初期接続する際のタイムアウトです。初期設定は5分に設定されていますが、APIのDriverManagerで変更可能です。

ネットワーク応答タイムアウト

クライアントとクラスタ間の応答監視でのタイムアウトです。GridDBの現バージョンでは、タイムアウトは5分であり、タイムアウト時間の変更はできません。

クライアントからの通信で15秒間サーバが無応答の場合にはリトライし、5分間応答がない場合タイムアウトとなります。長時間のクエリ処理中にタイムアウトとなることはありません。

クエリタイムアウト

実行するクエリ単位にタイムアウト時間を設定できます。初期設定ではタイムアウト時間は設定されていません。(長時間のクエリ実行を許容しています。)長時間クエリの監視をするために、システムの要件に合わせてタイムアウト時間を設定してください。設定は、APIのStatementで設定できます。

6.7 レプリケーション機能

クラスタを構成する複数のノード間では、ユーザが設定したレプリケーション数に従って、パーティション単位にデータのレプリカが作成されます。

データのレプリカを分散ノード間で保持することで、ノード障害が発生しても、ノンストップで処理を継続できます。クライアントAPIでは、ノードの障害を検出すると、自動的にレプリカを保持する別ノードにアクセスを切り替えます。

レプリケーション数のデフォルト値は2で、複数ノードのクラスタ構成で動作した場合、データが2重化されます。

コンテナに更新があると、多重化されたパーティションのうちオーナノード(レプリカのマスタを持つノード)が更新されます。

その後オーナノードから更新内容がバックアップノードに反映されますが、その方法は2つあります。

非同期レプリケーション

更新処理のタイミングと同期せずにレプリケーションを行います。準同期レプリケーションに対して更新性能に優れますが、可用性では劣ります。

準同期レプリケーション

更新処理のタイミングで同期的にレプリケーションを行いますが、レプリケーション完了の待ち合わせは行いません。可用性の面では優れますが、性能面では劣ります。

可用性よりも性能を重視する場合は非同期レプリケーションに、可用性を重視する場合は準同期レプリケーションに設定してください。

【メモ】

- レプリケーション数の設定は、クラスタ定義ファイル(gs_cluster.json)の/cluster/replicationNumで設定します。 レプリケーションの同期設定は、クラスタ定義ファイル(gs_cluster.json)の/transaction/replicationModeで設定します。

6.8 データ同期機能

ノードに障害が発生した場合システムは自動的にレプリカを復旧してデータを再配置します。この機能を「自律的データ配置機能」と呼びます。このレプリカ復旧にはデータ同期機能が用いられますが、これは以下の2通りのいずれかが用いられます。

A) 差分トランザクションログを用いた同期方法

B) オリジナルのデータファイルを用いた同期方法

多くの場合A)のほうが高速にデータ同期を行うことができますが、データ同期に必要な差分トランザクションログが削除された場合はB)の方法で実行されます。 A)のデータ同期を優先的に行いたい場合は以下の設定を行ってください。障害発生から指定時間はデータ同期で利用するトランザクションログファイルが削除されにくくなります。ただし、保持するトランザクションログファイル数が増加するため、本機能を利用する際は十分なディスク空きがあることを確認してください。

| パラメータ | 初期値 | パラメータの意味と制限値 | 変更 |

|---|---|---|---|

| /sync/enableKeepLog | false | 本機能を利用する場合はtrueを設定します。 また配置表の固定化指定もあわせて有効とする必要があります(詳細は配置表の固定化指定を参照) | オンライン |

| /sync/keepLogInterval | 1200s | 障害発生から指定時間トランザクションログファイルの削除をできる限り抑制します。 | オンライン |

6.9 アフィニティ機能

アフィニティ機能とは、関連のあるデータを結びつける機能です。GridDBではアフィニティ機能として、データアフィニティとノードアフィニティの2種類を提供します。

6.9.1 データアフィニティ

データアフィニティには、複数のコンテナ(テーブル)をグループ化して別ブロックに配置する機能と、各コンテナ(テーブル)毎に別ブロックに配置する機能があります。

6.9.1.1 複数のコンテナをグループ化して別ブロックに配置

同じパーティションに配置されたコンテナ(テーブル)を、ヒント情報を元にグルーピングして、それぞれ別ブロックに配置するための機能です。各ブロックに関連性の強いデータのみ格納することで、データアクセスの局所化を図り、メモリヒット率を高めることができます。

ヒント情報は、コンテナ(テーブル)作成時にプロパティとして与えます。使用できる文字列は、コンテナ(テーブル)名の命名規則と同様に制限があります。

同じヒント情報があるデータをできるだけ同じブロックに配置します。ヒント情報はデータの更新頻度や参照頻度に応じて設定します。 たとえば、分単位、日単位、月単位、年単位にデータをサンプリングや参照する監視システムに対して、以下のような利用方法でシステムのデータが登録・参照・更新される場合のデータ構造を考えます。

- 監視機器から分単位のデータが送信され、監視機器単位に作成したコンテナにデータを保存

- 日単位のデータレポート作成のため、一日分のデータの集計を分単位データから行い、日単位コンテナ(テーブル)に保存

- 月単位のデータレポート作成のため、日単位コンテナ(テーブル)のデータの集計を行い、月単位コンテナ(テーブル)に保存

- 年単位のデータレポート作成のため、月単位コンテナ(テーブル)のデータの集計を行い、年単位コンテナ(テーブル)に保存

- カレントの使用量(分単位、日単位)は常に表示パネルに更新表示

GridDBでは、コンテナ単位にブロックを占有するのではなく、ブロックには時刻の近いデータが配置されます。したがって、2.の日単位コンテナ(テーブル)を参照し、月単位の集計を行い集計時間をROWKEY(PRIMARY KEY)とする3.のデータと、分単位の1.のデータが同一ブロックに保存される可能性があります。

メモリが小さく監視データがすべてメモリに収まらない大容量データで4.の年単位の集計処理を行う場合、ブロックが分断して配置された3.のデータをメモリに配置するために、常時必要な1.のデータがメモリから追い出されるなど、直近でないデータの読み込みにより監視したいデータがスワップアウトされる状況が発生します。

この場合、分単位、日単位、月単位などコンテナ(テーブル)のアクセス頻度に沿ったヒントを与えることで、アクセス頻度の低いデータと高いデータをデータ配置時に別ブロックに分離します。

このように、データアフィニティによってアプリケーションの利用シーンに合わせたデータ配置ができます。

【注意】

- データアフィニティは異なるパーティションに配置されたコンテナ(テーブル)に対して無効です。

特定のコンテナ(テーブル)を同じパーティションに配置したい場合は、ノードアフィニティをご利用ください。

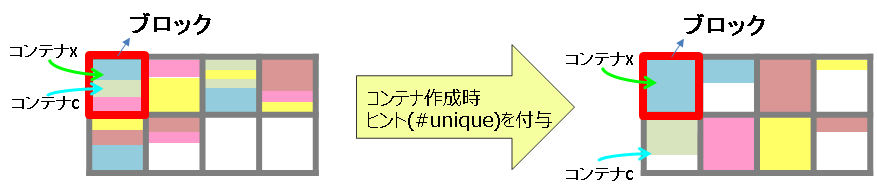

6.9.1.2 コンテナ単位で別ブロックに配置

各コンテナ(テーブル)毎にブロックを占有するための機能です。コンテナに対して固有のブロックを割り当てることで、コンテナ単位のスキャンや削除を高速化することができます。

ヒント情報として、特殊文字列「 #unique 」をコンテナ作成時にプロパティ情報へ設定してください。他のコンテナと完全に別のブロックにデータを配置します。

【注意】

- 複数コンテナアクセス時のメモリヒット率低下が発⽣する可能性があります。

6.9.2 ノードアフィニティ

ノードアフィニティとは、関連の強いコンテナやテーブルを同じノードに配置し、データアクセス時のネットワーク負荷を減少させるための機能です。GridDBのSQLではテーブルのJOIN操作が記述できます。テーブルのJOIN操作時にクラスタの別ノードに配置されたテーブルのネットワークアクセスでの負荷を減少させることができます。また、複数ノードを用いた並列処理ができなくなるため、ターンアラウンド時間の短縮には効果がない反面、ネットワーク負荷の減少によりスループットが上がる可能性があります。

ノードアフィニティを利用するには、コンテナ(テーブル)作成時にコンテナ(テーブル)名にヒント情報を与えます。ヒント情報が同一のコンテナ(テーブル)は同一のパーティションに配置されます。 以下のように指定します。

- コンテナ(テーブル)名@ノードアフィニティヒント情報

ノードアフィニティのヒント情報の命名もコンテナ(テーブル)名の命名規則と同様です。

【注意】

- テーブルパーティショニングを利用している場合は、本機能は利用できません。

6.10 コンテナ(テーブル)の定義変更

コンテナ作成後に、カラム追加などのコンテナ定義の変更を行うことができます。変更可能な操作と使用するインターフェースは以下の通りです。

| 操作 | NoSQL API | SQL |

|---|---|---|

| カラム追加(末尾) | ○ | ○ |

| カラム追加(末尾以外) | ○(※1) | × |

| カラム削除 | ○(※1) | × |

| カラム名変更 | × | ○ |

- (※1)末尾以外へのカラム追加やカラム削除の操作は、内部的にコンテナ再作成の処理を行うため、データ量が多いコンテナは処理に時間がかかります。

- 上記以外の操作(コンテナ名の変更など)はできません。

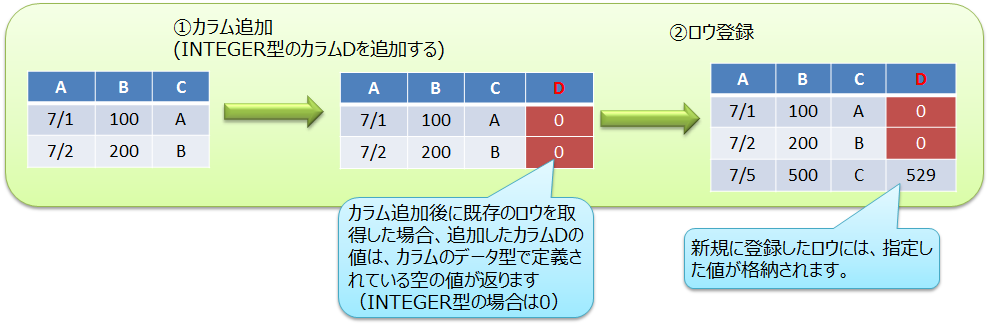

6.10.1 カラム追加

コンテナに新しいカラムを追加します。

NoSQL APIの場合

GridStore#putContainerを用いてカラム追加します。

既存コンテナからコンテナ情報情報ContainerInfoを取得し、コンテナ情報に新しいカラムをセットしてからputContainerを実行します。詳細は『GridDB Java APIリファレンス』(GridDB_Java_API_Reference.html)をご参照ください。

【プログラム例】

// コンテナ情報を取得 ContainerInfo conInfo = store.getContainerInfo("table1"); List<ColumnInfo> newColumnList = new ArrayList<ColumnInfo>(); for ( int i = 0; i < conInfo.getColumnCount(); i++ ){ newColumnList.add(conInfo.getColumnInfo(i)); } // 新しいカラムを末尾にセット newColumnList.add(new ColumnInfo("NewColumn", GSType.INTEGER)); conInfo.setColumnInfoList(newColumnList); // カラム追加 store.putCollection("table1", conInfo, true);

SQLの場合

- ALTER TABLE構文を用いてカラム追加します。

- 末尾へのカラム追加の操作のみできます。詳細は『GridDB SQLリファレンス』(GridDB_SQL_Reference.html)をご参照ください。

カラムを追加した後に既存ロウを取得した場合、追加カラムの値はカラムのデータ型ごとに定義されている「空の値」が返ります。空の値の詳細は『GridDB Java APIリファレンス』(GridDB_Java_API_Reference.html)のContainer<K,R>をご参照ください。 (V4.1では、制限事項「カラム追加後に既存のロウを参照した時、NOT NULL制約が付いていないカラムはNULLが返る」があります。詳細は『GridDB リリースノート』(GridDB_ReleaseNotes.html)の制限事項の項目をご参照ください。)

6.10.2 カラム削除

コンテナのカラムを削除します。NoSQL APIのみで操作できます。

- NoSQL API

- GridStore#putContainerを用いてカラム削除します。既存コンテナからコンテナ情報ContainerInfoを取得し、削除対象のカラム情報を除いてからputContainerを実行します。詳細は『GridDB Java APIリファレンス』(GridDB_Java_API_Reference.html)をご参照ください。

6.10.3 カラム名変更

コンテナのカラム名を変更します。SQLのみで操作できます。

- SQL

- ALTER TABLE構文を用いてカラム名を変更します。詳細は『GridDB SQLリファレンス』(GridDB_SQL_Reference.html)をご参照ください。

6.11 データベース圧縮/解放機能

6.11.1 データブロック圧縮

GridDBは、メモリ上のデータをデータベースファイルに書き込むことで、メモリサイズに依存しない大容量化を実現できますが、ストレージのコストは増加します。データブロック圧縮機能は、データベースファイル(データファイル)を圧縮することで、データ量に伴って増加するストレージコストの削減を支援する機能です。 特に、HDDと比べ容量単価が高いフラッシュメモリをより効率的に活用できます。

圧縮方法

メモリ上のデータをデータベースファイル(データファイル)に書き出す際に、GridDBの書き出し単位であるブロック毎に圧縮操作を行います。圧縮により空いた領域は、Linuxのファイルブロック割り当て解除処理を行うため、ディスク使用量を削減できます。

サポート環境

データブロック圧縮はLinuxの機能を利用しているため、Linuxカーネルバージョンとファイルシステムに依存します。データブロック圧縮のサポート環境は以下です。

- OS: RHEL / CentOS 7.9以上, Ubuntu Server 20.04

- ファイルシステム:XFS

- ファイルシステムのブロックサイズ:4KB

※上記以外の環境でデータブロック圧縮を有効にした場合、GridDBノードの起動に失敗します。

圧縮アルゴリズム

データブロック圧縮は以下の2種類のアルゴリズムから選択することができます。

- ZLIB圧縮: ZLIBライブラリによる圧縮 (V5.6より古いバージョンから使用できる圧縮アルゴリズム)

- ZSTD圧縮: ZSTD(Zstandard)ライブラリによる圧縮(V5.6から選択可能)。ZLIB圧縮より圧縮解凍速度や圧縮率で優れています。

設定方法

GridDBノードごとに圧縮機能を設定します。

ノード定義ファイル(gs_node.json)の/dataStore/storeCompressionModeに以下の文字列を設定します。

| 設定する文字列 | 意味 |

|---|---|

| "NO_COMPRESSION" | 圧縮機能を無効にする(既定値) |

| "COMPRESSION_ZLIB" または "COMPRESSION" | ZLIB圧縮機能を有効にする |

| "COMPRESSION_ZSTD" | ZSTD圧縮機能を有効にする |

- GridDBノード起動時(再起動時)に設定を適用します。

- GridDBノードを再起動することで、圧縮機能の動作を有効/無効に変更することができます。

【注意】

- データブロック圧縮の対象は、データファイルのみです。チェックポイントログファイル、トランザクションログファイル、バックアップファイル、およびGridDBのメモリ上のデータは圧縮しません。

- データブロック圧縮により、データファイルはスパースファイルになります。

- 圧縮機能を有効に変更しても、すでにデータファイルに書き込み済みのデータは圧縮できません。

- ZSTD圧縮機能を一度でも有効にした場合、そのデータファイルはV5.6より古いバージョンのサーバではオープンできません。GridDBのバージョンアップ後、ZSTD圧縮機能を有効にする前にはデータベースのバックアップをとることを推奨します。

6.11.2 データブロック未使用領域解放

データブロック未使用領域解放機能は、データベースファイル(データファイル)の使用されていないブロック領域に対して、Linuxのファイルブロック割り当て解除処理を行い、データベースファイルのサイズ(実ディスク割当量)を縮小することができる機能です。

以下のようなケースにおいて、ディスク使用量を削減したい場合にご利用ください。

- データを大量に削除した場合

- 今後データ更新の予定が無く、DBを長期保存するような場合

- データ更新時にディスクフルになり、回避する暫定手段としてDBサイズ縮小が必要な場合

未使用領域を解放する処理や、本機能のサポート環境、実行方法について説明します。

解放処理

GridDBノード起動時に、データベースファイル(データファイル)の未使用領域を解放します。 解放された領域は、新たなデータ更新が発生しない限りディスク領域は割り当てられません。

サポート環境

サポート環境は、データブロック圧縮機能と同じです。

実行方法

GridDBノード起動時に、gs_startnodeコマンドでデータブロック未使用領域解放オプション(--releaseUnusedFileBlocks)を指定します。

データベースファイル(データファイル)の未使用領域サイズとディスク割当サイズは、下記の方法で確認してください。

- gs_statコマンドで表示される項目

storeTotalUse

ノードがデータファイルで保有する全データ容量(バイト)

dataFileAllocateSize

データファイルに割り当てられたブロックの総サイズ(バイト)

データブロック未使用領域解放機能の実施目安としては、データブロック未使用領域が多い(上記の値の比較で、storeTotalUse ≪ dataFileAllocateSize) 場合です。

【注意】

- 本機能の対象は、データファイルのみです。チェックポイントログファイル、トランザクションログファイル、バックアップファイルの未使用領域は解放しません。

- 本機能を実施すると、データファイルはスパースファイルになります。

- データファイルのディスク使用量は削減できますが、スパースファイルになることでフラグメントが発生しやすくなり、性能面ではデメリットになる可能性があります。

- 起動時に領域解放処理が行われるため、通常の起動処理より時間がかかる場合があります。

6.12 クラスタパーティション配置

GriDBは複数のノードにクラスタパーティションを多重化して配置します。クラスタパーティション内のコンテナに対して更新操作ができるノードが「オーナノード」、参照操作のみ可能なノードが「バックアップノード」であり、これら割付をクラスタ全体で決定したものを「クラスタパーティション配置表」と呼びます。

クラスタパーティション配置表はクラスタ構成時にサーバによって決定されますが、構成に関する以下の指定を行うことができます。

生成規則の指定

- クラスタパーティション配置表の生成規則(アルゴリズム)が指定できます。

配置表の固定化指定

- 現在のクラスタ構成をクラスタパーティション配置表ファイルとして出力し、それを用いて固定化することができます。

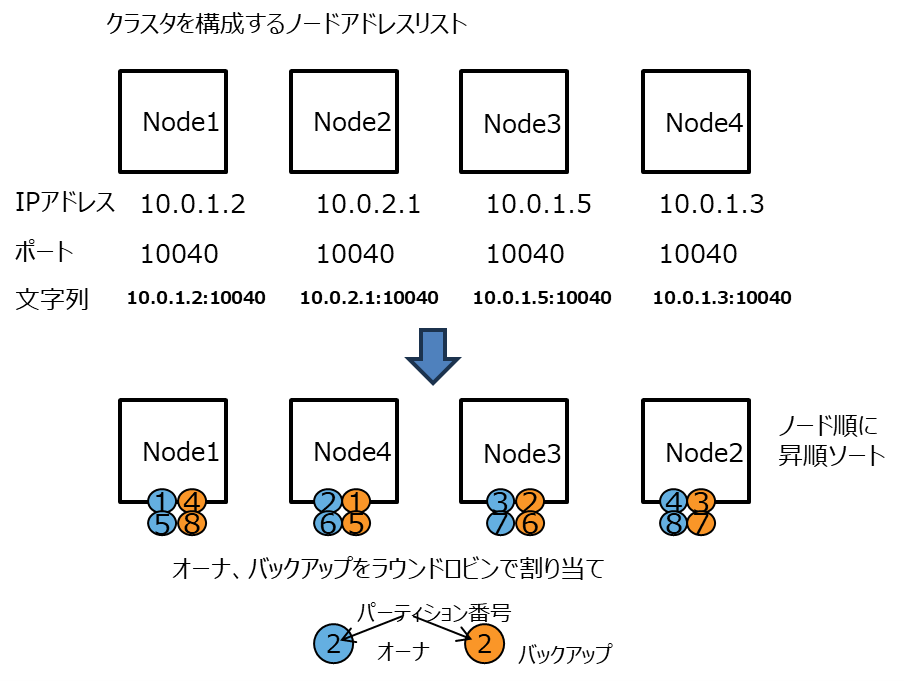

6.12.1 生成規則の指定

サーバが決定するクラスタパーティション配置表の生成規則として以下のいずれかを指定できます。

デフォルト規則(DEFAULT)

- その時点の各ノードのオーナ、バックアップの個数が均等になるように配置します。

- その時点で保持しているデータ量を参照します。

- 同じ構成であっても、その時点の状況により配置表が異なる場合があります。

ラウンドロビン規則(ROUNDROBIN)

- その時点の各ノードのオーナ、バックアップの個数が均等になるように配置します。

- オーナ、バックアップをできるだけ偏りなく、スレッド処理効率が良いように配置しますが、データ量は参照しません。

- 同じ構成であっても、その時点の状況により配置表が異なる場合があります。

ラウンドロビン規則では以下の規則で配置表を作成します。

- クラスタを構成する各ノードの、ノードアドレス:ポート番号を文字列化して昇順に並べたノード順序を決定します。

- クラスタパーティション番号の0番から昇順に、ノード順序に従いラウンドロビンでオーナを決定します。

- クラスタパーティション番号の0番から2)で決定したオーナのノード番号+1を基点に、ラウンドロビンでレプリカ数分のバックアップを決定します。

4台クラスタ構成、クラスタパーティション数8のサンプルを以下に示します。

(メモ)

GridDBのバージョンV5.6以降の機能であり、V5.6以前は自動的にDEFAULTが適用されます。

ノード定義ファイル(gs_node.json)の以下のパラメータで設定します。

| 設定パラメータ | 初期値 | パラメータの意味と制限値 | 変更 |

|---|---|---|---|

| /cluster/goalAssignmentRule | DEFAULT | クラスタパーティション配置表の生成規則を指定します。 DEFAULT、ROUNDROBINのいずれかを指定します |

起動 |

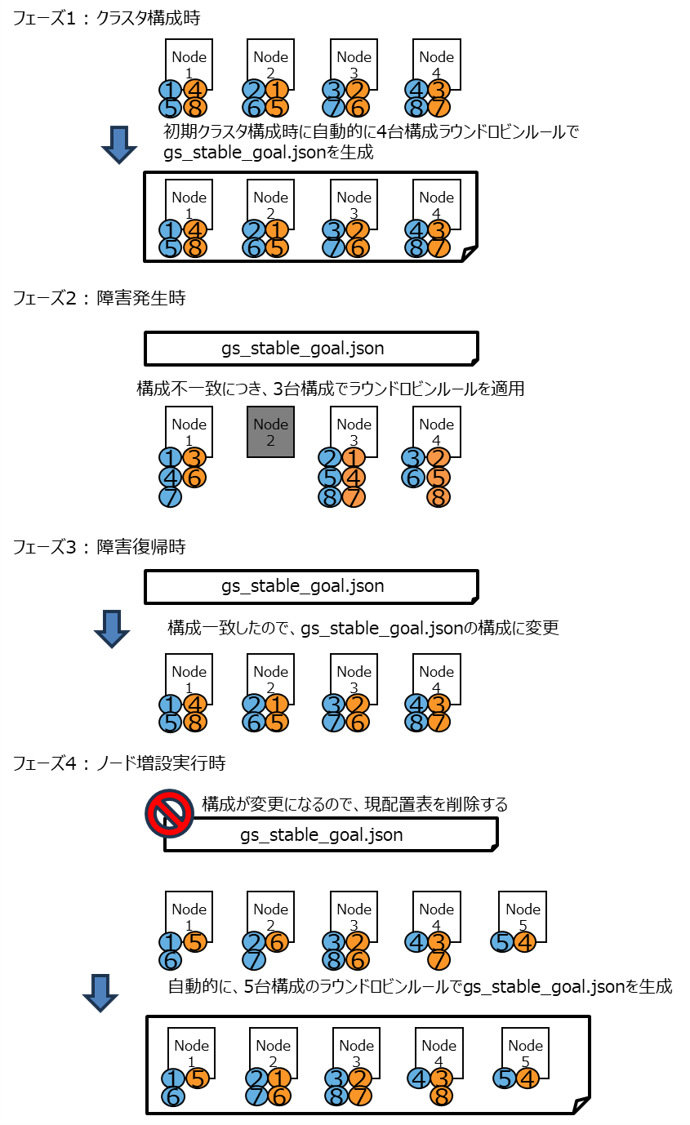

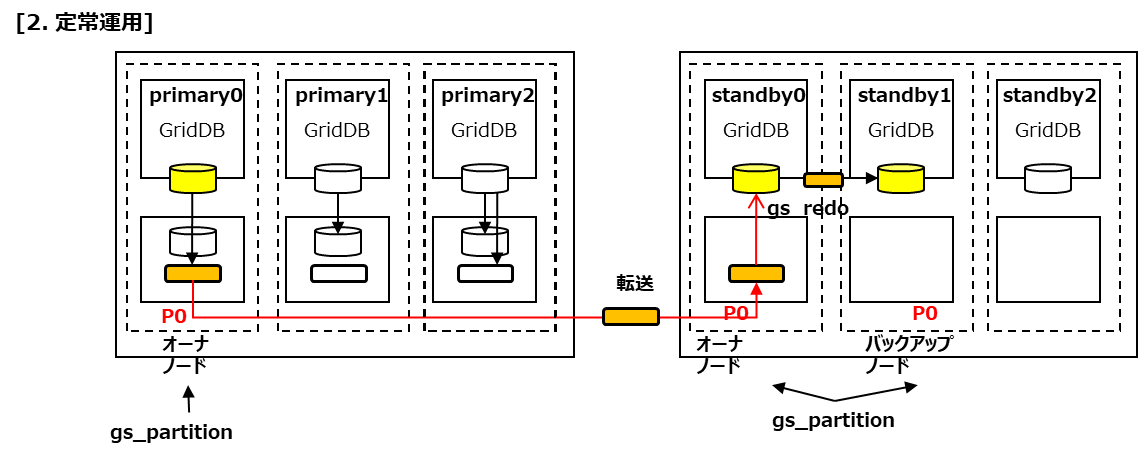

6.12.2 配置表の固定化指定

初回に構成されるクラスタ構成をクラスタパーティション配置表ファイルとして出力し、それを用いてクラスタパーティションを固定化することができます。出力される配置表となるファイルは以下となります。

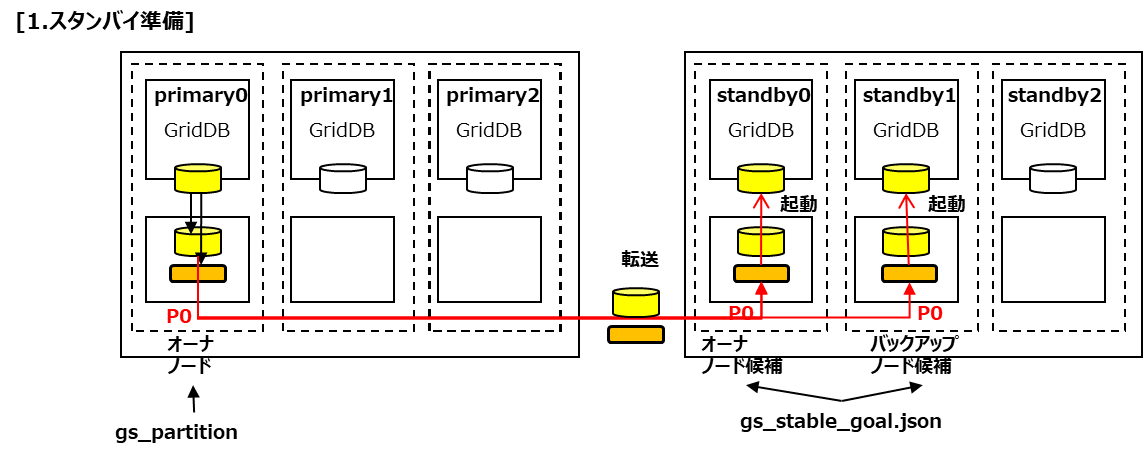

- ファイル名:gs_stable_goal.json

- 配置ディレクトリ:各種ノード起動ファイルと同じディレクトリ

- 形式 : json形式

- 内容 : 各パーティションのオーナとバックアップを定義したもの

サンプルを以下に示します。

[

{

"backup": [{"address": "192.168.11.11","port": 10010}],

"owner": {

"address": "192.168.11.10",

"port": 10010

},

"pId": "0",

},

:

]

本機能を利用する場合は以下の手順を行ってください。

- gs_node.jsonの/cluster/enableStableGoalに値trueを追加します。

- クラスタを初回構成する際は、gs_stable_goal.jsonがgs_node.jsonと同じディレクトリにあれば削除した後にクラスタ起動を行ってください。

本配置表の読み込みおよび生成されるタイミングは以下の通りです。

- 初回のクラスタ構成

- ノード構成の変更時(増設/縮退)

- ノードの一時的な障害/復帰

配置表ファイルが指定フォルダに既に存在する場合は上記タイミングでも「上書き更新」は行われません。また、上記タイミングでの現在のノード構成が配置表ファイルに記載された構成と異なる場合は配置表ファイルを用いず、現在のノード構成において6.1.1で指定した生成規則に従った配置表が適用されます。

クラスタのノード増設やノード縮退を行う場合は操作前に配置表ファイルを削除した後にクラスタ操作を実行すると、自動的に新しい構成に従った配置表ファイルを生成することができます。

(メモ)

GridDBのバージョンV5.6以降の機能となります。

ノード定義ファイル(gs_node.json)の以下のパラメータで設定します。

| 設定パラメータ | 初期値 | パラメータの意味と制限値 | 変更 |

|---|---|---|---|

| /cluster/enableStableGoal | false | クラスタパーティション配置表固定化の利用有無を指定します。 | 起動 |

クラスタパーティション数=8, ノード数=4、生成規則「ROUNDROBIN」を指定した場合のサンプルを以下に示します。初期クラスタ構成時に、4台構成のラウンドロビンに従った配置表となるgs_stable_goal.jsonが自動生成されます。障害発生時は、「ROUNDROBIN」規則による3台構成の配置となります。1ノード増設のタイミングで、gs_stable_goal.jsonを削除しておけば、5台構成のラウンドロビン配置表が新たに生成されます。

7 運用機能

7.1 サービス制御

OSの起動と同時にGridDBをサービスとして動作させるサービス制御機能があります。

GridDBのサービスは、パッケージのインストール直後からサービスが有効となっています。サービスが有効となっているため、OS起動と同時にGridDBのサーバが起動され、OS停止時はサーバが停止されます。

OSの監視やデータベースソフトウェアの動作を含めたミドルウェアやアプリケーションの運用を統合化したインターフェースを用いる場合、サービス制御の機能を用いるのか、もしくは運用コマンドを利用するのか、サービスの起動停止の他ミドルウェアとの依存性も検討する必要があります。

GridDBのサービスは、OS起動時に自動的に実行され、GridDBノード(以下、ノード)を起動し、 GridDBクラスタ(以下、クラスタ)へ参加します。OSのシャットダウン時には、クラスタから離脱し、ノードを停止します。

サービスにより、次のことができます。

- ノードの起動、停止、再起動

- ノードのプロセス状態確認

ノード3台のクラスタに対するサービス操作の手順は以下の通りです。

サービスを利用してクラスタを開始する場合

ノード3台が停止している状態から、サービスを利用してクラスタを開始します。

ユーザの操作 ノードAの状態 ノードBの状態 ノードCの状態 - ノード停止 ノード停止 ノード停止 ①ノードA/B/Cのサービス開始を実行 ノード起動

クラスタに参加ノード起動

クラスタに参加ノード起動

クラスタに参加- サービス開始は、OS起動時には自動的に実行されます。

- サービス開始によってクラスタを開始するためには、サービスの起動設定ファイルにクラスタの構成ノード数やクラスタ名を定義している必要があります。

- 定義した構成ノード数のノードがクラスタに参加した時点で自動的にクラスタが開始されます。

サービスを利用してノードを1台停止する場合

クラスタ稼動している状態から、サービスを利用してノードを1台停止します。

ユーザの操作 ノードAの状態 ノードBの状態 ノードCの状態 - クラスタに参加 クラスタに参加 クラスタに参加 ①ノードBのサービス停止を実行 クラスタに参加 クラスタから離脱

ノード停止クラスタに参加

サービスを利用してクラスタを停止する場合

クラスタ稼動している状態から、サービスを利用してクラスタを停止します。

ユーザの操作 ノードAの状態 ノードBの状態 ノードCの状態 - クラスタに参加 クラスタに参加 クラスタに参加 ①クラスタ停止を実行(※注意) クラスタから離脱 クラスタから離脱 クラスタから離脱 ②ノードA/B/Cのサービス停止を実行 ノード停止 ノード停止 ノード停止

【注意】

- クラスタ全体を停止する時は、必ずgs_stopclusterコマンドを実行してから、サービスのstopで各ノードを離脱・停止してください。 gs_stopclusterコマンドでクラスタを停止しなかった場合、ノードの離脱のたびにデータ再配置が行われる可能性があります。データ再配置が頻繁に発生すると、ネットワークやディスクI/Oに負荷がかかる場合があります。クラスタを停止してからノードを離脱した場合はデータ再配置は行われません。不要なデータ再配置を防ぐために、必ずクラスタを停止してください。クラスタの停止は、運用コマンドgs_stopclusterや、統合運用管理gs_admin、gs_shなどを用いて実行してください。

なお、サービス制御を使用しない場合、以下のようにすべてのランレベルでサービスを無効にします。

# /sbin/chkconfig gridstore off

7.2 ユーザ管理機能

GridDBのユーザには、インストール時に作成されるOSユーザとGridDBの運用/開発を行うGridDBのユーザ(以降GridDBユーザと呼ぶ)の2種類があります。

7.2.1 OSユーザ

OSユーザは、GridDBの運用機能を実行できる権限を持つユーザであり、GridDBインストール時にgsadmというユーザが作成されます。以降このOSユーザをgsadmと呼びます。

GridDBのリソースはすべて、gsadmの所有物となります。また、GridDBの運用操作のコマンド実行はすべてgsadmで実行します。

運用操作では、GridDBサーバに接続し運用操作を実行できる権限を持ったユーザか否かの認証を行います。この認証は、GridDBユーザで行います。

7.2.2 GridDBユーザ

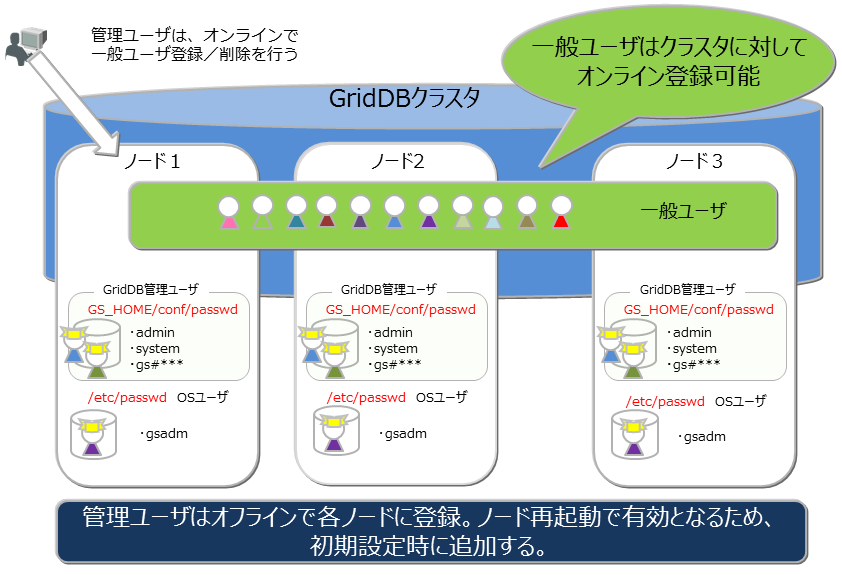

管理ユーザと一般ユーザ

GridDBのユーザには、管理ユーザと一般ユーザの2種類があり、利用できる機能に違いがあります。GridDBインストール直後には、デフォルトの管理ユーザとして、system、adminの2ユーザが登録されています。

管理ユーザは、GridDBの運用操作を行うために用意されたユーザであり、一般ユーザはアプリケーションシステムで利用するユーザです。

セキュリティの面から、管理ユーザと一般ユーザは利用用途に応じて使い分ける必要があります。

ユーザの作成

管理ユーザは、gsadmが登録/削除することができ、その情報は、GridDBのリソースとして定義ファイルディレクトリのpasswordファイルに保存されます。管理ユーザは、OSのローカルファイルに保存/管理されるため、クラスタを構成する全ノードで同一の設定となるように、配置しておく必要があります。また、管理ユーザは、GridDBサーバ起動前に設定しておく必要があります。起動後に登録しても有効にはなりません。

一般ユーザは、GridDBのクラスタ運用開始後に管理ユーザが作成します。クラスタサービス開始前に一般ユーザの登録はできません。一般ユーザはGridDBのクラスタ構成後に作成し、GridDBデータベース内の管理情報として保持するため、クラスタに対して運用コマンドを用いて登録するのみです。

管理ユーザについては、クラスタ間での自動的な情報伝達は行われないため、定義ファイルのマスタ管理ノードを決めマスタ管理ノードからクラスタを構成する全ノードに配布管理するなどの運用管理を行い、全ノードで同じ設定とする必要があります。

ユーザ作成時の規則

ユーザ名には命名規則があります。

管理ユーザ:『gs#』で始まるユーザを指定します。『gs#』以降は英数字およびアンダースコアのみで構成します。大文字と小文字は同一として扱うため、gs#managerとgs#MANAGERは同時には登録できません。

一般ユーザ:英数字およびアンダースコアで指定します。ただし、先頭文字に数字は指定できません。また、大文字と小文字は同一として扱うため、userとUSERは同時には登録できません。管理ユーザのデフォルトユーザである、system,adminは作成できません。

パスワード:指定できる文字に制限はありません。

なお、ユーザ名およびパスワードに指定できる文字列は、それぞれ64文字です。

7.2.3 利用できる機能

管理ユーザができる運用操作と一般ユーザが利用できる操作を以下に示します。運用操作のうちGridDBユーザを用いずに、gsadmで実行可能なコマンドは◎印で明記します。

| 操作 | 操作詳細 | 利用する運用ツール | gsadm | 管理ユーザ | 一般ユーザ |

|---|---|---|---|---|---|

| ノード操作 | ノードの起動 | gs_startnode/gs_sh | ○ | × | |

| ノードの停止 | gs_stopnode/gs_sh | ○ | × | ||

| クラスタ操作 | クラスタの構築 | gs_joincluster/gs_sh | ○ | × | |

| クラスタへのノード増設 | gs_appendcluster/gs_sh | ○ | × | ||

| クラスタからのノード離脱 | gs_leavecluster/gs_sh | ○ | × | ||

| クラスタの停止 | gs_stopcluster/gs_sh | ○ | × | ||

| ユーザ管理 | 管理ユーザ登録 | gs_adduser | ◎ | × | × |

| 管理ユーザの削除 | gs_deluser | ◎ | × | × | |

| 管理ユーザのパスワード変更 | gs_passwd | ◎ | × | × | |

| 一般ユーザの作成 | gs_sh | ○ | × | ||

| 一般ユーザの削除 | gs_sh | ○ | × | ||

| 一般ユーザのパスワード変更 | gs_sh | ○ | ○:本人のみ | ||

| データベース管理 | データベースの作成・削除 | gs_sh | ○ | × | |

| データベースへのユーザ割り当て/解除 | gs_sh | ○ | × | ||

| データ操作 | コンテナやテーブルの作成・削除 | gs_sh | ○ | ○:本人のDB内で更新操作が可能な場合のみ | |

| コンテナやテーブルへのデータ登録 | gs_sh | ○ | ○:本人のDB内で更新操作が可能な場合のみ | ||

| コンテナやテーブルの検索 | gs_sh | ○ | ○:本人のDB内のみ | ||

| コンテナやテーブルへの索引操作 | gs_sh | ○ | ○:本人のDB内で更新操作が可能な場合のみ | ||

| バックアップ管理 | バックアップ作成 | gs_backup | ○ | × | |

| バックアップ管理 | バックアップリストア | gs_restore | ◎ | × | × |

| バックアップリスト | gs_backuplist | ○ | × | ||

| システムステータス管理 | システム情報の取得 | gs_stat | ○ | × | |

| パラメータ変更 | gs_paramconf | ○ | × | ||

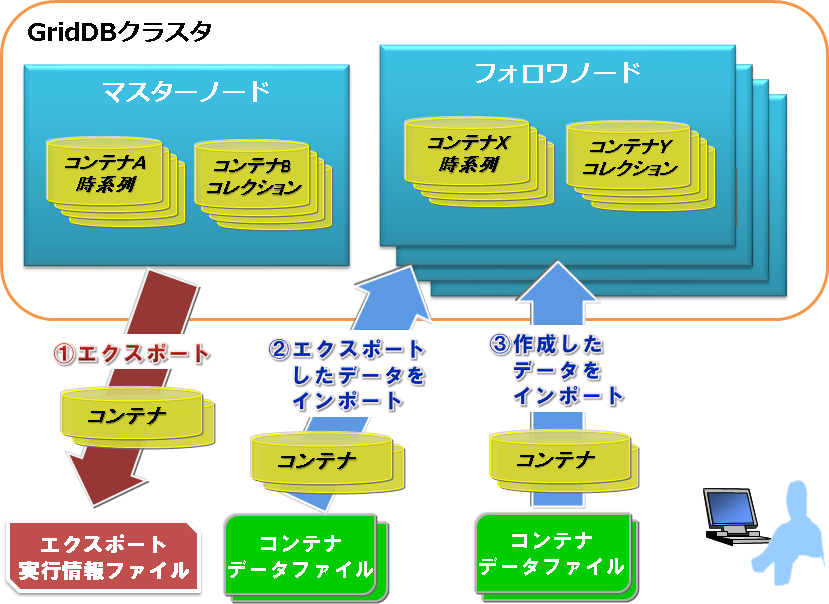

| データインポート/ | データのインポート | gs_import | ○ | ○:アクセスできる範囲 | |

| エクスポート | データのエクスポート | gs_export | ○ | ○:アクセスできる範囲 |

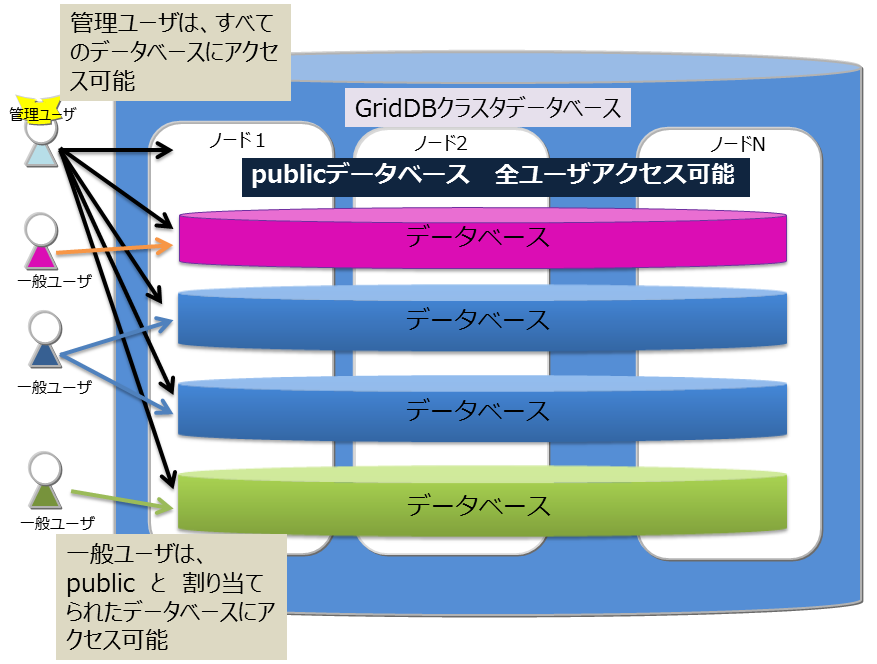

7.2.4 データベースとユーザ

GridDBのクラスタデータベース(以降クラスタデータベースと呼びます)を利用ユーザ単位にアクセスを分離することができます。分離する単位を データベース と呼びます。 データベースは、クラスタデータベースの初期状態では以下のデータベースがあります。

- public

- 管理ユーザ、一般ユーザのすべてがアクセスできるデータベースです。

- 接続先データベースを指定せずに接続した場合はこのデータベースが利用されます。

データベースはクラスタデータベースに複数作成することができます。データベースの作成、削除、ユーザへの割り当ては管理ユーザが行います。

データベース作成時の規則は以下に示すとおりです。

- クラスタデータベースに作成できるユーザ数、データベース数の上限は各々128個までです。

- データベース名に指定可能な文字列は、英数字およびアンダースコア_、ハイフン-、ドット.、スラッシュ/、イコール=です。ただし、先頭文字に数字は指定できません。

- データベース名に指定できる文字列は、64文字です。

- データベース名命名時の大文字・小文字は保持されますが、大文字小文字同一視した場合に同一名となるデータベースは作成できません。例えば、databaseとDATABASEは同時には登録できません。

- デフォルトデータベースである「public」および「information_schema」は指定できません。

データベースへ一般ユーザを割り当てる際、権限を指定します。権限は以下の種類があります。

- ALL

- コンテナ作成やロウ登録、検索、索引作成などコンテナに関するすべての操作が可能

- READ

- 検索の操作のみ可能

データベースにアクセスできるのは割り当てた一般ユーザと管理ユーザのみです。管理ユーザはすべてのデータベースにアクセスすることができます。 データベースへ一般ユーザを割り当てる際、以下規則があります。

- 1データベースに複数の一般ユーザを割り当てることができる

- データベースに一般ユーザを割り当てる際、指定できる権限は1種類のみ

- 1データベースに複数の一般ユーザを割り当てる際、ユーザごとに異なる権限を指定することができる

- 1ユーザには複数のデータベースを割り当てることができる

7.2.5 認証方式

GridDBの認証方式には、以下があります。

- 内部認証

- LDAP認証

各方式について、説明します。

7.2.5.1 内部認証

GridDBの管理/一般ユーザのユーザ名、パスワード、および権限をGridDBで管理します。認証方式を指定しない場合、内部認証がデフォルトです。

管理ユーザは、運用コマンドのgs_adduser/gs_deluser/gs_passwdで管理します。

一般ユーザは、SQLのCREATE USER/DROP USER/SET PASSWORD文で管理します。また、一般ユーザのアクセス権は、SQLのGRANT/REVOKE文で管理します。

ユーザキャッシュ設定

一般ユーザ情報のキャッシュの設定は、以下のノード定義ファイル(gs_node.json)を編集します。

【注意】

- 変更内容を反映するには、再起動が必要です。

| パラメータ | デフォルト | 設定値 |

|---|---|---|